テキストに加えてメロディやテンポなど時間的変化がある要素もコントロール可能な音楽生成モデル「Music ControlNet」が開発される

近年はテキストから音楽を生成するAIツールが進歩を遂げ、さまざまなスタイルで高品質の音楽を生成できるようになっていますが、従来のテキストによる生成ではビートの位置や音楽のダイナミクス(強弱)など、時間と共に変化する属性を制御するのが難しかったとのこと。そこでカーネギーメロン大学とAdobe Researchの研究チームが、複数の時間的変化コントロールを可能にする音楽生成モデル「Music ControlNet」を発表しました。

[2311.07069] Music ControlNet: Multiple Time-varying Controls for Music Generation

https://arxiv.org/abs/2311.07069

Music ControlNet

https://musiccontrolnet.github.io/web/

以前からテキストを基に音楽を生成するAIモデルは多数登場しており、Metaはテキストから音楽や効果音を生成するオープンソースツール「AudioCraft」も発表しています。しかし、研究チームは「テキストによるコントロールは主に、ジャンルやムード、テンポといった全体的な音楽属性の操作に適しており、ビートの時間的な配置や音楽の強弱の変化など、時間と共に変化する属性を正確に制御するにはあまり適していません」と述べています。

そこで研究チームは、オーディオについて複数の時間的属性のコントロールを提供する拡散モデルをベースにした音楽生成モデル「Music ControlNet」を開発しました。Music ControlNetでは、テキストから音楽を生成するモデルに時間的制御を組み込むために、「ControlNet」というニューラルネットワークに類似したアプローチを採用しているとのこと。

ControlNetは事前学習済みのモデルに対して輪郭線や深度、画像の領域区分(セグメンテーション)情報などを追加して出力をサポートする技術で、画像生成モデルと組み合わせることで生成画像の品質を向上させることができます。研究チームはこれを画像ではなく、音楽を生成するモデルに適用したというわけです。

「Music ControlNet」がどのような音楽生成モデルになっているのかは、以下の動画を見るとわかります。

Music ControlNet: Multiple Time-varying Controls for Music Generation - YouTube

従来のテキストから音楽を生成するモデルでは、単に「Powerful rock(パワフルなロック)」といったテキストを基に、それらしい音楽をAIが生成していました。

Music ControlNetはこれに加え、メロディやリズム、ダイナミクスといった時間的属性をコントロールする能力を備えた、新しい音楽生成モデルです。

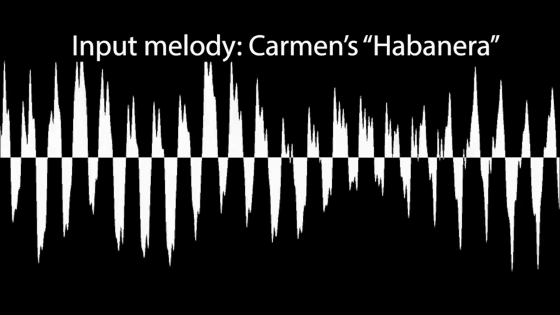

Music ControlNetではテキストだけでなく、好きなメロディを入力することができます。動画では例として、カルメンの「ハバネラ」のメロディを入力しています。

入力したメロディと「Angry, Hip-hop(怒り、ヒップホップ)」のようなテキストを組み合わせて、メロディを維持したままヒップホップ調に仕上げることが可能です。

メロディはそのままに、「Sexy, Electronic(セクシー、エレクトロニック)」のようにテキストを変えることもできます。

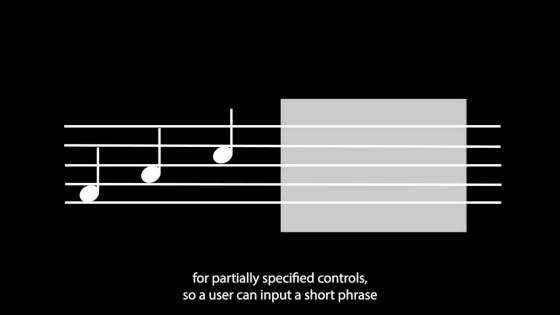

また、Music ControlNetでは音楽の一部分のみをコントロールし、残りをAIに任せることもできるとのこと。

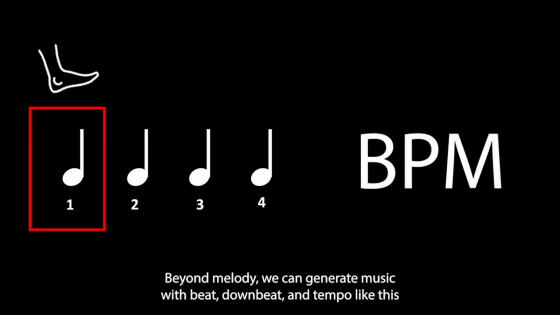

テンポやビート、BPMを調整することも可能です。

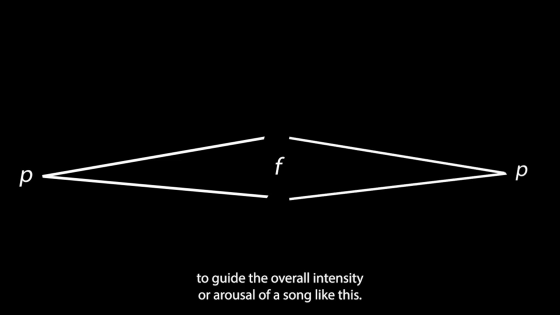

音楽のダイナミクスを指定することもできます。

だんだん強くなっていくように指示したところ、最初は控えめな曲調で始まります。

そして、次第に曲調が激しくなりました。

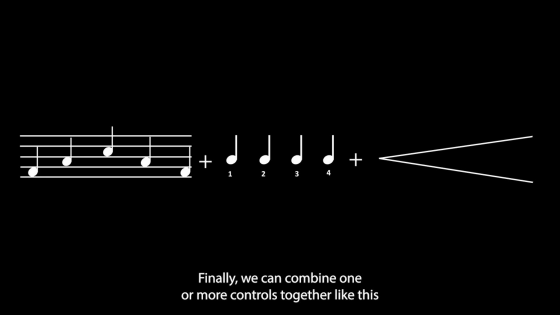

複数の要素を同時にコントロールすることもできます。

・関連記事

Metaが音楽生成AIモデルをオープンソースで公開、テキスト&音声入力で誰でも高品質な音楽を作成できるように - GIGAZINE

AIで作った「AI音楽」が流行、Discord上には2万人超が集まる人気サーバーも - GIGAZINE

テキストで指定した音楽を自動で生成するAI「Stable Audio」が登場 - GIGAZINE

「AIが生成した数万もの楽曲」を音楽ストリーミングサービスのSpotifyが削除、不正な再生数の水増しが原因か - GIGAZINE

テキストから音楽や効果音を生成するためのオープンソースなAIツール「AudioCraft」をMetaが発表 - GIGAZINE

「AIのトレーニングに楽曲が使用されるのを阻止してほしい」とユニバーサルミュージックグループがSpotifyやApple Musicに要求 - GIGAZINE

YouTubeが「ミュージシャンの声を使った動画を作成するためのAIツール」のリリースに向けてメジャーレーベルと協議を進めている - GIGAZINE

YouTubeが「アーティストや作品を守りながらAIを活用するための3原則」を大手音楽企業と提携して発表 - GIGAZINE

ポーズや構図を指定してサクッと好みのイラスト画像を生成しまくれる「ControlNet」&「Stable Diffusion」の合わせ技を試してみたよレビュー - GIGAZINE

画像生成AI「Stable Diffusion」をMulti ControlNetで制御して「実写映像を忠実にアニメ化」したムービーがすごい - GIGAZINE

・関連コンテンツ

in ソフトウェア, 動画, Posted by log1h_ik

You can read the machine translated English article A music generation model ``Music Control….