AI成果物が急増したことで「AI生成コンテンツをAIが学習するループ」が発生し「モデルの崩壊」が起きつつあると研究者が警告

Adobeが権利的にクリアなトレーニングモデルを用いた画像生成AI「Firefly」を発表したり、Microsoftの検索エンジンであるEdgeで対話型AIのChatGPTが活躍していたり、世界的なコンサル企業が「社員の50%は業務にジェネレーティブAIを活用している」と明らかにしたりと、ジェネレーティブAIは社会に広がり続けています。しかし、AIを使用してコンテンツを作成・公開する人が増えていることで、新たな問題として「AIが生成したコンテンツがインターネット上にあふれ、それをAIが学習することで、重大な欠陥が生まれている」ということが研究者グループから指摘されています。

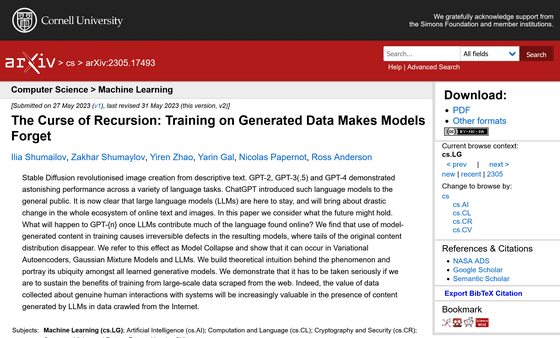

[2305.17493] The Curse of Recursion: Training on Generated Data Makes Models Forget

https://doi.org/10.48550/arXiv.2305.17493

The AI feedback loop: Researchers warn of 'model collapse' as AI trains on AI-generated content | VentureBeat

https://venturebeat.com/ai/the-ai-feedback-loop-researchers-warn-of-model-collapse-as-ai-trains-on-ai-generated-content/

文章(プロンプト)を入力するだけで高精度な画像を生成できる「Stable Diffusion」や対話形式で高精度な文章を作成する「ChatGPT」といった「ジェネレーティブAI」が急速に広まった要因には、大規模言語モデル(LLM)が重要な役割を果たしています。柔軟で適応性の高いLLMと合わせて、大量のトレーニングデータを収集することで、AIは画像や文章の仕組みを覚えていきます。

画像や文章の生成などを行う「ジェネレーティブAI」はなぜ急に発展したのか? - GIGAZINE

もともと、LLMやその他のトレーニングに用いられるデータは、書籍やインターネットの記事、写真やイラストなど人間が過去に人工知能の助けを借りずに作成していたものです。しかし、ジェネレーティブAIの発展に伴い、AIでコンテンツを作成してインターネット上に公開する人が増えた影響で、学習の元となるトレーニングデータに影響が出ていると懸念されています。イギリスとカナダの研究者グループは2023年5月末、「再帰の呪い」と題した論文をオープンアクセスジャーナルのarXivに発表しました。論文では、「ジェネレーティブAI技術の将来にとって、憂慮すべき事実が明らかになっています」と述べられています。

論文の主要著者の一人であるイリア・シュマイロフ氏は、「テキストからテキストへのジェネレーティブAIモデルと、画像から画像へのジェネレーティブAIモデルの確率分布に注目した結果、長期学習にとってほぼ理想的な条件の場合であっても、『データの分散』のプロセスは避けられません。時間が経過するにつれて、生成されたデータの誤りが積み重なっていき、最終的には生成されたデータから学習することでAIが現実をさらに誤って認識することになります」と説明しています。シュマイロフ氏によると、学習モデルは最初に学習した元のデータをすぐに忘れてしまう可能性があるとのことで、「私たちは、モデルの崩壊がどれほど早く起こるかを観察して驚きました」と話しています。

また、同じく論文の著者の一人であるケンブリッジ大学とエディンバラ大学でセキュリティ工学教授を務めるロス・アンダーソン氏は、自身のブログでこの研究について語っています。アンダーソン氏は、ジェネレーティブAIの学習モデルが再帰して不正確になっていく状態を「私たちは海にプラスチックのゴミをまき散らし、大気を二酸化炭素で満たしたのと同じように、インターネットをどうしようもない情報で埋め尽くそうとしています。LLMは火のようなもので、便利なツールですが、環境を汚染します」と表現しています。

またアンダーソン氏は、インターネット上のコンテンツにAIを用いて生成されたコンテンツが増えるため、ウェブをスクレイピングして新しいモデルをトレーニングすることが難しくなり、結果として既に十分なトレーニングデータを得た企業や人間が生成したコンテンツを大規模に管理できる企業が一方的に有利になると指摘しています。実際に、AIスタートアップがクリーンなトレーニングデータを求めて、インターネットアーカイブに大規模なアクセスリクエストを行ったことが、インターネットアーカイブのブログで明らかになっています。

AIコンテンツによって学習データが崩壊していくメカニズムを、シュマイロフ氏は「データの偏り」によるものだと説明しています。シュマイロフ氏によると、人間によって生成された元データは世界をより公平に表している一方で、ジェネレーティブAIモデルは人気のあるデータを過剰に優先する傾向があり、あまり人気のないデータを誤解したり、誤って表現したりすることが多々あるとのこと。

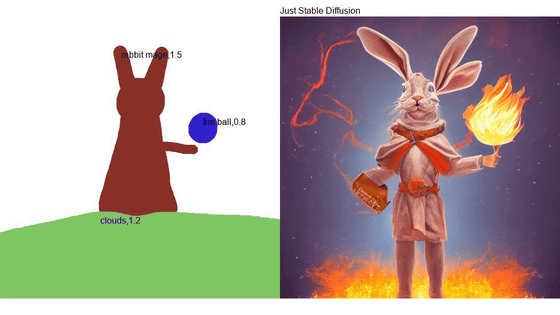

例えば、90匹の黄色い毛皮のネコと10匹の青い毛皮のネコを合わせた100匹のネコの写真を学習させた場合、モデルは「黄色のネコがより一般的」ということを学習すると同時に、「青いネコも黄色がかって表現」することがあるほか、新しいデータを出力する際に「緑色のネコ」を出力する場合があります。AIが生成した「黄色がかった青いネコ」「緑色のネコ」をさらに学習するトレーニングサイクルを行うと、青いネコは次第に黄色の色味を増していき、最終的に全てのネコが黄色に変わっていきます。このように、進行プロセスでゆがみが起きたり、少数データの特性が最終的に失われることを「データの崩壊」と研究者グループは表現しています。

さらに、これを避けるためトレーニングサイクルを多く繰り返さないようにモデルをトレーニングした場合でも、モデルはデータの頻繁な繰り返しを避けるために誤った応答をでっち上げ始めるため、依然としてモデルの崩壊が発生することがわかっています。モデルの崩壊への対処策として、論文では「オリジナルのデータセットの独占的で、名目上人間が作成したデータセットの高級コピーを保持し、それで定期的に再トレーニングしたり完全にリフレッシュしたりすることで、AIが生成したデータによる汚染を回避する」「人間が生成した新しいクリーンなデータセットをトレーニングに導入する」というアイデアを挙げています。

データの崩壊を防ぐには、学習量をしっかり確保し、特徴を正確に描写した上で、データセット内で少数派グループが公正に表現されるように設定することが重要だとシュマイロフ氏は指摘しています。シュマイロフ氏はVentureBeatの取材に対し、「人間が作成したデータを10%トレーニングに含めれば、AIコンテンツを再帰的に用いたとしても、モデルの崩壊はそれほど早く発生しないと考えられます。しかし、早くはないものの、依然として崩壊は発生します」と語っています。

・関連記事

ChatGPTは何をしていてなぜ機能するのか?を理論物理学者が解説 - GIGAZINE

AIではなく人間が作ったコンテンツにバッジを付ける「Not By AI Badges」プロジェクト - GIGAZINE

画像や文章の生成などを行う「ジェネレーティブAI」はなぜ急に発展したのか? - GIGAZINE

Adobeが画像生成AI「Firefly エンタープライズ版」で作った画像で訴訟された場合は全額補償すると発表、自社AIは権利侵害していないという自信の表れ - GIGAZINE

EdgeのBingのAIチャットは「Chrome」と検索すると定型文で自分自身を売り込みまくってくる - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, ネットサービス, Posted by log1e_dh

You can read the machine translated English article Researchers warn that the rapid increase….