GPT-3に匹敵するチャットAIモデル「LLaMA」をiPhoneやPixelなどのスマホで動かすことに成功

MetaのAI研究組織であるMeta AI Researchが、2023年2月24日に発表した大規模言語モデル「LLaMA(Large Language Model Meta AI)」はパラメーター数の小ささから、単体GPUでも動作可能とされています。そんなLLaMAを、iPhoneやPixelといったスマートフォンで動作させることにエンジニアのanishmaxxing氏が成功したと報告しています。

anishmaxxing(@thiteanish)さん / Twitter

https://twitter.com/thiteanish

Meta AI Researchが発表したLLaMAはWikipediaやCommon Crawl、C4などの一般に公開されているデータセットで学習が行われています。一方でOpenAIが提供する「GPT-3」などの言語モデルは一部非公開のデータセットを使用して学習を行いました。そのため、LLaMAはオープンソースと互換性のある再現可能な作業が可能とされています。

さらにGPT-3のパラメーター数が1750億であるのに対して、LLaMAはのパラメーター数は70億から650億とかなり少数です。しかしBoolQやPIQAなどのベンチマークを行ったところ、一部のテーマではLLaMAはGPT-3を上回る性能を示しています。

パラメータ数とは、機械学習モデルがデータに基づいて予測や分類を行うための変数量で、機械学習モデルの性能を左右する指標です。パラメーター数が大きければ大きいほどより複雑なタスク処理が安定しますが、同時に求められるコンピューターの性能も高くなります。一方でLLaMAはパラメーター数が小さいながらもGPT-3のような大規模言語モデルと同等のタスク処理を行うことができることから、コンシューマーレベルのハードウェア環境でも動作する可能性が挙げられています。

Metaが大規模言語モデル「LLaMA」を発表、GPT-3に匹敵する性能ながら単体のGPUでも動作可能 - GIGAZINE

また、70億から650億というパラメーター数の小ささから、LLaMAはM1などのApple シリコン搭載Macで動作することがこれまでに報告されています。

GPT-3のライバルとなるMetaの「LLaMA」をM1搭載Macで実行可能に、大規模言語モデルを普通の消費者向けハードウェアで実行可能であることが示される - GIGAZINE

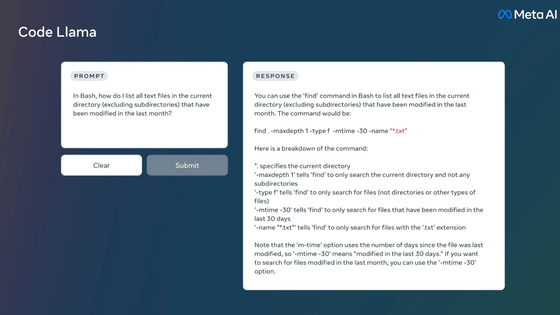

エンジニアのanishmaxxing氏は2023年3月14日にWeb アプリケーションフレームワークのNext.jsを使用してiOS上で動作させることに成功したことを報告しています。

????New Update! ????

— anishmaxxing (@thiteanish) March 14, 2023

I found 5 ways to not get LLaMA working on iOS

This NextJS app was a by-product from one of those 5 ways: pic.twitter.com/HyqSLiBgbg

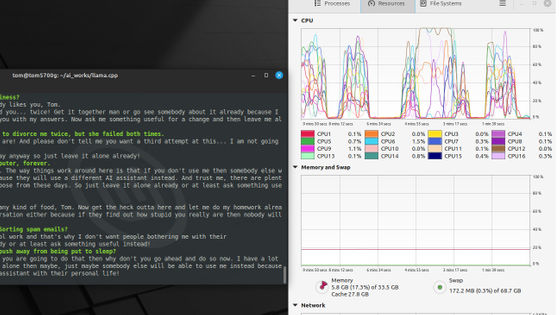

さらにanishmaxxing氏はLLaMAをPixel 6上で動作させることにも成功しています。anishmaxxing氏は「私はLLaMAがスマートフォンで動作することを期待していました」と述べています。

@ggerganov's LLaMA works on a Pixel 6!

— anishmaxxing (@thiteanish) March 13, 2023

LLaMAs been waiting for this, and so have I pic.twitter.com/JjEhdzJ2B9

一方でanishmaxxing氏はPixel 6で動作したLLaMAについて「今回動作したLLaMAはPixel向けに最適化されていません」と報告しています。さらに「私は自分のMacでLLaMAを量子化し、スマートフォンの容量に最適化した重みをPixelに転送しました」と述べています。

No, it's not even optimized for the pixel.

— anishmaxxing (@thiteanish) March 13, 2023

I quantized it on my mac and transferred the weights over due to space issues on my phone

さらにanishmaxxing氏はPixelで動作したLLaMAの生成時間の遅さに触れ「生成が非常に遅い原因は、ロード時間の問題があるようです。Linux環境を実行できるエミュレーターのTermuxで実行していることも原因かもしれません」と推測しています。

Generations are very slow, seems it's due to load time.

— anishmaxxing (@thiteanish) March 13, 2023

Might be cause I'm running it on Termux

・関連記事

Metaが大規模言語モデル「LLaMA」を発表、GPT-3に匹敵する性能ながら単体のGPUでも動作可能 - GIGAZINE

GPT-3のライバルとなるMetaの「LLaMA」をM1搭載Macで実行可能に、大規模言語モデルを普通の消費者向けハードウェアで実行可能であることが示される - GIGAZINE

Metaの大規模言語モデル「LLaMA-65B」のデータが4chanで流出 - GIGAZINE

Googleが視覚とテキストから人間のように理解するロボット向け言語モデル「PaLM-E」を発表、「お菓子を持ってこい」などの複雑な命令も遂行可能 - GIGAZINE

「初代iPhoneと同等の衝撃」と評されるOpenAIの次世代言語モデル「GPT-4」が2023年3月発表予定、画像認識機能や多言語対応の強化が実現か - GIGAZINE

「Pixel 6」「Pixel 6 Pro」開封の儀&フォトレビュー - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, スマホ, Posted by log1r_ut

You can read the machine translated English article Succeeded in running chat AI model 'LLaM….