言語処理のニューラルネットワークモデルが脳の働きと同じ構造をしているという仮説

脳がどのように時間を把握するのかという研究や選択的に恐怖やトラウマなどの記憶を消去する実験など、「脳がどのように機能して、脳のどこで何をするのか?」という疑問は依然として不明な点が多くなっています。そのような脳の働きについて、言語処理の深層学習モデルであるTransformerが、脳の機能を追跡する類似モデルとして役に立つことが示されました。

Quanta Magazine

https://www.quantamagazine.org/how-ai-transformers-mimic-parts-of-the-brain-20220912/

Relating transformers to models and neural representations of the hippocampal formation | OpenReview

https://openreview.net/forum?id=B8DVo9B1YE0

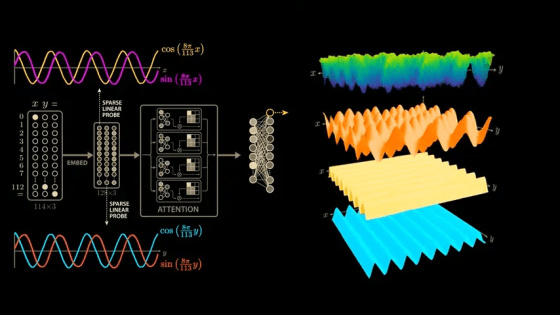

Transformerは、AIが言語を処理する新しい方法として2017年に発表されました。Transformerは時系列データを扱うことで、共感を生む歌詞や顧客サービス担当になりすますメッセージを作成することを可能にするもの。Transformerのメカニズムには「注意機構」という重要な点があり、従来のニュートラルネットワークでは、入力された語句が他の特定の語句にのみ接続していたところ、Transformerは全ての入力された語句、数字などを他の全ての入力と接続します。もともとは言語タスク用に設計されたTransformerは、画像の分類などのタスクにも優れていたほか、脳のモデル化としても活用されています。

2020年、オーストリアのヨハネスケプラー大学リンツ校でコンピューター科学を研究するゼップ・ホクライター氏の研究グループは、Transformerを利用して「ホップフィールドネットワーク」という記憶検索モデルを再構築しました。「同時に活動しているニューロンは、互いに強力な接続を構築する」という一般規則に従うホップフィールドネットワークは、全ての語句を常に関連付けるTransformerの注意機構と関連があるという点に、ホクライター氏は注目しました。ホクライター氏がアップグレードした「Transformerベースのホップフィールドネットワーク」は、ホップフィールドネットワークを考案したジョン・ホップフィールド氏も「生物学的に妥当である」と証明しました。

その後、2022年の始めごろ、認知神経科学者のジェームズ・ウィッティントン氏と計算神経科学者のティモシー・ベーレンス氏は、ホクライター氏のアプローチをさらに微調整して「海馬形成のモデルおよび神経表現へのTransformerの関連付け」という論文を加筆修正しました。ここでは、記憶を線形ではなく文中の一連の単語のように扱い、高次元空間の座標として符号化しています。これにより、神経科学のタスクにおける脳モデルのパフォーマンスをさらに改善し、同時に神経学者が見る細胞発火パターンのモデルと数学的にも同等であると、ウィッティントン氏とベーレンス氏は示しました。

ウィッティントン氏は、「記憶に重要な役割を果たす海馬のモデルは、Transformerによって神経発火パターンを再現することができます。この事実は、私たちが作成したTransformerのモデルは高い性能を持ち、訓練がより簡単であるということを示しています」と語り、Transformerが脳のように高度な振る舞いを可能にしていると強調しています。ウィッティントン氏によると、脳の働きを模倣できるTransformerモデルによって、人工ニュートラルネットワークがどのように機能するかを理解すると同時に、脳内で記憶や計算がどのように実行されるかの理解を深めることができる可能性があるとのこと。

また、マサチューセッツ工科大学の計算神経科学者であるマーティン・シュリンプフ氏は、43のニューラルネットワークモデルを分析して、それぞれどの程度正確に人間の神経活動の測定値を予測できるかを研究によって示しました。シュリンプフ氏によると、Transformerは現在最先端のニューラルネットワークであり、脳機能イメージングで発見されたほぼ全ての変動を予測できたそうです。

「脳を模倣したネットワークモデル」という大きな進歩が見えている一方で、ベーレンス氏は「Transformerはあくまで脳の正確なモデルへの第一歩に過ぎず、探求の終わりではありません。Transformerが文章を理解する最良のモデルだとしても、それが脳内で言語について処理する方法を映しているとは思いません」と述べています。またシュリンプフ氏も、「最高のパフォーマンスを発揮するTransformerでさえ、単語や短いフレーズではうまく機能しますが、物語のような大規模なタスクではうまく機能しません。私の感覚では、Transformerは脳の構造を理解するのに適切な場を用意し、今後トレーニングによって改善できると思います。これは良い傾向ではありますが、まだまだ非常に複雑な分野であることは変わりありません」と指摘しています。

・関連記事

人間の学習にはニューロンが発火するタイミングと脳波の「ズレ」が関係しているかもしれない - GIGAZINE

「恐怖」にかかわるマウスの記憶を消すことに成功、PTSD治療に新たな可能性 - GIGAZINE

脳は新しいタスクを学ぶ時にでも既知の習慣に固執する場合があることが判明 - GIGAZINE

脳は積極的に「記憶を失おうとしている」ことが判明 - GIGAZINE

睡眠は脳ができるよりずっと前に進化した - GIGAZINE

飢餓状態の脳が「省エネモード」に切り替わることで支払う代償とは? - GIGAZINE

・関連コンテンツ

in サイエンス, Posted by log1e_dh

You can read the machine translated English article Hypothesis that the neural network model….