NVIDIAが次世代GPUアーキテクチャ「Hopper」を発表、AI処理速度がAmpereの6倍など各種性能が飛躍的に向上

NVIDIAが自ら主催する開発者向けカンファレンス・GTC 2022の中で次世代GPUアーキテクチャ「Hopper」と、そのHopperを搭載する「H100 GPU」を発表しました。HopperはNVIDIAが注力している機械学習モデルのTransformerにおける処理能力を飛躍的に向上させます。

GTC 2022 Keynote with NVIDIA CEO Jensen Huang - YouTube

NVIDIA Announces Hopper Architecture, the Next Generation of Accelerated Computing | NVIDIA Newsroom

https://nvidianews.nvidia.com/news/nvidia-announces-hopper-architecture-the-next-generation-of-accelerated-computing

NVIDIA Hopper GPU Architecture Accelerates Dynamic Programming Up to 40x Using New DPX Instructions | NVIDIA Blog

https://blogs.nvidia.com/blog/2022/03/22/nvidia-hopper-accelerates-dynamic-programming-using-dpx-instructions/

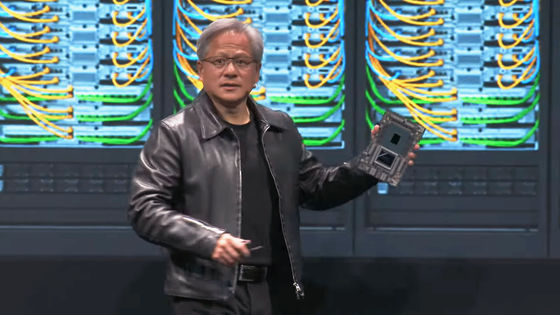

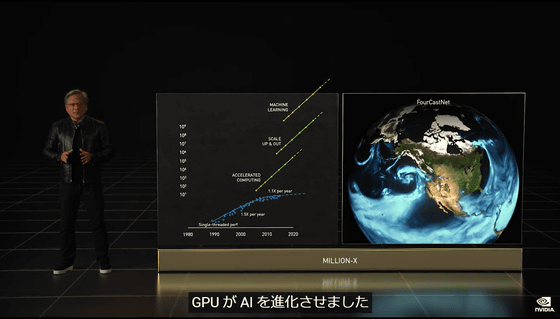

「Hopper」「H100」の発表が行われたのは、同社の創業者にしてCEOのジェン・スン・フアン氏の基調講演の中。フアンCEOはまず冒頭で、ヒトゲノムの解析やDNAの3D構造の解析、気候科学などの科学分野や自動翻訳などを飛躍的に進歩させているAIに対してGPUが大きく貢献しているとアピールして……

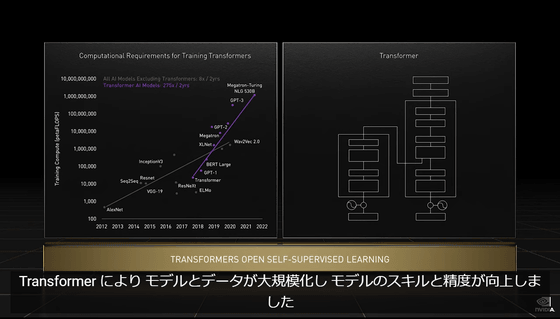

言語理解用のGoogle BERTや創薬用のNVIDIA MegaMO|BART、DeepMind AlphaFold2などを生み出したブレイクスルーが機械学習モデルのTransformerと強調。

そして、世界のAIコンピューティングインフラストラクチャのエンジンを大きく飛躍させる存在が今回発表するH100とのこと。

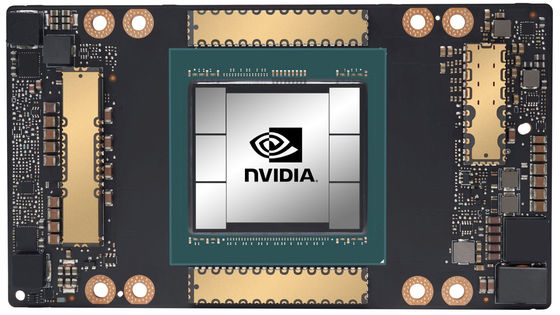

H100はTSMCの4ナノメートルプロセスによるトランジスタを800億個備えており、初の第5世代PCI-e GPUかつ初のHBM3 GPUとなる存在。1基のH100で40テラビット/秒のIO帯域幅を維持可能とのことで、20基のH100だけで世界のWebトラフィックを維持できる計算です。

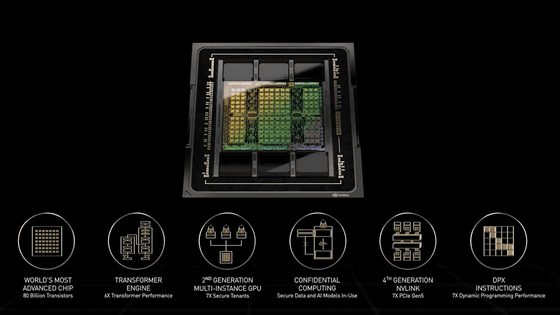

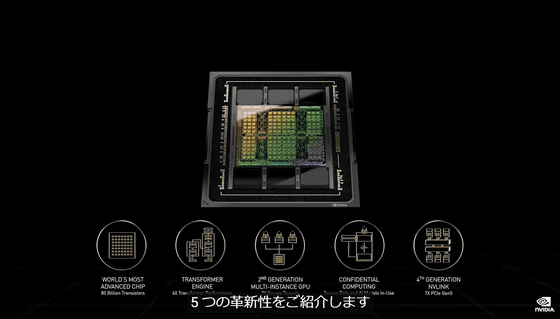

そして、H100の根幹となるのが、2020年に発表されたAmpereの後継となるアーキテクチャのHopper。フアンCEOによると、Hopperは6つの革新性を備えています。画像のタイミングでは「5つ」と言っていますが、後にフアンCEOが「もう1つあります」と追加するので計6つ。

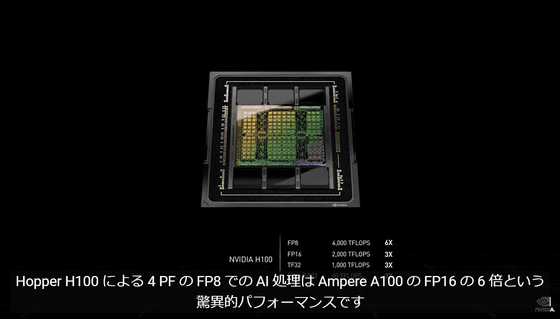

1つ目が4ペタFLOPSという驚異的な処理速度の新型Tensor処理形式「FP8」に対応しているという点。Hopper H100のFP8で行うAI処理は、Ampere A100のFP16の6倍という驚異的なパフォーマンスとのこと。

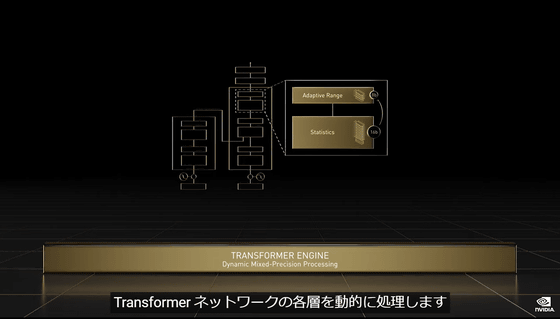

2つ目はTransformerネットワークの各層を動的に処理する「Hopper Transformer Engine」を導入した点。

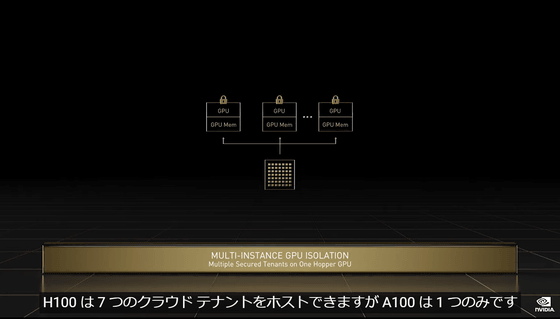

3つ目はインスタンスごとの完全な分離とIO仮想化の追加によりAmpereより高度なクラウドでのマルチテナンシーに対応した「第2世代マルチインスタンス」。マルチテナンシーについては、H100は現行一番人気のクラウド推論GPU「T4 GPU」2基と同等のクラウドテナントを最大7基までホストできるそうです。

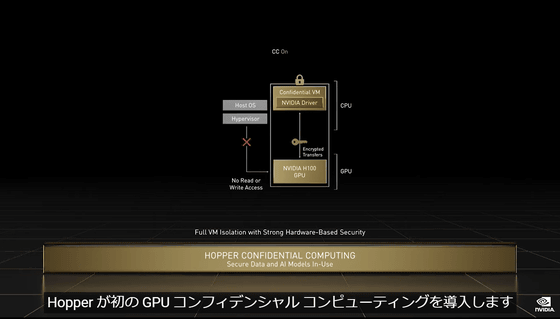

4つ目は既存のシステムの多くが対応していない「使用中の機密データの保護」を実現して、AIモデルと所有者のアルゴリズムにおける機密性と完全性を保護する「GPUコンフィデンシャルコンピューティング」を導入した点。

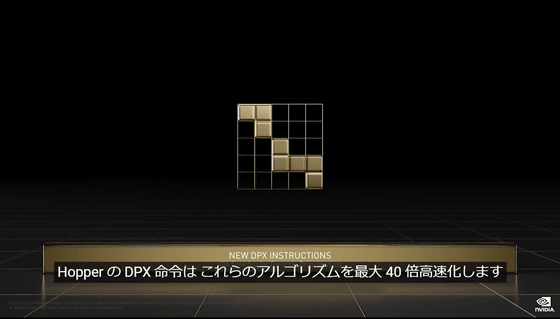

5つ目はルート最適化やゲノミクスを含む幅広いアルゴリズムで使用される動的計画法を、CPUと比較して最大40倍、Ampere世代のGPUと比較して最大7倍高速化する新型DPX命令に対応した点。

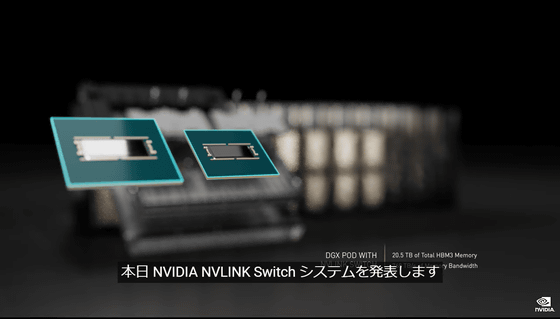

6つ目は、新しい外部NVLink Switchを組み合わせてサーバーを超えたスケールアップネットワークを構築できるようになった点。NVIDIA HDR Quantum InfiniBandを使用する前世代の9倍という帯域幅で最大256基のH100を接続できるようになったそうです。

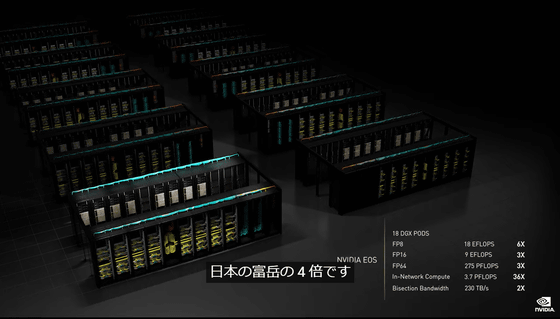

H100は2022年の第3四半期に提供が開始される予定。また、H100を8基搭載する「DGX H100」、このDGX H100を32台NVLink Switchで接続した「DGX H100 SuperPOD」、576台接続した「NVIDIA EOS」の提供も行うとのことで、「NVIDIA EOS」のAI処理性能は18エクサFlops、つまり2022年3月時点でスパコン最高性能を誇る「富岳」の4倍という性能に達する見込みです。

・関連記事

Intel・NVIDIA・TSMCは半導体業界でどんな役割を果たしているのか? - GIGAZINE

NVIDIAが無料版「Omniverse」の提供開始、そもそも「Omniverse」では一体何ができるのか? - GIGAZINE

NVIDIAが2022年度第3四半期の決算を発表、売上高が前年比50%増と好調 - GIGAZINE

・関連コンテンツ

in AI, 動画, ハードウェア, Posted by darkhorse_log

You can read the machine translated English article NVIDIA announces next-generation GPU arc….