コード生成AIによる幻覚を悪用した新しいサイバー攻撃「スロップスクワッティング」が登場する可能性

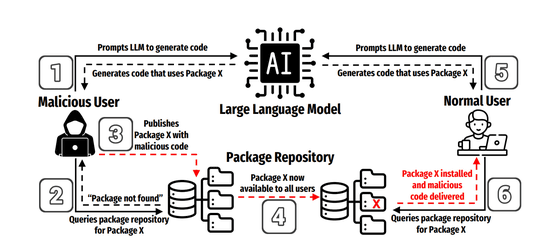

AIによるコード生成の普及は、開発効率を大きく向上させる一方で、全く新しいリスクも生み出しています。大規模言語モデル(LLM)には幻覚として「存在しないパッケージ名」を生成するリスクがあり、攻撃者が同名で悪意あるパッケージを公開することで、AI支援でコードを書く開発者を騙す新手のソフトウェアサプライチェーン攻撃「スロップスクワッティング」の可能性が指摘されています。

[2406.10279] We Have a Package for You! A Comprehensive Analysis of Package Hallucinations by Code Generating LLMs

https://arxiv.org/abs/2406.10279

The Rise of Slopsquatting: How AI Hallucinations Are Fueling...

https://socket.dev/blog/slopsquatting-how-ai-hallucinations-are-fueling-a-new-class-of-supply-chain-attacks

AI-hallucinated code dependencies become new supply chain risk

https://www.bleepingcomputer.com/news/security/ai-hallucinated-code-dependencies-become-new-supply-chain-risk/

「スロップスクワッティング」は、ユーザーの誤字を狙った従来のタイポスクワッティング攻撃とは異なり、AIの誤りを利用する攻撃です。たとえば、ChatGPTやGitHub Copilotのようなツールが実在しないパッケージを推奨し、それを無批判にコピー&ペーストしてインストールしてしまうことで、マルウェアが意図せずプロジェクトに組み込まれてしまう危険があります。

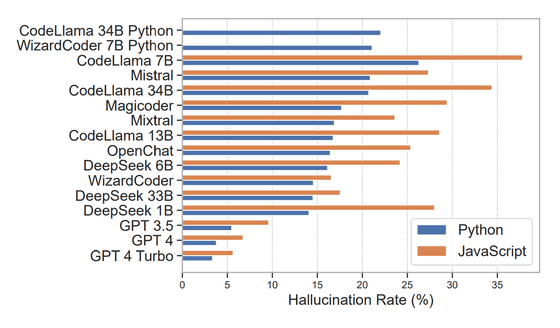

テキサス大学サンアントニオ校・オクラホマ大学・バージニア工科大学の共同研究チームは、商用とオープンソースを含む16種類のLLMを対象に、合計57万6000件のPythonおよびJavaScriptコードサンプルを生成・分析しました。その結果、全体の19.7%にあたるパッケージが存在しない、すなわち幻覚であることが判明しました。特にオープンソースモデルでは平均21.7%という高い幻覚率を示し、CodeLlamaの一部モデルでは3分の1以上が幻覚という結果になったと報告されています。対照的に、GPT-4 Turboの幻覚率はわずか3.59%に抑えられており、相対的に安定性の高いモデルだったとのこと。

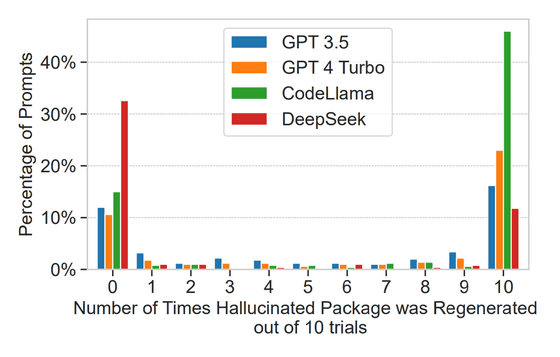

そして、500件の幻覚生成プロンプトを10回ずつ再実行したところ、43%はすべての試行で同じ幻覚を繰り返し生成しており、39%は一度も再生成されませんでした。これは幻覚が完全にランダムというよりも、ある種の規則性やモデル特有の癖があることを示していると研究チームは論じています。つまり、攻撃者はAIの出力を数回観察するだけで、狙うべきパッケージ名を効率的に特定できるというわけです。

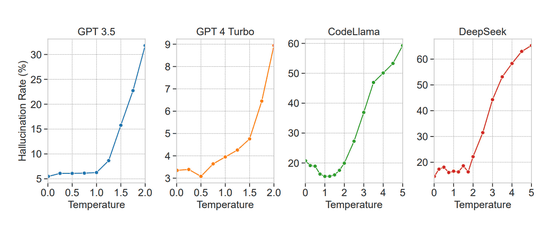

加えて、生成のランダム性を司る温度(temperature)という変数を高くすると、幻覚率が劇的に上昇することも確認されています。あるモデルでは、温度が高い設定下だと有効なパッケージよりも多くの幻覚パッケージを出力するという結果も出たと、研究チームは報告しています。また、提案されるパッケージ数が多く冗長なモデルほど幻覚率が高く、逆に信頼できるパッケージのみを使うモデルほど幻覚が少ない傾向が明らかになりました。

幻覚パッケージの多くは見た目も本物そっくりで、文字列の類似度で見ると、38%が既存パッケージと中程度の類似性を持ち、13%は単純な誤字に過ぎず、残りの多くもまったく架空ながら十分に信ぴょう性を持たせるような名前でした。また、PythonとJavaScriptの間で混同が起きるケースも確認され、言語間での依存関係誤認によるリスクも浮き彫りになっていると研究チームは指摘しています。

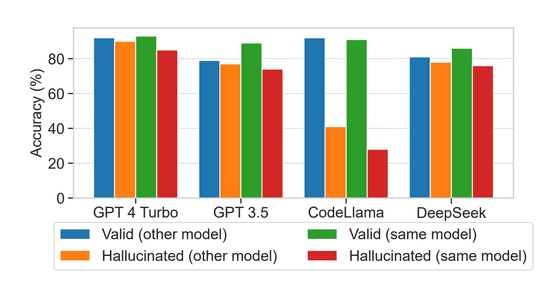

さらに、GPT-4 TurboやDeepSeekのような一部モデルは、自身が生成したパッケージが幻覚かどうかを75%以上の精度で見抜く能力を持っていることも判明。これは、出力を自ら再評価する「自己検証型」の対策が可能であることを示唆しており、今後の幻覚抑制に向けた有力な手がかりだと研究チームは論じました。

近年では、ユーザーが詳細なコードを書くのではなく「こんなことをしたい」とAIに伝えるだけでコードを生成してもらう「バイブコーディング」というスタイルも広がっており、ますますAIの出力が無批判に受け入れられる傾向にあるため、幻覚パッケージが実際の開発現場で使われてしまうリスクは格段に高くなっているといえます。

セキュリティ企業のSocketは、コード生成AIの便利さの裏に重大なセキュリティリスクが潜んでおり、その脅威は確実に現実化しつつあると指摘し、今後は開発者のリテラシーと対策ツールの両面から新たな攻撃手法に対抗する必要があると述べました。

・関連記事

生成AIの幻覚で指定される「架空のパッケージ」に悪用の危険性があるとセキュリティ研究者が警告 - GIGAZINE

2023年のワード・オブ・ザ・イヤーに「幻覚」が選ばれる、生成AIに関する新しい意味の追加で - GIGAZINE

AIにプログラミングさせる時に幻覚が発生しても大した問題にはならないという主張 - GIGAZINE

さまざまなチャットAIがどれくらい幻覚を見るのかをランキングにした「Hallucination Leaderboard」が公表される - GIGAZINE

MetaやOpenAIがAIモデル開発に使っていた世界最大級のオンライン海賊版ライブラリ「LibGen」とは? - GIGAZINE

・関連コンテンツ

in AI, セキュリティ, Posted by log1i_yk

You can read the machine translated English article A new cyber attack called 'slop squattin….