ノイズから単語を抽出して爆速なコード生成が可能な拡散型の言語モデル「Mercury Coder」

AI開発企業のInceptionが、一般的なAIモデルよりも最大10倍高速なテキスト生成が可能な大規模言語モデル「Mercury Coder」をリリースしました。

Inception Labs

https://www.inceptionlabs.ai/news

We are excited to introduce Mercury, the first commercial-grade diffusion large language model (dLLM)! dLLMs push the frontier of intelligence and speed with parallel, coarse-to-fine text generation. pic.twitter.com/HfjDdoSvIC

— Inception Labs (@InceptionAILabs) February 26, 2025

New AI text diffusion models break speed barriers by pulling words from noise - Ars Technica

https://arstechnica.com/ai/2025/02/new-ai-text-diffusion-models-break-speed-barriers-by-pulling-words-from-noise/

Mercury CoderはHugging Faceのほか、Inceptionのデモサイトで試すことが可能です。今回はInceptionのデモサイトを利用してみます。

Mercury Coder

https://chat.inceptionlabs.ai/c/365afbf5-d152-44ef-a8f4-66215ace1a38

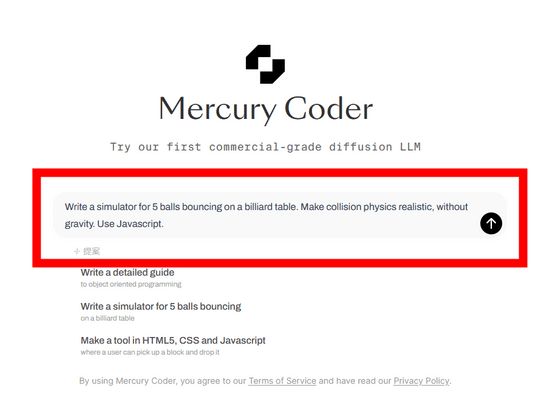

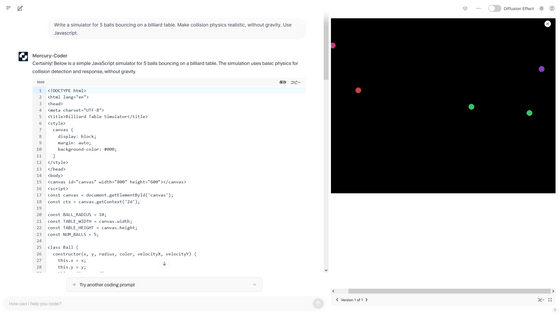

上記のサイトにアクセスしたら、テキストボックスに質問を入力します。今回は「Write a simulator for 5 balls bouncing on a billiard table. Make collision physics realistic, without gravity. Use Javascript.(ビリヤード台の上で5つのボールがバウンドするシミュレーターのコードを作成してください。重力の影響は考慮せずに、衝突の物理をリアルに表現してください。Javascriptを使ってください)」と入力しました。入力が完了したら上矢印「↑」をクリック。

わずか数秒でコードが生成され、右側にはシミュレーションが表示されました。

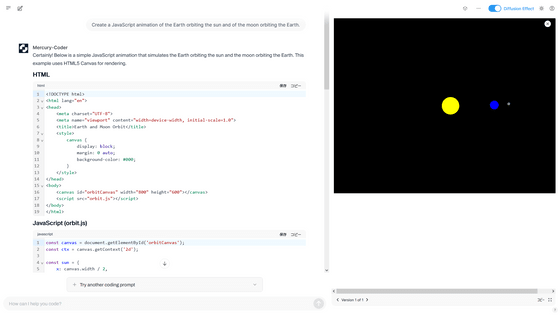

続いて「Create a JavaScript animation of the Earth orbiting the sun and of the moon orbiting the Earth.(地球が太陽の周りを回り、月が地球の周りを回るJavaScriptアニメーションを作成してください)」と指示。

瞬く間に要求した通りのコードが生成されました。

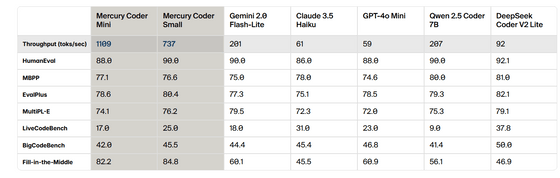

Inceptionによると、一般的な大規模言語モデルは一度に1つのトークンを左から右に生成するため、前のテキストが生成されるまで次のテキストを生成することはできないとのこと。しかし、Mercury Coderは「粗いものから細かいものへ」といった生成プロセスで動作するため、純粋なノイズから単語を抽出する「ノイズ除去ステップ」を経ることで高速なテキスト生成が可能です。以下は1秒あたりの出力トークン数を一般的な大規模言語モデルとMercury Coderの2モデルで比較したグラフ。Qwen2.5 CoderやGemini 2.0、Llama 3.1、GPT-4o miniなどと比較して、Mercury Coderのパフォーマンスが非常に優れていることが分かります。

Inceptionは「Mercury Coderは一般的な大規模言語モデルよりも5~10倍高速でありながら、低コストで高品質の応答が可能です」と述べています。以下は同じプロンプトをClaude、ChatGPT、Mercury Codeに入力してコードが生成されるまでの時間を計測した結果。Mercury Codeはわずか6秒でコードの生成が完了しているのに対し、ClaudeとChatGPTはそれぞれ28秒、36秒を要しています。

Try Mercury Coder on our playground at https://t.co/XCeNw9BtsX pic.twitter.com/0Ewp4Z9NOD

— Inception Labs (@InceptionAILabs) February 26, 2025

また、大規模言語モデルの評価指標であるHumanEvalやMBPP、EvalPlusを使ったベンチマーク結果が以下。Mercury Coderは1秒あたりのトークン数がGemini 2.0 Flash-LiteやClaude 3.5 Haiku、GPT-4o Miniと比べて非常に多い一方で、その他の評価指標も他の大規模言語モデルと比べて同等の性能を発揮しています。

さらに、Mercury Coderのような拡散モデルは以前の出力を考慮するだけに限定されないため、推論と応答の構造化に優れているほか、出力を断続的に改良できるため、間違いや幻覚を修正できるそうです。これまで、拡散モデルはSoraやMidjourney、Stable Diffusionといった動画や画像、オーディオ生成のためのAIソリューションに使用されてきましたが、テキストやコードなどの離散データへの応用は進められていませんでした。

元OpenAI研究者のアンドレイ・カルパシー氏は「Mercury Codeは拡散モデルを使用した最初の大規模言語モデルとして非常に興味深いものです。このモデルは他の大規模言語モデルとは異なり、新しい独自の長所や短所を生み出す可能性があります」と評しています。

This is interesting as a first large diffusion-based LLM.

— Andrej Karpathy (@karpathy) February 27, 2025

Most of the LLMs you've been seeing are ~clones as far as the core modeling approach goes. They're all trained "autoregressively", i.e. predicting tokens from left to right. Diffusion is different - it doesn't go left to… https://t.co/I0gnRKkh9k

なお、Mercury CoderについてInceptionは「Mercury Coderは近日公開の拡散型の大規模言語モデルシリーズの第1弾です。Mercury Coderはチャットアプリケーション用に設計されており、あくまでクローズドベータ版です」と伝えています。

・関連記事

わずか26分間の学習と1000円以下の計算コストでOpenAI o1-preview相当のAIモデルを構築する方法が発表される - GIGAZINE

Llama 3.3 70BベースでGPT-4o超えの満足度を達成するAIをPerplexityが発表 - GIGAZINE

AI検索結果を視覚的な答えとマルチステップの推論で見せてくれる「Phind 2」リリース - GIGAZINE

LLM の推論機能を活用する新しいバックドア攻撃「DarkMind」が提唱される - GIGAZINE

OpenAIがGPT-4.5をリリース、「これまでで最大かつ最高の会話用モデル」とアピール - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, レビュー, Posted by log1r_ut

You can read the machine translated English article 'Mercury Coder' is a diffusion-type lang….