日本に拠点を置くAI企業「Sakana AI」がキャッシュメモリの使用量を最大75%削減する技術「NAMM」を開発

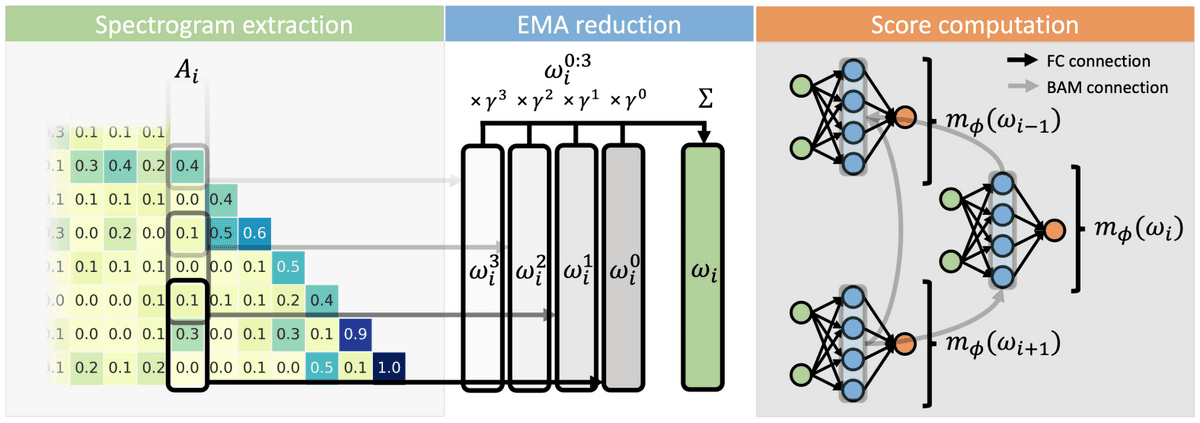

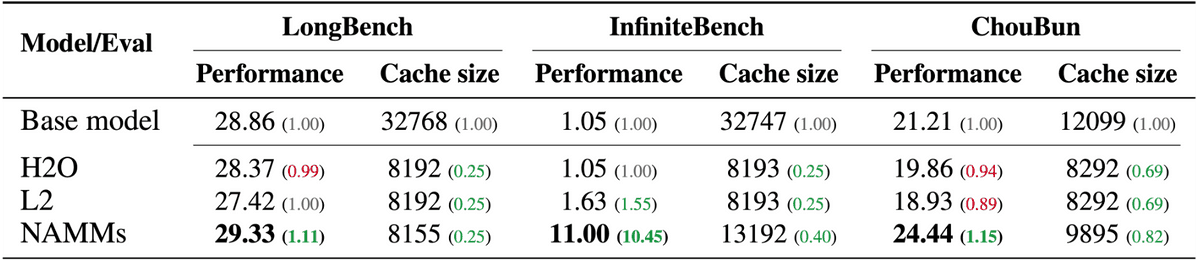

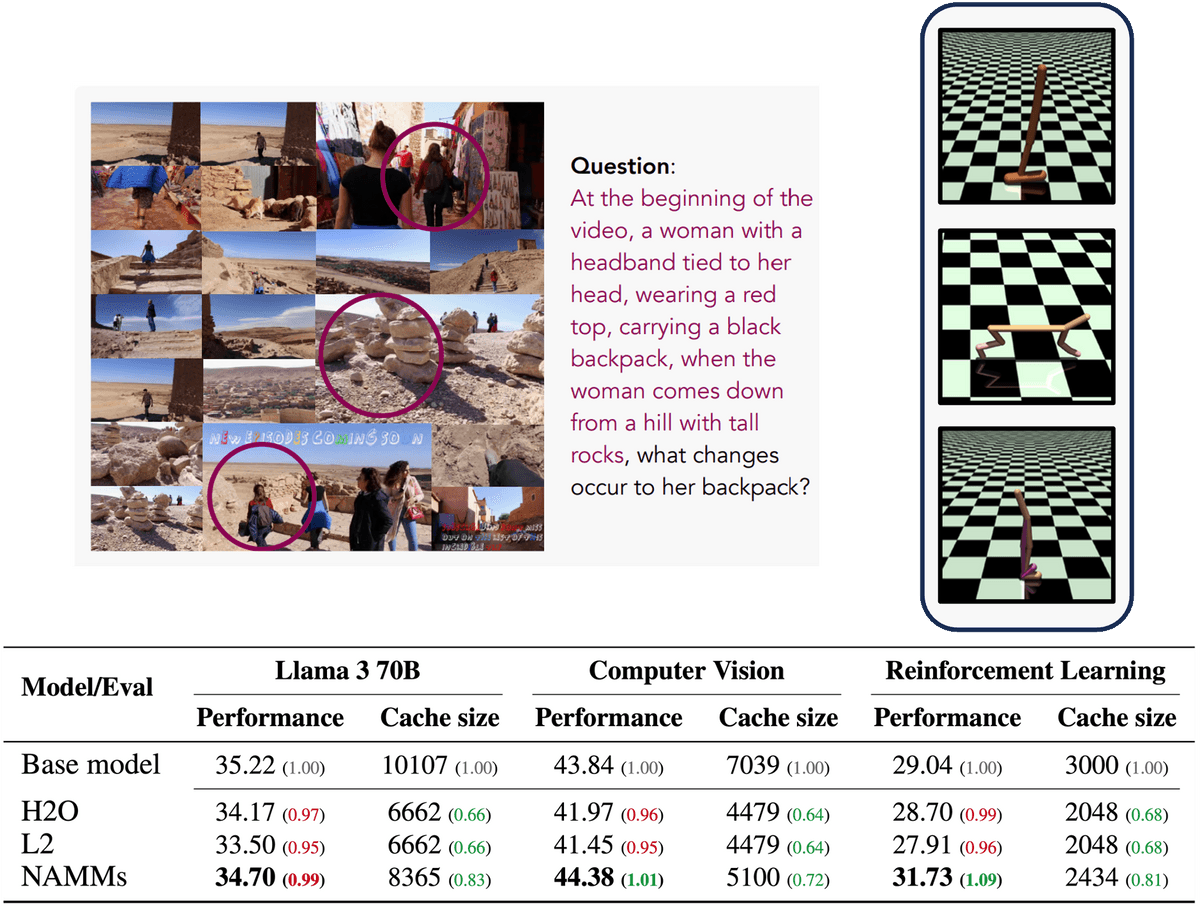

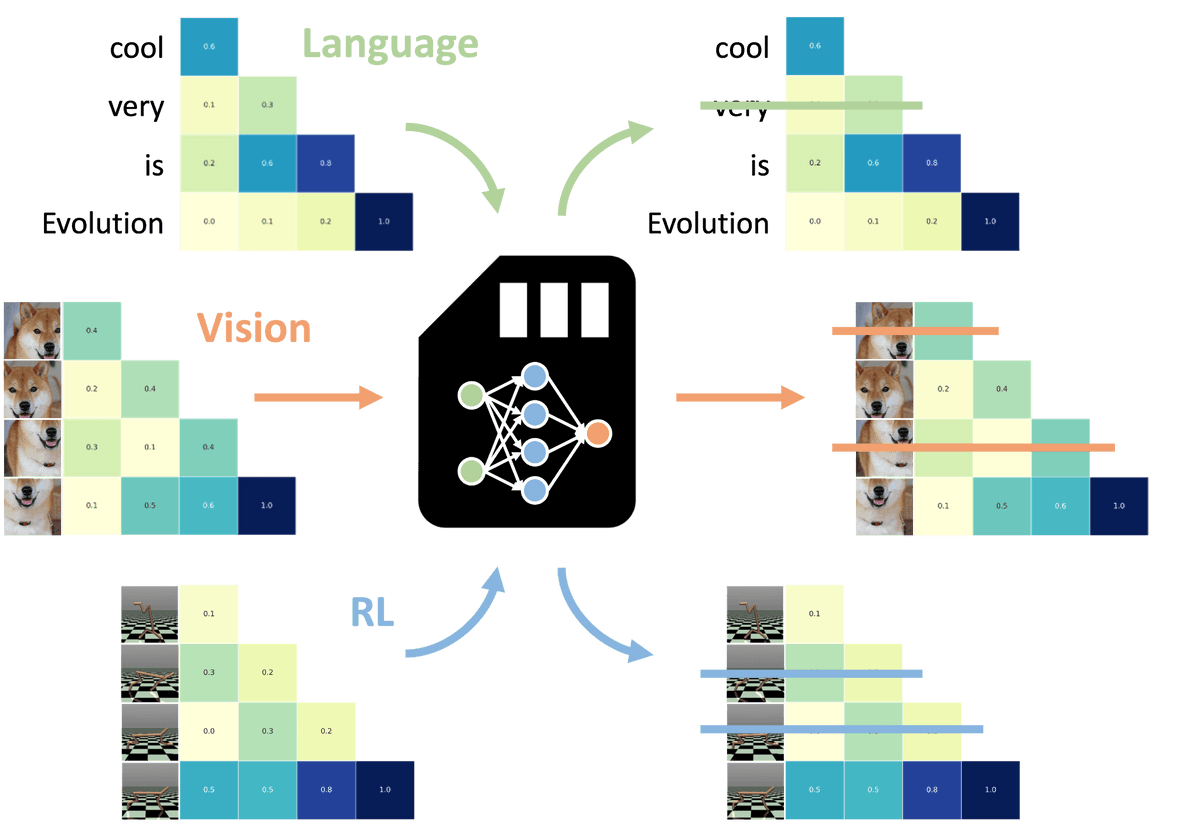

Sakana AIが「進化したユニバーサルトランスフォーマーメモリ」という論文を発表しました。論文によると、ニューラルアテンションメモリーモデル(NAMM)という新たな仕組みを導入することでコンテキストにおいて冗長な情報を削減でき、推論時のメモリ効率を高めることができたとのことです。

An Evolved Universal Transformer Memory

https://sakana.ai/namm/

[2410.13166] An Evolved Universal Transformer Memory

https://arxiv.org/abs/2410.13166

AIの本体である大規模言語モデル(LLM)では、ユーザーからの入力であるプロンプトをコンテキストとして受け取り、新たな返答を生成しています。現在主流のモデルは数十万から数百万トークンという非常に長いコンテキストを受け取ることが可能ですが、コンテキストの長さに応じてコンピューティング費用がかかったり、パフォーマンスが低下したりするという問題がありました。

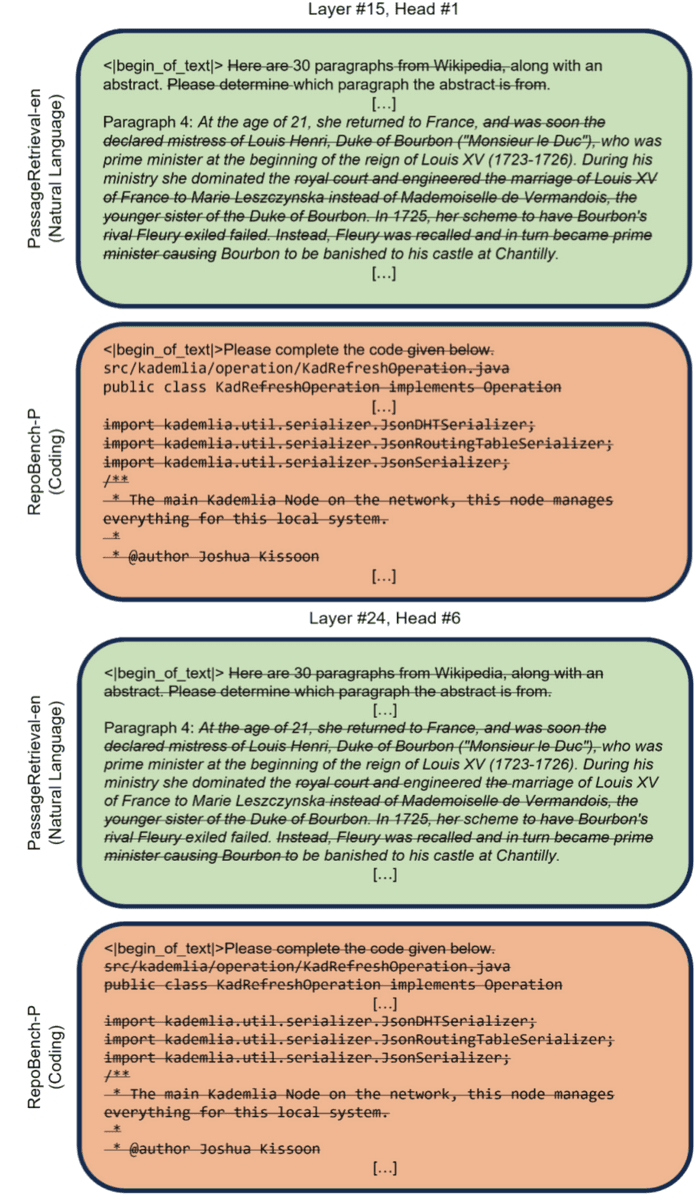

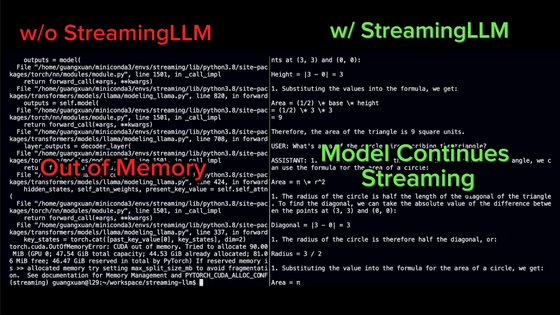

Sakana AIはLLMのメモリに保存されている各トークンを「記憶する」か「忘れる」かを決定するシンプルなニューラルネットワークとしてNAMMを開発。プロンプトのうち、重要な部分を残す一方で冗長な部分を積極的に「忘れる」ことで効率とパフォーマンスを同時に向上させることに成功しました。

・関連記事

科学論文の調査に特化したAIモデル「OpenScholar」がベンチマークでGPT-4oを上回る、科学研究の大幅な効率化に期待 - GIGAZINE

Stable Diffusionなどの画像生成AIに用いられる拡散モデルは「進化的アルゴリズム」だという主張 - GIGAZINE

実験と論文執筆だけでなく査読まですべてAIが行う「AIサイエンティスト」を日本のAI企業「Sakana AI」がリリース - GIGAZINE

日本に拠点を置くAI企業「Sakana AI」がNVIDIAなどから合計140億円以上の出資を受ける - GIGAZINE

既存のAIモデルを組み合わせて超高性能モデルを作る手法を日本のAI企業「Sakana AI」が開発、進化的アルゴリズムで膨大な組み合わせを試行し人間には発想困難な高性能LLMや画像生成モデルを作成可能 - GIGAZINE

・関連コンテンツ

in ソフトウェア, 無料メンバー, Posted by log1d_ts

You can read the machine translated English article Japan-based AI company 'Sakana AI' devel….