MITからスピンオフした「Liquid AI」が非トランスフォーマーAIモデル「LFM 1B・3B・40B MoE」をリリース

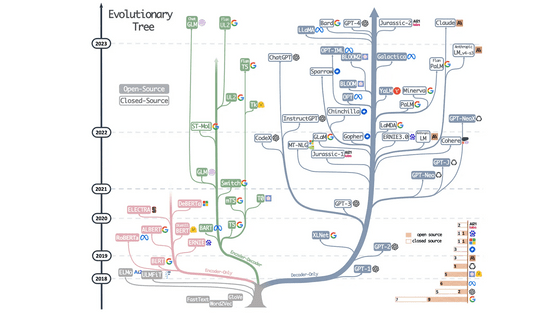

OpenAIのChatGPTの正式名称「Chat Generative Pre-trained Transformer」にTransformer(トランスフォーマー)という言葉が使われているとおり、記事作成時点でメジャーなAIモデルの多くはGoogleが発表した深層学習モデルであるトランスフォーマーを使用したものです。トランスフォーマーを使わずにGPTを超える基礎モデルを構築することを目標に掲げるAI企業のLiquid AIが、メモリー・フットプリントを最小限に抑えつつ優れたパフォーマンスを示すLiquid Foundation Models(LFM)の最初のシリーズを発表しました。

Liquid Foundation Models: Our First Series of Generative AI Models

https://www.liquid.ai/liquid-foundation-models

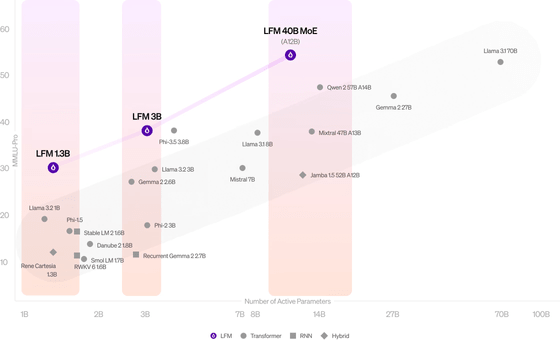

今回発表された生成AIのLFMは、リソースが制限された環境に最適な「LFM 1.3B」、中規模の「LFM 3B」、より複雑なタスクに取り組むために設計された混合専門家モデル(MoE)である「LFM 40B MoE」の3つのサイズにわかれています。マサチューセッツ工科大学(MIT)のスピンオフ企業であるLiquid AIによると、LFMはサイズに対するパフォーマンスに優れているとのこと。

Liquid AIは「LFMは力学系の理論、信号処理、数値線形代数に深く根ざした計算ユニットで構築された大規模なニューラルネットワークです。この独自の組み合わせは、これらの分野における数十年にわたる理論的進歩を生かすことで、あらゆる規模のインテリジェンスを実現可能にします。こうして開発されたLFMは、映像、オーディオ、テキスト、時系列、信号など、あらゆる種類のシーケンシャルデータのモデル化に使用できる汎用AIモデルとなりました」と説明しました。

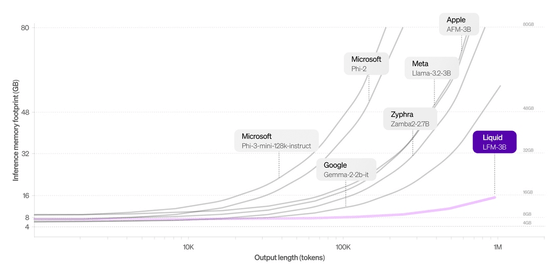

LFMは、トランスフォーマーをアーキテクチャとしたモデルに比べてメモリ効率に優れているのが特徴で、入力を効率的に圧縮することにより、同じハードウェアでより長いシーケンスを処理することが可能となっています。

以下は、3Bクラスのモデルが推論に必要とするメモリをグラフにしたもので、LFM 3Bのメモリー・フットプリントがいかに少ないかが示されています。

実際にLFMを使ってみることもできます。

Liquid Labs

https://playground.liquid.ai/chat?model=cm1ooqdqo000208jx67z86ftk

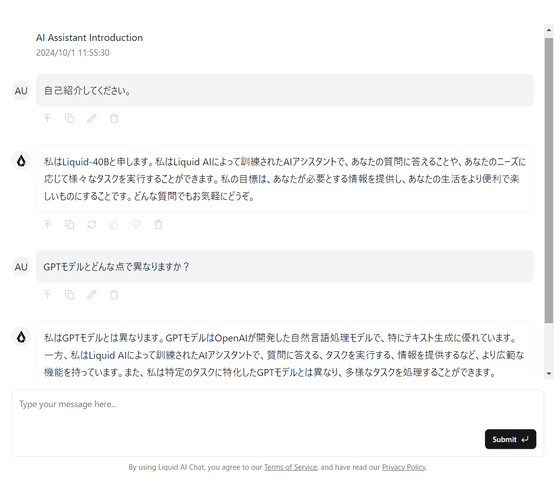

上記のURLにアクセスするとこんな感じ。

マルチモーダルモデルではないので、画像の生成などには対応していませんが、日本語で入力しても自然に受け答えしてくれます。

Liquid AIによると、「Liquid」という名称は同社のルーツである動的で適応力のある学習システムに敬意を表したものだとのことです。

・関連記事

SSM-Transformerアーキテクチャ採用で従来の約3倍のスループットを実現した大規模言語モデル「Jamba」をAI21 Labsが発表 - GIGAZINE

大規模言語モデルの仕組みが目で見てわかる「Transformer Explainer」 - GIGAZINE

ChatGPTにも使われる機械学習モデル「Transformer」が自然な文章を生成する仕組みとは? - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1l_ks

You can read the machine translated English article MIT spinoff Liquid AI releases non-Trans….