Metaが画像だけでなく動画内のオブジェクトもリアルタイムかつ正確に識別可能なAIモデル「Segment Anything Model 2(SAM 2)」をリリース

Metaが画像や動画内のどのピクセルがどのオブジェクトと関係したものかを正確に識別することができる統合AIモデルの「Segment Anything Model 2(SAM 2)」を発表しました。SAM 2を利用することであらゆるオブジェクトをセグメント化し、動画のすべてのフレームにわたってリアルタイムで一貫した追跡が可能になるため、動画編集や複合現実の分野で革新的なツールとなる可能性があります。

Our New AI Model Can Segment Anything – Even Video | Meta

https://about.fb.com/news/2024/07/our-new-ai-model-can-segment-video/

Introducing SAM 2: The next generation of Meta Segment Anything Model for videos and images

https://ai.meta.com/blog/segment-anything-2/

どのピクセルがどのオブジェクトに属するかを正しく識別する「セグメンテーション」と呼ばれる作業は、科学的画像の分析や写真の編集などのタスクに役立ちます。Metaは独自のセグメンテーションAIモデルとしてSegment Anything Model(SAM)を開発しており、InstagramのAI機能である「Backdrop」や「Cutouts」に活用されています。

SAMはInstagram以外にも、科学や医学、その他多くの業界で多様なアプリケーションの触媒となっているそうです。例えば、海洋科学分野ではソナー画像をセグメンテーションしてサンゴ礁を分析するために利用されており、災害救助の分野では衛星画像の分析に使用されており、医療分野では細胞画像をセグメンテーションして皮膚がんを検出するのに役立っています。

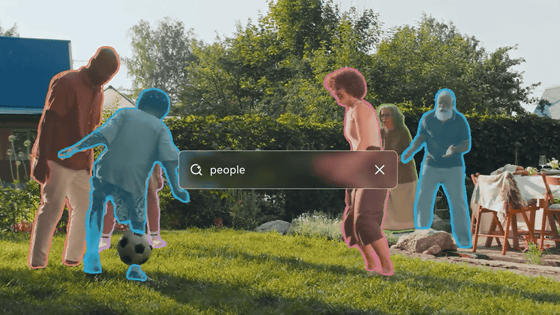

そんなSAMの次世代モデルとなる「SAM 2」をMetaが発表しました。SAM 2ではSAMが備えていたセグメンテーション能力を動画にまで拡張しており、画像あるいは動画内の任意のオブジェクトをセグメンテーションし、動画のすべてのフレームにわたってリアルタイムで一貫して追跡することができます。セグメンテーション能力を動画にまで拡張したというだけでなく、操作時間も3分の1まで短縮可能です。

動画でのセグメンテーションは画像よりもはるかに難しいため、既存のAIモデルでは実現するのに不十分だったそうです。動画ではオブジェクトが高速で移動したり、外観が変化したり、他のオブジェクトやシーンの一部に隠れたりすることがあります。SAM 2の構築ではこれらの課題の多くを解決することに成功しています。

SAM 2が動画内のオブジェクトをどれだけ正確に識別できるかは、Metaのマーク・ザッカーバーグCEOが投稿した以下の動画を見れば一発でわかります。

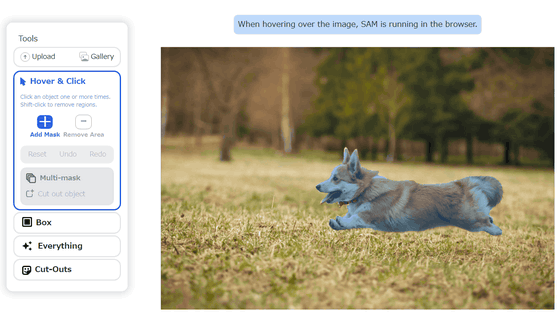

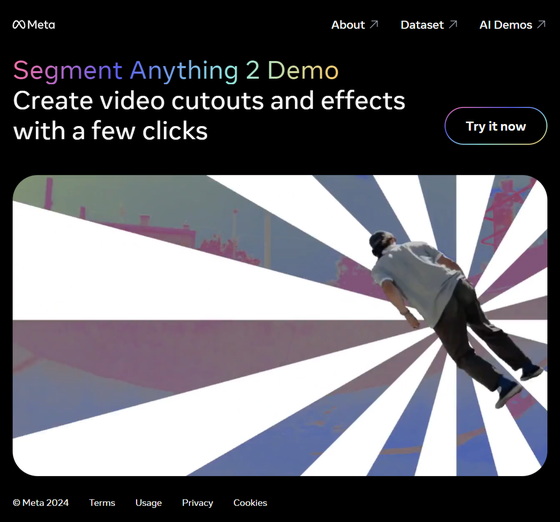

MetaはSAM 2のデモンストレーション用ウェブアプリも公開しており、そのセグメンテーション能力の高さを実感することが可能です。

SAM 2 Demo | By Meta FAIR

https://sam2.metademolab.com/

デモを体験するには「Try it now」をクリック。

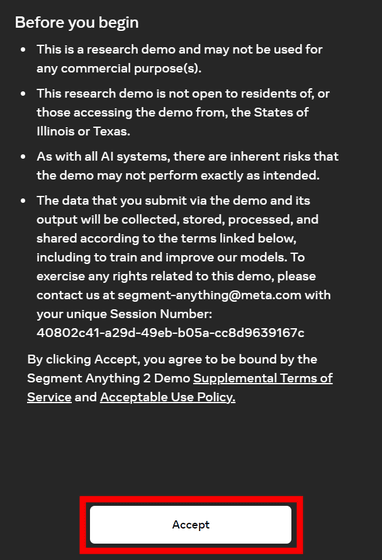

すると注意書きが表示されます。SAM 2のデモはあくまで研究用のものであるため、商業目的での利用はできません。また、イリノイ州とテキサス州の居住者はこのデモを利用できません。加えて、デモが意図したとおりに動作しない可能性や、デモを通じて送信されたデータとその出力は、以下のリンク先の規約にしたがって収集・保存・処理・共有され、AIモデルのトレーニングと改善に使用されることが記載されています。画面下部の「Accept」をクリック。

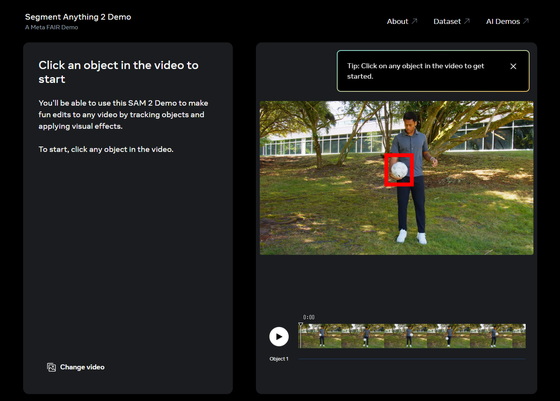

デモ画面は以下の通り。画面上のオブジェクトをクリック。

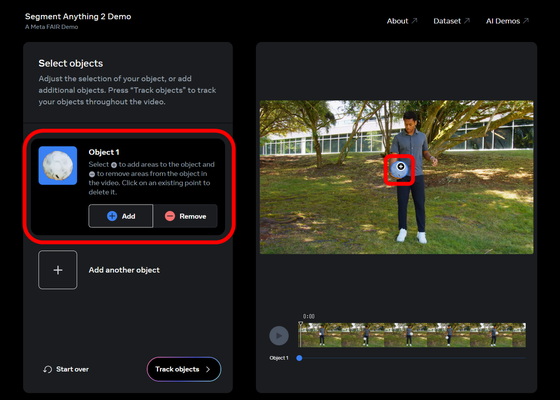

すると以下の通りオブジェクトが識別されます。

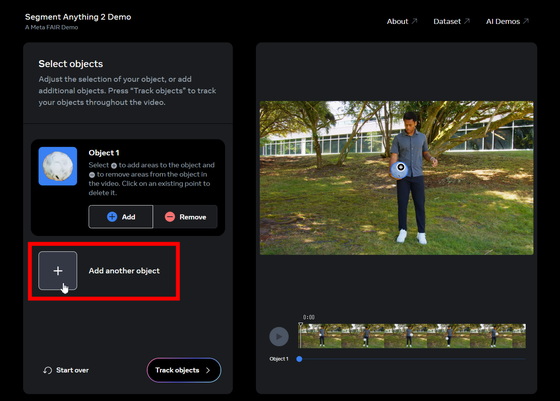

新しいオブジェクトを識別したい場合は「Add another object」をクリック。

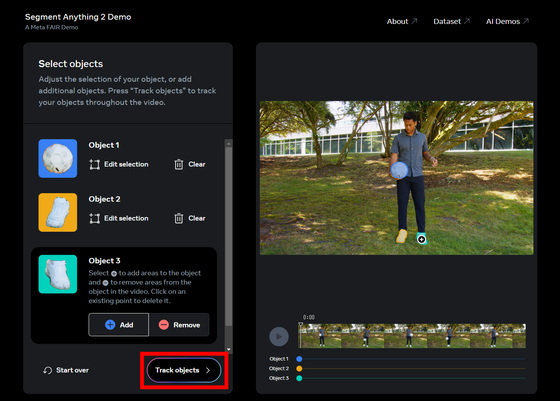

オブジェクトは同時に3つまで識別可能。オブジェクトを選択したら「Track objects」をクリック。

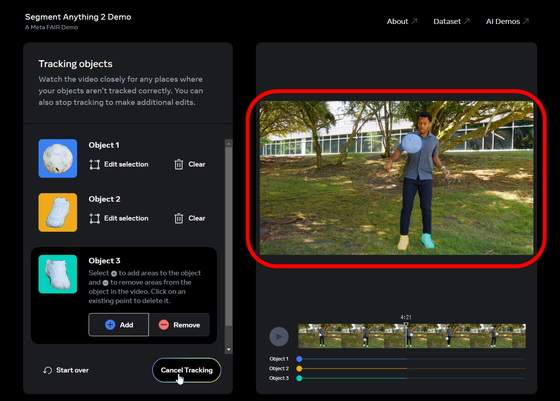

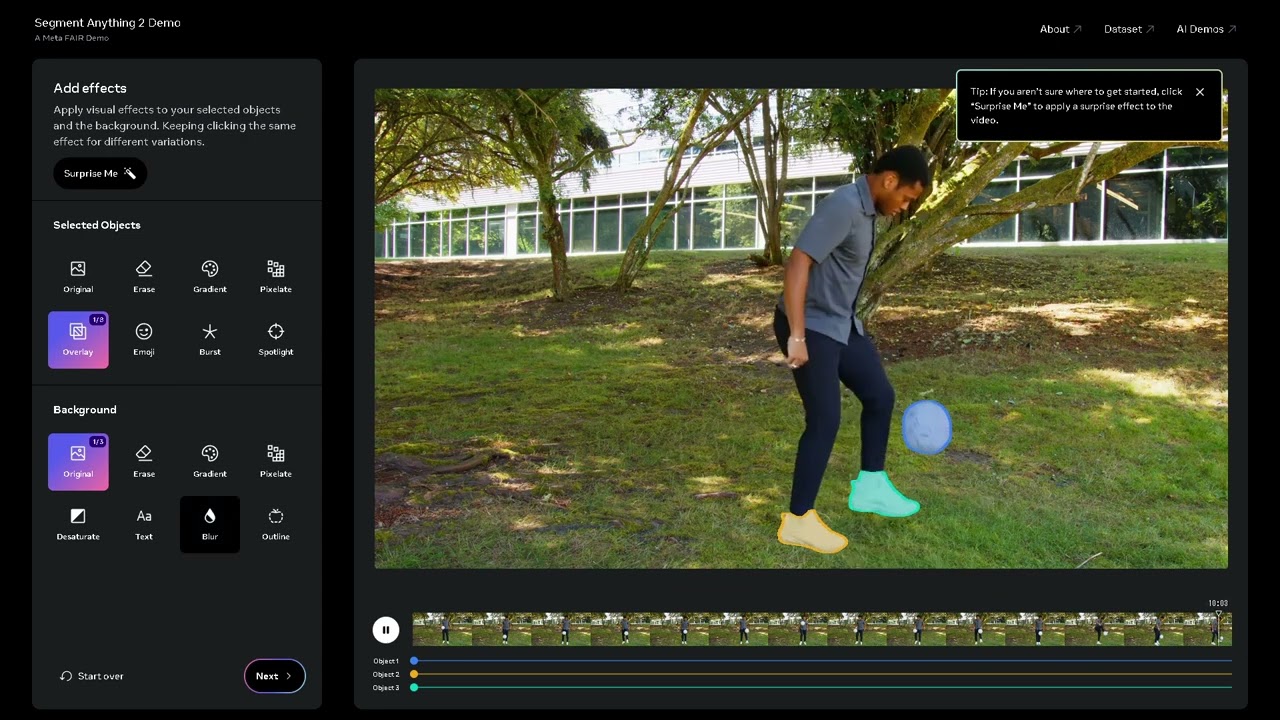

すると赤枠部分の動画が再生されます。ボールと靴はどちらも白色を基調としており、2つが重なる瞬間も多々あるのですが、SAM 2は正確にそれぞれのオブジェクトを識別することに成功しています。

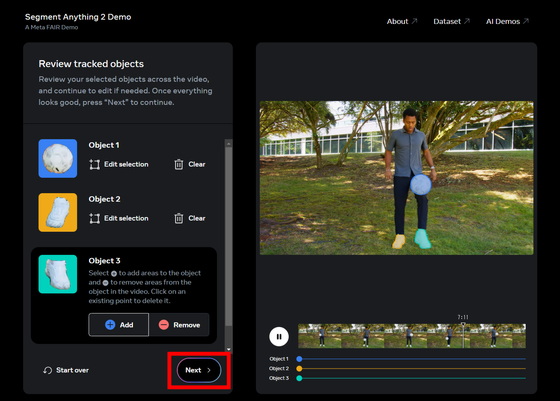

「Next」をクリック。

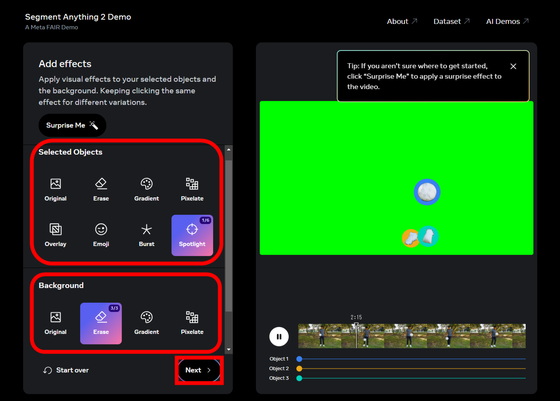

「Selected Objects」部分をクリックすると選択したオブジェクトのハイライト方法が変わり、「Background」部分をクリックすると選択したオブジェクト以外の背景の処理方法が変更されます。「Next」をクリック。

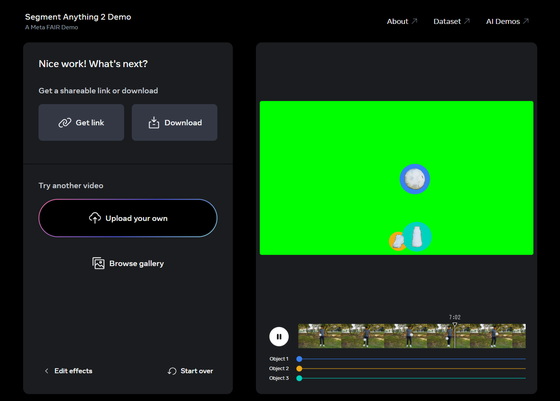

セグメンテーションした動画はダウンロードすることも可能。さらに、「Upload your own」から動画をアップロードしてセグメンテーションさせることもできます。

SAM 2のデモの様子を撮影したのが以下の動画。

MetaのセグメンテーションAIモデル「Segment Anything Model 2(SAM 2)」のデモを触ってみた - YouTube

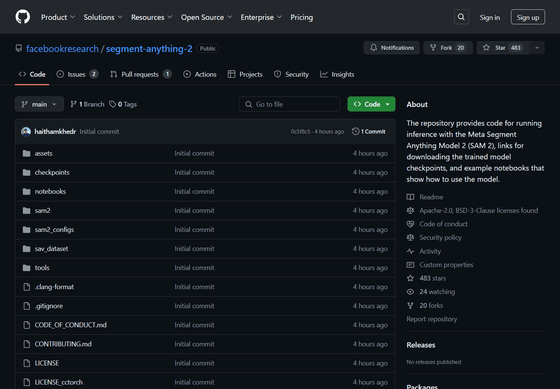

なお、SAM 2はApache 2.0ライセンスのもとオープンソース化されており、GitHubで公開されています。

GitHub - facebookresearch/segment-anything-2: The repository provides code for running inference with the Meta Segment Anything Model 2 (SAM 2), links for downloading the trained model checkpoints, and example notebooks that show how to use the model.

https://github.com/facebookresearch/segment-anything-2

これに加えて、MetaはSAM 2のトレーニングに利用したデータセットの「SA-V」をCC BY 4.0ライセンスのもと公開しています。

SA-V | Meta AI Research

https://ai.meta.com/datasets/segment-anything-video/

・関連記事

MetaがGPT-4超えのAIモデル「Llama 3.1」をリリース - GIGAZINE

MetaがAIで生成されたコンテンツを示す「Made with AI」ラベルの名称を「AI info」に変更、写真家からの苦情が原因 - GIGAZINE

Metaが本物の写真に「AI製」というラベルを付けているという報告 - GIGAZINE

MetaがFacebookとInstagramの投稿でAIを強化する計画をEUで一時停止へ - GIGAZINE

MetaがGPT-4超えのAIモデル「Llama 3.1」をリリース - GIGAZINE

手描きからデジタルへと映画の背景技術はどのように進化してきたのか、そしてAI時代にどうなっていくのか? - GIGAZINE

・関連コンテンツ

in AI, 動画, ソフトウェア, Posted by logu_ii

You can read the machine translated English article Meta releases 'Segment Anything Model 2 ….