Metaが写真に写っている物体を分離して選択できるAIモデル「Segment Anything Model」を公開

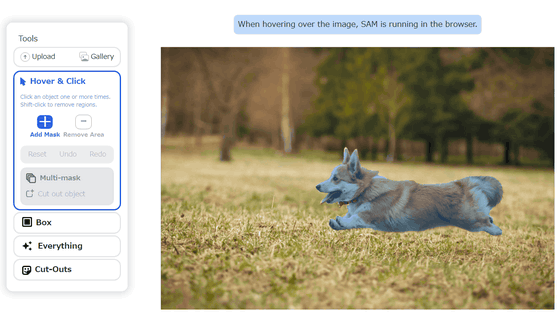

Metaが、画像や動画内に写っている個々のオブジェクトを、学習しなかったものまで識別できるAIモデル「Segment Anything Model(SAM)」を発表しました。

Segment Anything | Meta AI Research

https://ai.facebook.com/research/publications/segment-anything/

Introducing Segment Anything: Working toward the first foundation model for image segmentation

https://ai.facebook.com/blog/segment-anything-foundation-model-image-segmentation/

画像やムービーを分割してセグメントごとに判別する「画像セグメンテーション」は画像の解析や処理を容易にするため、Metaは画像セグメンテーションがウェブページのコンテンツ理解や拡張現実(AR)アプリ、画像編集に役立つとみています。さらに、動画上に映った動物や物体の位置を自動的に特定することで科学研究にも応用できるとしています。

SAMがどれだけ精度の高い画像セグメンテーションを実現できるのかは、Metaが示した以下の例を見るとよくわかります。例えば、キッチンの風景の写真。

SAMで画像セグメンテーションを行うとこんな感じ。包丁1本1本やカゴの中のレモン1つ1つをしっかりと識別しており、さらに包丁は刃の部分と持ち手の部分も識別しています。

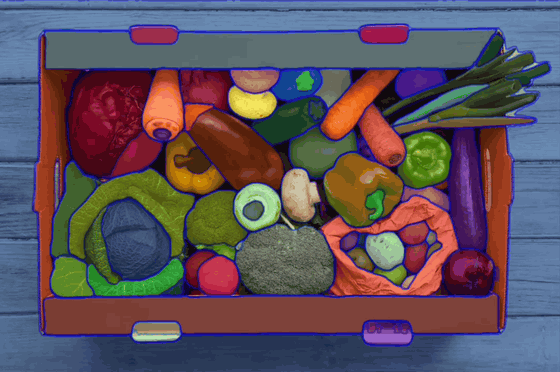

野菜が詰まった箱の写真

野菜をそれぞれ個別に認識可能。

ドラッグ&ドロップで範囲選択すると、その範囲に含まれる野菜だけが選択されました。

あらかじめ用意された写真で実際に画像セグメンテーションを行うデモは以下で公開されており、自分でアップロードした画像でも画像セグメンテーションを行うことが可能です。

Segment Anything | Meta AI

https://segment-anything.com/demo

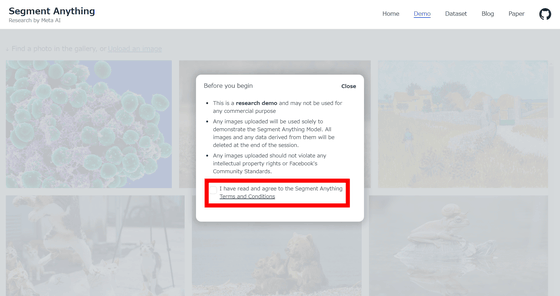

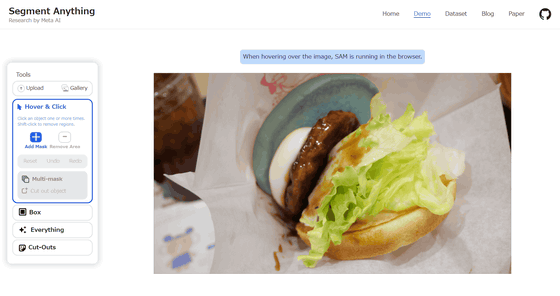

SAMのデモにアクセスしたら、「I have read and agree to the Segment Anything Terms and Conditions(私は、Segment Anythingの規約を読み、これに同意します)」をクリックしてチェックします。

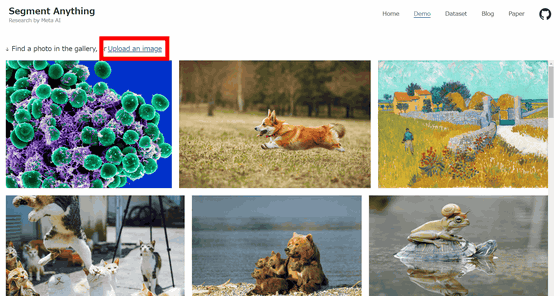

チェックを入れたら、画面上部にある「Upload an image」をクリック。すると、エクスプローラーが起動するので読み込ませたい画像を選択します。

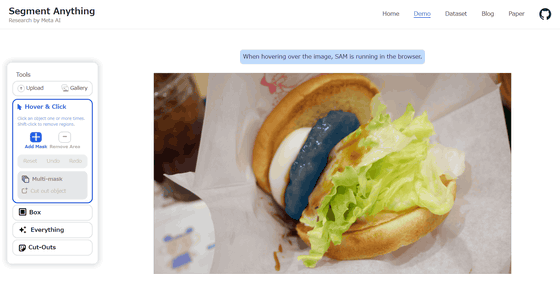

今回はとろったまチーズ テリヤキバーガー ~北海道産ゴーダチーズ使用~の画像をアップしてみました。パティをクリックすると、パティの部分だけがちゃんと選択されました。

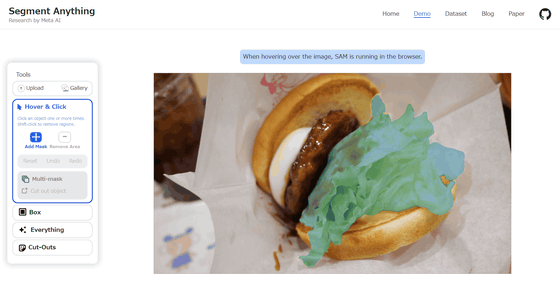

レタスを選択させるとこんな感じ。

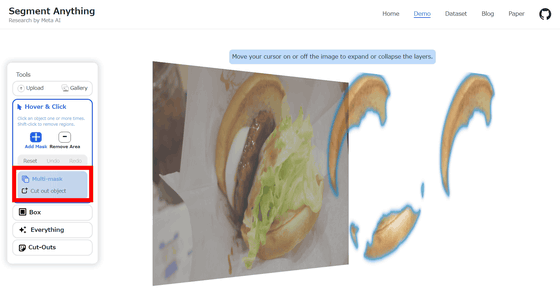

バンズの部分をクリックすると、以下のようにバンズ部分だけが青色に変わります。

さらに左カラムにある「multi-mask」をクリックすると、バンズの部分だけが飛び出て立体的に表示されました。また、同じレイヤーにあるものも自動で切り抜かれるとのことで、上のバンズだけではなく下のバンズも浮き上がりました。

SAMは画像セグメンテーションモデルとされており、テキストプロンプトやユーザーによるクリックに反応して、画像内の特定のオブジェクトを切り分けることが可能です。画像セグメンテーション技術自体は新しいものではありませんが、トレーニングデータセットに存在しないオブジェクトも識別可能であるというのがSAMの特徴です。

Metaによれば、通常だと精度の高い画像セグメンテーションモデルを作成するには「AIトレーニングインフラストラクチャと、慎重に注釈付けされた大量のデータを利用できる技術専門家による高度な専門作業が必要」とのことですが、SAMはこの専門的なトレーニングや専門知識の必要性を減らすことで「画像セグメンテーションの民主化」を行い、コンピュータービジョンの研究がさらに促進されることを期待しています。

SAMのトレーニングに用いられたSA-1Bデータセットは、大手写真会社からライセンスを受けてMetaのデータエンジンで収集された約11億の高品質セグメンテーションマスクで構成されており、Apache 2.0のオープンライセンスの下で研究目的での利用が可能となっています。

また、SAMの重みデータを除いたソースコードはGitHubで公開されています。

GitHub - facebookresearch/segment-anything: The repository provides code for running inference with the SegmentAnything Model (SAM), links for downloading the trained model checkpoints, and example notebooks that show how to use the model.

https://github.com/facebookresearch/segment-anything

・関連記事

ChatGPTに匹敵する性能の日本語対応チャットAI「Vicuna-13B」のデータが公開され一般家庭のPC上で動作可能に - GIGAZINE

Metaの大規模言語モデル「LLaMA」をM1搭載Macで実行可能にした「llama.cpp」がアップデートによりわずか6GB未満のメモリ使用量で実行可能に - GIGAZINE

ChatGPTやGoogleのBardに匹敵する精度の日本語対応チャットAI「Vicuna-13B」が公開されたので使ってみた - GIGAZINE

テキストから動画を生成できるAI「Runway Gen 2」登場、ジェネレーティブAIの主戦場はついに映像へ - GIGAZINE

チャットAI「LLaMA」を一発でローカルにインストールして「文章の続きを書く機能」を試せる「Dalai」使い方まとめ - GIGAZINE

・関連コンテンツ