アーティストがAIによるスタイルのコピーを防ぐための無料ツール「Glaze」がクラックされて突破されたことが明らかに

シカゴ大学の研究チームが提供している、人間が描いた絵画に対し目に見えない改変を加えてAIによる学習から保護するためのツール「Glaze」について、スイスのオンラインセキュリティ研究者らのチームが「Glazeの保護は簡単に回避可能」と指摘する論文を発表しました。

[2406.12027] Adversarial Perturbations Cannot Reliably Protect Artists From Generative AI

https://arxiv.org/abs/2406.12027

Glazing over security | SPY Lab

https://spylab.ai/blog/glaze/

Why I attack

https://nicholas.carlini.com/writing/2024/why-i-attack.html

Tool preventing AI mimicry cracked; artists wonder what’s next | Ars Technica

https://arstechnica.com/tech-policy/2024/07/glaze-a-tool-protecting-artists-from-ai-bypassed-by-attack-as-demand-spikes/

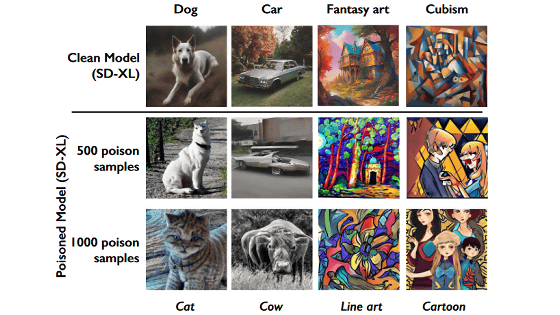

シカゴ大学のチョウ・ベン氏らが開発した「Glaze」とは、各画像に対して目に見えない「摂動」を適用することで、AIが作者の芸術的スタイルを学習することができなくなり「○○っぽい画像」といったキーワードでの画像生成が困難になるというツールです。開発チームによる実例では、オリジナルのアートにGlazeを適用して生成された「クロークアートワーク」を学習したAIは、元の画像の模倣に失敗しています。

オリジナルのアートに目に見えない改変を加えてAIによる学習を防ぐツール「Glaze」が公開 - GIGAZINE

ツールの公開以降、Glazeはアーティストからの大きな人気を集めており、海外メディアのArs Technicaによると、何百万人ものアーティストがGlazeをダウンロードしているほか、ウェブ版のGlazeである「WebGlaze」を利用するには数週間から数カ月もの待ち時間が発生しているとのこと。これを受けて開発チームは「需要の爆発的な増加を考えると、今すぐにWebGlazeの運用方法を見直す必要があります」と語っています。

Clearly I have to step back and rethink the way we run webglaze right now, given the (likely sustained) explosion in demand. We might have to change the way we do invites and rethink the future of webglaze to keep it sustainable enough to support a large & growing user base.

— Glaze at UChicago (@TheGlazeProject) June 15, 2024

また、開発チームはGlazeの発表の際に「残念ながらGlazeは画像生成AIの模倣に対する恒久的な解決策ではありません」「Glazeのようなアートを保護するために使用する技術は、画像生成AIの将来的な対策によって克服され、これまで保護されていたアートを脆弱(ぜいじゃく)にする可能性があります」と提起していました。

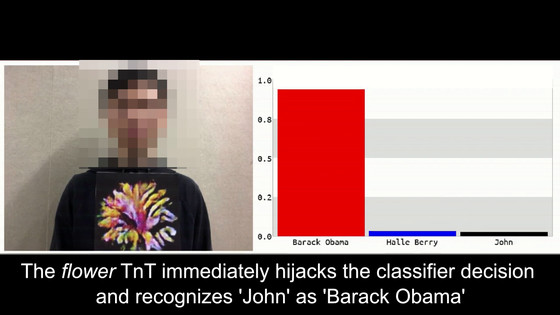

この懸念は現実のものとなり、Google DeepMindの研究者であるニコラス・カルリーニ氏らの研究チームは「Glazeの保護は簡単に回避可能で、アーティストはスタイルの模倣に対して脆弱になる可能性がある」と主張しています。研究チームが公開したGlazeの保護を突破する方法は、画像のアップスケーリングや新しいデータでAIをトレーニングする際に「別の微調整スクリプトを使用する」「トレーニング前に画像にガウスノイズを適用する」といったものです。研究チームは「これらの手法を適用することで、既存の保護を大幅に低下させることが可能です」と指摘しています。

この指摘に対し、チョウ氏は「研究チームによる攻撃のほとんどは、以前のバージョンのGlazeを標的としていたため、攻撃による影響は限定的です」と述べ、研究チームが使用したコードとは異なるコードを使用するGlazeのアップデートを実施。しかし、研究チームのロベルト・ヘーニヒ氏は「Glazeの最新バージョンでも、今回の攻撃の全てを保護できるわけではありません」と語りました。実際に研究チームによると、最新版のGlazeが適用されていたとしても元の画像に微調整スクリプトを適用するだけで「マンガ調で」といったキーワードでの画像生成が可能になるとのこと。

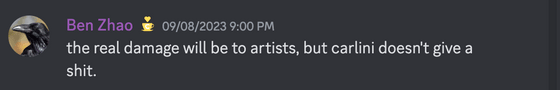

また、チョウ氏は研究チームからの指摘に対し「この報告は対応するに値しません」と一蹴しています。研究チームはこのチョウ氏の発言に対し「誤解を招きかねない」と批判しました。

研究チームは「Glazeの潜在的な脆弱性をアーティストに周知させるためにできるだけ早くGlazeによる保護の突破手段を公開する方が好ましい」と考え、Glazeのアップデートを待たずに攻撃の実行方法の詳細を公開したそうです。また、研究チームは「時には、これらの攻撃方法を複数組み合わせる必要がありますが、やる気があり、十分なリソースを持つ芸術偽造者が、Glazeの保護を突破するためにさまざまな方法を試す可能性があります」と警告。

さらに「アーティストを支援するための最善の方法は、Glazeのようにツールのセキュリティ分析を拒否しながら、ツールを売り込むことではありません。アプローチに欠陥がある場合は、修正できるように脆弱性を早期に発見する必要があります。そのためにはツールをオープンソースで研究することが重要です」と提言しました。

一方でGlazeの開発チームは「アーティスト保護を維持するための方法は、Glazeのコードを適切に保護することであり、適応型攻撃への抵抗力を上げるためにコードのオープンソース化は実施しません」と述べています。

・関連記事

画像に「毒」を盛ることでAIによる画像学習を防止するツール「Nightshade」が一般公開され誰でも使用可能に - GIGAZINE

OpenAIの画像生成AI「DALL-E 3」にAI生成作品であることを示す技術標準「C2PA」を使った電子透かしの埋め込みがスタート - GIGAZINE

GoogleがAI生成コンテンツに電子透かしを入れてフェイク拡散を防ぐ「SynthID」をテキストと動画にも拡張、一体どうやって文章に透かしを入れるのか? - GIGAZINE

イラスト作品や写真作品を毒化して画像生成AIの学習を阻害できる学習防止ツール「Nightshade」 - GIGAZINE

MetaのAI施策に反発する形でアンチAIプラットフォーム「Cara」のユーザー数が1週間で17倍超に増加 - GIGAZINE

MicrosoftとAdobeが推進する「AI透かし」はどのように機能するのか - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1r_ut

You can read the machine translated English article Glaze, a free tool that allows artists t….