「NVIDIA H100 GPU」を2万4576基搭載して「Llama 3」などのトレーニングに活用されているGPUクラスターの情報をMetaが公開

「AI開発をリードするということは、ハードウェアインフラへの投資でリードするということ」として、MetaがAIのための投資として行っている、2万4000基以上のGPUを搭載したデータセンタースケールのクラスターの情報を明らかにしました。

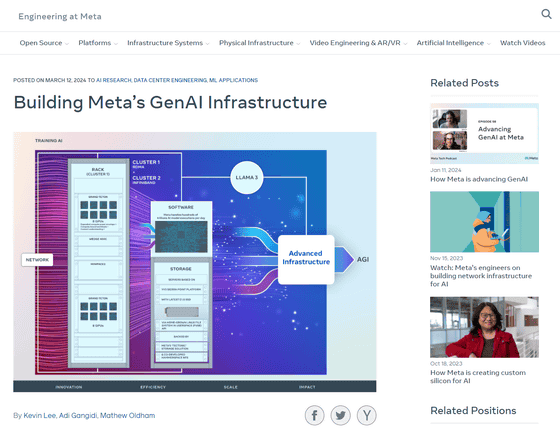

Building Meta’s GenAI Infrastructure - Engineering at Meta

https://engineering.fb.com/2024/03/12/data-center-engineering/building-metas-genai-infrastructure/

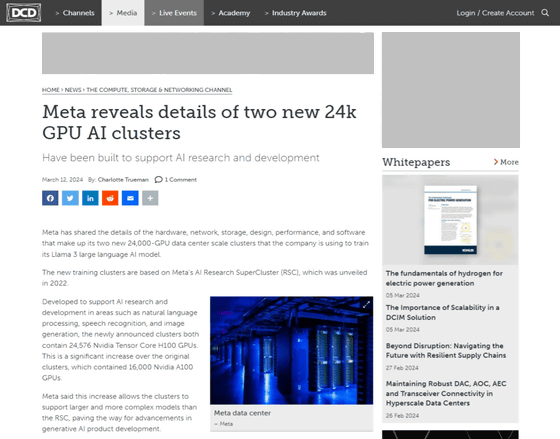

Meta reveals details of two new 24k GPU AI clusters - DCD

https://www.datacenterdynamics.com/en/news/meta-reveals-details-of-two-new-24k-gpu-ai-clusters/

2022年、MetaがGPU1万6000基を搭載した「AI Research SuperCluster(RSC)」の構築が報じられました。

1万6000個のGPUを搭載した世界最速のAIスーパーコンピューターをMetaが構築中 - GIGAZINE

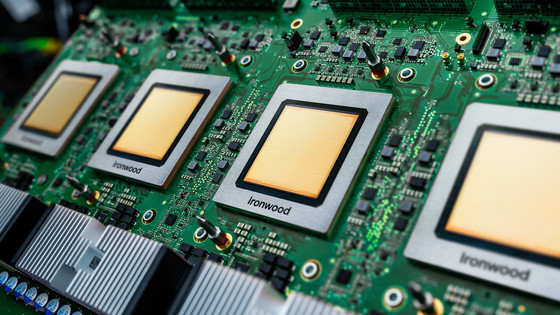

新たなGPUクラスターは、このRSCをベースとして得られた教訓などを反映して構築されていて、機械学習に最適だとされる「NVIDIA H100 GPU」を2万4576基搭載しています。Metaは2023年にNVIDIA H100 GPUを15万基購入したとみられています。

15万台のNVIDIA H100 GPUをMetaとMicrosoftが購入したとの分析、Google・Amazon・Oracleの3倍 - GIGAZINE

Metaによると、新たなGPUクラスターはRSCよりも巨大で複雑なモデルをサポートできるようになるので、生成AI開発の進歩への道が開かれるとのこと。実際に、このクラスターは一般公開されている大規模言語モデル・Llama 2の後継であるLlama 3を含む、Metaが取り組んでいる現世代および次世代のAIモデルをサポートするとともに、生成AIや、その他の分野のAI研究開発をサポートしているとのこと。

なお、Metaのインフラストラクチャロードマップにおいて、今回のGPUクラスター構築はステップの1つに過ぎず、2024年末までにNVIDIA H100 GPU35万基を含み、計算能力でいえばNVIDIA H100 GPU60万基に相当するインフラの構築を目指すとのことです。

・関連記事

Metaは「動画エコシステム」のための巨大AIモデル構築を進めている - GIGAZINE

Metaのマーク・ザッカーバーグCEOが汎用人工知能(AGI)の開発とオープンソース化を目指すと発表、35万台のH100を含む計算インフラも構築中 - GIGAZINE

Metaが2024年後半に独自設計のAIプロセッサ「Artemis」を自社データセンターに導入することが明らかに - GIGAZINE

・関連コンテンツ

in AI, ハードウェア, Posted by logc_nt

You can read the machine translated English article Meta releases information about a GPU cl….