Googleがリアルタイムに高精度なレンダリングを実現する新技術「SMERF」を発表

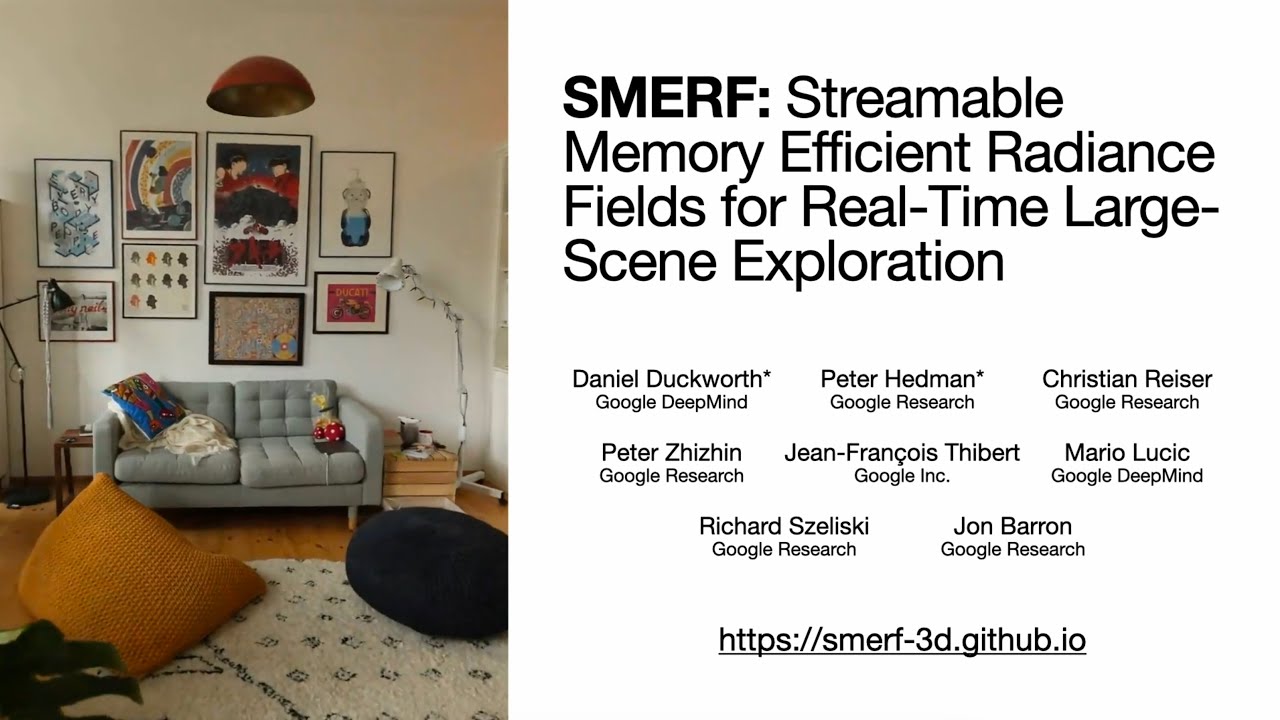

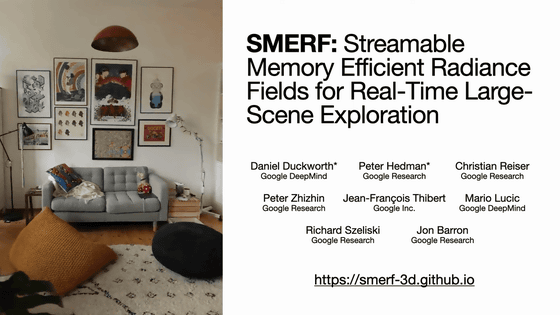

画像や映像から立体的なイメージを生み出せる「NeRF(Neural Radiance Fields:ニューラル輝度場)」や「MERF(Memory-Efficient Radiance Fields:メモリ効率のいい輝度場)」をさらに発展させ、センチメートル単位の精度のレンダリングを行いつつも必要スペックはMERF並みな「SMERF」という技術を、Googleの開発者チームが発表しました。

SMERF

https://smerf-3d.github.io/

どういった技術なのかは以下の動画を見るとわかります。

SMERF: Streamable Memory Efficient Radiance Fields for Real-Time Large-Scene Exploration - YouTube

SMERFを開発したのはGoogle DeepMindのダニエル・ダックワース氏ら。SMERFは「Streamble Memory Efficient Radiance Fields」の頭文字を取ったもので、「ストリーミング可能でメモリ効率のいい輝度場(フィールド)」となります。なお、SMERFで出力されているものについて、ダックワース氏はソーシャルニュースサイト・Hacker Newsで「画像(images)は適切な表現ではありません。従前のMERFならPNG画像に特徴ベクトルを格納していましたが、我々はそれをバイナリ配列に置き換えています」と表現しています。

NeRFは、大規模で境界のない3D風景において、ほぼ実物といえる写実的な像を出力できます。しかし、精度を高めたZip-NeRFなどはリアルタイムレンダリングには計算量が多すぎるという欠点を抱えています。

SMERFは、Zip-NeRFとほとんど差がない、わずか数cm単位のディテールまでレンダリングしつつ、計算量やメモリ要求は既存のリアルタイムレンダリング技術・MERFと同等という特徴を持ちます。

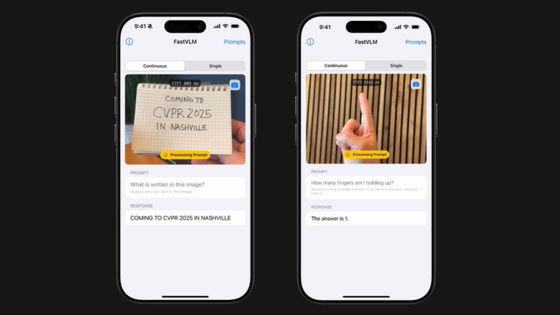

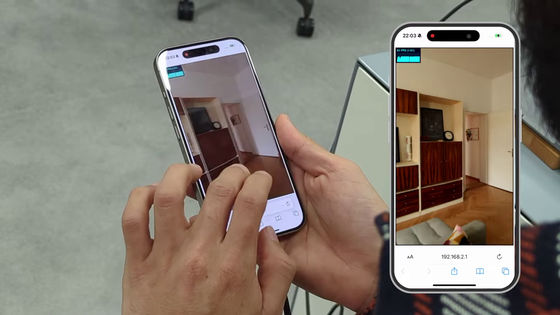

その結果、SMERFはウェブブラウザを介して一般的なノートPCやスマートフォンでも、毎秒60フレームでのレンダリングを行うことが可能です。これは、カメラ位置に基づいて風景描写を適切な位置でストリーミングすることにより実現しています。

SMERFの実現にはいくつかポイントがあります。1つめは、より小さく境界のない3D風景のリアルタイム表現です。ダックワース氏らは、MERFを基礎としつつ、視覚的再現度と幾何学的再構成の品質を大幅に改善しました。

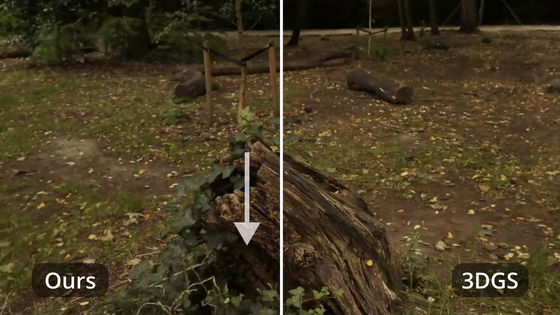

2つめは、輝度場のための新しい抽出学習法です。ダックワース氏らは、ポーズを取った写真からトレーニングするのではなく、忠実度が高い「教師」から幾何学的・測光学的情報をゆっくりと抽出しました。3D Gaussian Splatting技術などの他のリアルタイム視点合成技術の品質を凌駕しているのは、この方法のおかげだとのこと。

こうした成果物は、描写シーンの大きさに応じて表現サイズが変わるため、徹底的に取り込むには時間がかかることになりますが、SMERFの場合、カメラ位置に基づいて風景を複数の領域に分割することによって、レンダリング時間の問題を回避しています。各領域には、共通の教師に監督されたサブモデルが割り当てられます。どの時点でも、ターゲットビューを描写するには単一のサブモデルで十分であり、視覚的忠実度を低下させることなく、計算能力とメモリ要件を引き下げることができます。

窓の周辺が正しく描写されていない3D Gaussian Splattingの事例

SMERFはこの問題をかなり解決しています

3D Gaussian Splattingに比べてSMERFは鏡面や反射などをよりよく表現することが可能で、3.5mm立方という空間分解能により、300m四方までの風景を確実に再構成するとのこと。

また、3D Gaussian Splattingとは異なり、自然なレンズモデルと互換性があるため、魚眼レンズに切り替えることも可能です。

最も重要なポイントとして、ダックワース氏らは、SMERFがPCやスマートフォンで簡単に利用可能である点を挙げています。風景内のユーザー位置に基づき、最適なサブモデルパラメータをストリーミングすることで必要なメモリ使用量を抑制しているとのこと。

Hacker Newsではダックワース氏が自らユーザーへのコメント返しを行っており、たとえば「ナビゲーションに携帯電話のコンパスとジャイロを使用するモードがあれば、より自然に感じられると思います」という意見には「私も同意です。動きのUXはもっと改善できるはずです」と回答しています。

・関連記事

映像から立体モデルを構築する技術がついに「物体の形状の変化」にまで対応した「HyperNeRF」をGoogleの研究者らが開発 - GIGAZINE

ムービーを高品質な3Dデータに変換できる手法が登場 - GIGAZINE

360度カメラで撮影した動画を読み込ませるだけで3D空間を構築するソフトウェアが登場、VRにも応用可 - GIGAZINE

・関連コンテンツ

You can read the machine translated English article Google announces new technology 'SMERF' ….