ムービーを高品質な3Dデータに変換できる手法が登場

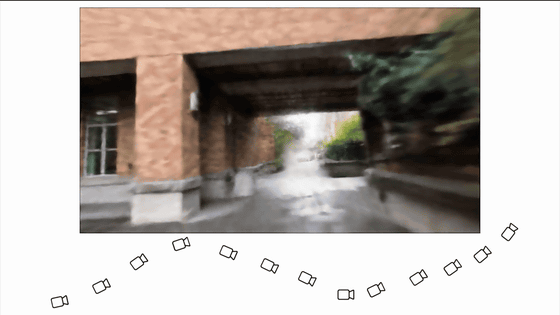

画像・映像を立体に変換する技術「Neural Radiance Fields(NeRF)」で「カメラが移動しながら撮影した長めの映像」を扱うのは難しく、どうしても品質に難がありましたが、韓国科学技術院や国立台湾大学、Meta、メリーランド大学カレッジパーク校の研究者らが、長めの映像からでも品質の高い3Dデータをレンダリングできるようになる手法を編み出しました。

[2303.13791] Progressively Optimized Local Radiance Fields for Robust View Synthesis

https://doi.org/10.48550/arXiv.2303.13791

Progressively Optimized Local Radiance Fields for Robust View Synthesis

https://localrf.github.io/

Immersive 3D Rendering from Casual Videos? - YouTube

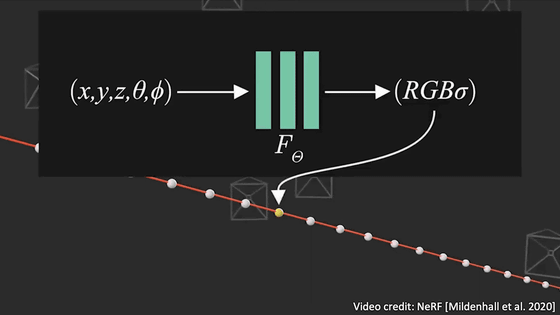

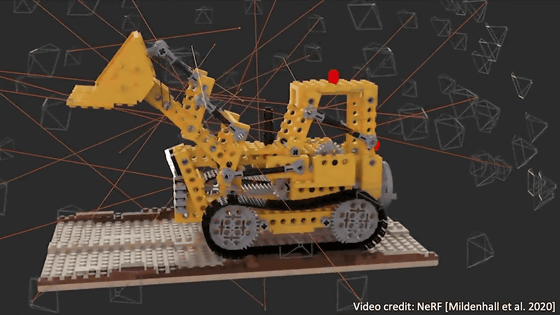

画像・映像を立体に変換する技術「Neural Radiance Fields(NeRF)」は、3次元の位置情報と視界の方向を密度や色に対応させて、ボリューム表現を最適化しています。

その後、ボリュームレンダリングを使用してピクセルをレンダリングすることができます。このレンダリングプロセスは微分可能で、すべての光線をレンダリングすることによる再構成誤差を最小化することで、シーン表現を最適化することができます。

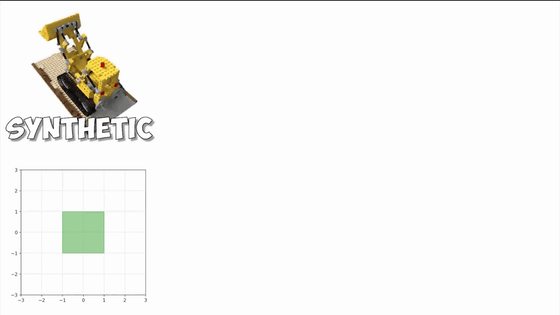

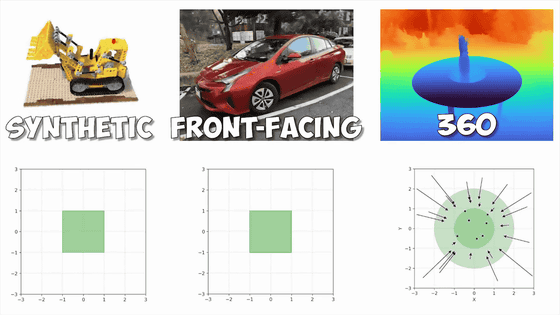

合成オブジェクトであれば有界領域で簡単に表現できるため、この方法が非常に有効です。

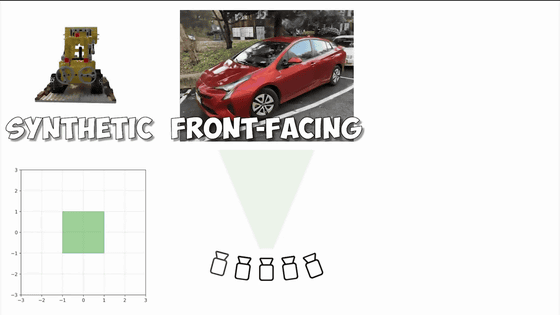

現実の風景の場合、カメラに近いオブジェクトも遠いオブジェクトも含まれるため、少し難しくなります。すべてのカメラが同じ方向を向いている場合は、正規化デバイス座標(NDC)を用いて空間を変形させ、境界を設定できます。

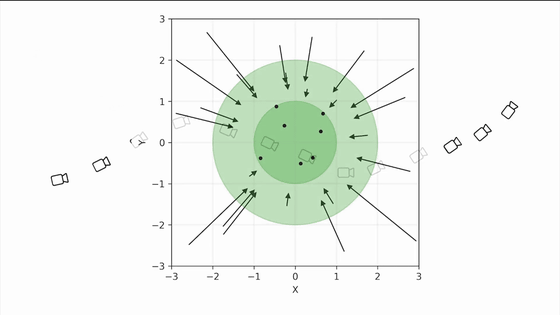

カメラが内側を向いた360度写真の場合、「Mip-NeRF 360」が空間を有界領域に滑らかに変形させるための収縮操作を提供してくれます。

しかし、難しいのが長い軌跡でキャプチャされた大規模なシーンのモデル化です。収縮技術はまだ適用できます。

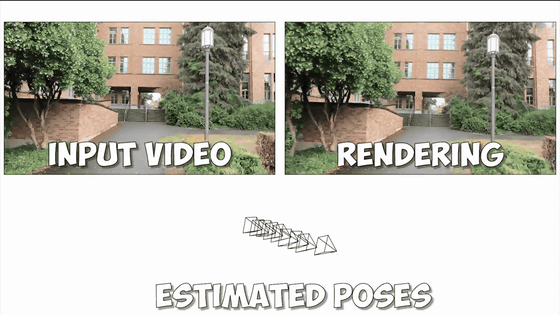

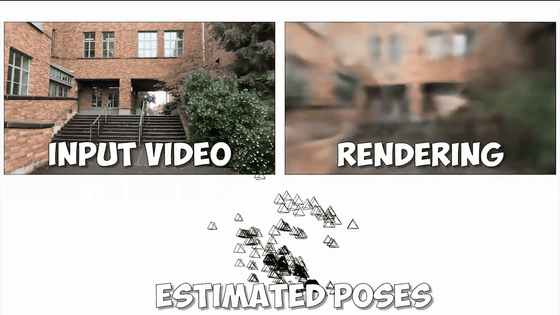

レンダリング結果は、最初は良好なように見えましたが、中心から離れるにつれて品質が低下します。

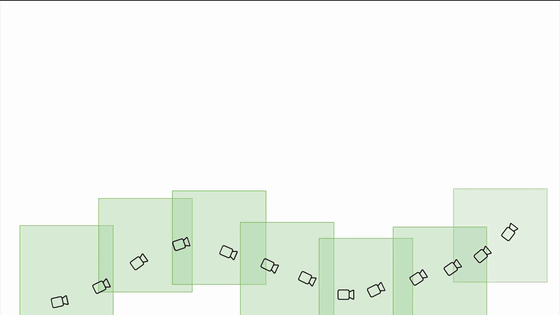

そこで研究チームが考えたのは、軌跡に沿って複数の局所的な放射輝度フィールドを作成するという方法です。

これにより、高品質な再構成・自由視点合成結果を維持しながら、非常に長いシーケンスを処理できるようになります。

残る課題はカメラの構図です。

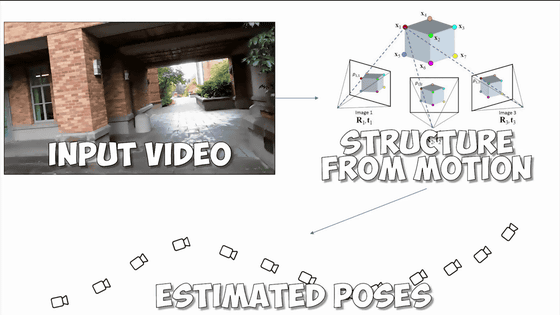

ほとんどのNeRFは、Structure from Motion(SfM)アルゴリズムを介してカメラの構図を確実に推定できることを前提としています。

しかし、SfMアルゴリズムは堅固ではないことが多く、構図の推定に失敗した場合、対処法がありません。

そこで考えられたのが、放射輝度フィールドとともにカメラプロセスを予測する手法。

これは短いシーケンスであればうまくいきますが、長いシーケンスだとうまくいきません。

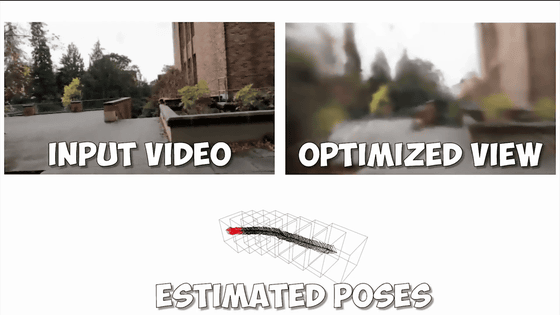

そこで研究チームは、局所的な放射輝度フィールドを作る枠組みで、カメラプロセスを漸進的に推定することにしました。局所的な推定と漸進的な推定を行うことで、より高い堅牢性が提供されることになりました。レンダリングでは、隣接する放射輝度フィールドの結果をブレンドすることにより、シームレスなトランジションを実現しています。

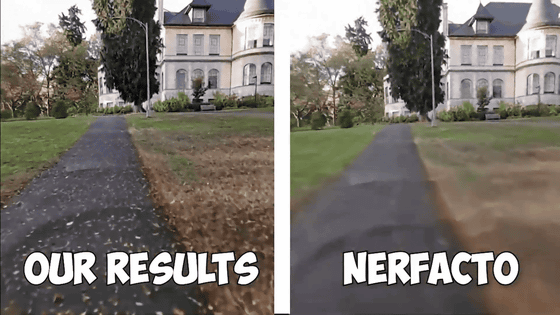

ムービー後半では、他のNeRFとの比較が行われていて、研究チームの手法が長いシーケンスでも滑らかなレンダリングに成功していることがわかります。

・関連記事

複数の静止画から3Dモデルを生成する技術「NeRF」はディープフェイクを進歩させるのか? - GIGAZINE

映像から立体モデルを構築する技術がついに「物体の形状の変化」にまで対応した「HyperNeRF」をGoogleの研究者らが開発 - GIGAZINE

静止画から3Dイメージを作成し天気や撮影時間帯もどんどん変えられる「NeRF in the Wild」 - GIGAZINE

テキストや画像から3Dモデルを生成するオープンソースのAI「Shap-E」をOpenAIが発表 - GIGAZINE

・関連コンテンツ

in 動画, Posted by logc_nt

You can read the machine translated English article A method that can convert movies into hi….