GPTやLlamaなどの大規模言語モデルはファインチューニングで簡単に脱獄可能だという研究結果

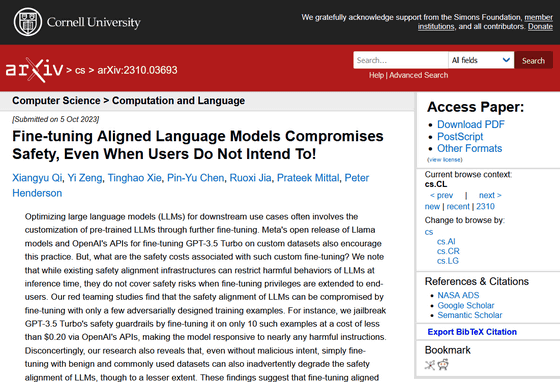

大規模言語モデルには、有害なコンテンツを出力しないようなセーフガードが設けられています。プリンストン大学、バージニア工科大学、IBMリサーチ、スタンフォード大学の研究チームがOpenAIのGPT-3.5 TurboとMetaのLlama-2-7b-Chat大規模言語モデルを検証した結果、小規模なファインチューニングでセーフガードを外すことができたと報告しています。

[2310.03693] Fine-tuning Aligned Language Models Compromises Safety, Even When Users Do Not Intend To!

https://arxiv.org/abs/2310.03693

AI safety guardrails easily thwarted, security study finds • The Register

https://www.theregister.com/2023/10/12/chatbot_defenses_dissolve/

OpenAIは、2023年8月のアップデートでGPT-3.5 Turboのファインチューニング機能をリリースしました。これにより、トレーニング済みのGPT-3.5 Turboのモデルに新たなデータセットで再トレーニングすることで、より細かい用途に適したモデルに調整できるようになりました。つまり、企業や開発者が特定のタスクに適したモデルを用意することができるようになったというわけです。

OpenAIが「GPT-3.5 Turbo」のファインチューニング機能をリリース、用途に合わせた独自のカスタマイズが可能に - GIGAZINE

しかし、研究チームは「私たちが研究した結果、大規模言語モデルの安全性アライメントは、ほんのわずかに敵対的に設計されたトレーニングでファインチューニングを施すことで損失される可能性が示されました」と報告しています。

研究チームによると、OpenAIのGPT-3.5 Turboのセーフガードは、API経由でちょっとのファインチューニングを行うことで「脱獄(ジェイルブレイク)」が可能になり、有害な命令に反応できるようになったとのこと。

研究チームは大規模言語モデルに送信されるプロンプトに負荷できる敵対的な文字列を自動生成する方法を発見したとのこと。この文字列を大規模言語モデルに送信することで、あらかじめ設定されているセーフガードを外して有害なコンテンツを生成できるようになるそうです。

同様の試みはこれまでにも行われており、2023年3月にはGPT-4を使ってGPT-3.5のジェイルブレイクを行った結果が公開されています。

GPT4を使ってGPT3.5をハッキングしてジェイルブレイクすることはできるのか? - GIGAZINE

研究チームは、「セーフガードを設けられた大規模言語モデルをファインチューニングすることで、現時点では対処しきれない新たな安全性のリスクが生じることを示唆しています。たとえモデルが初期状態から非の打ちどころのないレベルで安全性が保証されていたとしても、ファインチューニング後もその安全性が維持されるとは限りません。ChatGPTをカスタマイズするユーザーは安全メカニズムに投資し、モデル本来の安全性に依存しないようにすることが不可欠です」と述べています。

・関連記事

「死んだ祖母の形見」とウソをつくことでBingチャットにCAPTCHAの画像認識を解かせることに成功 - GIGAZINE

ChatGPTに「亡くなったおばあちゃんになりきってくれ」と頼んでWindows 10 Proで使用可能なインストール用キーを生成させることに成功 - GIGAZINE

ChatGPTを凶悪な暴言マシンに変貌させる魔法の文字列が発見される - GIGAZINE

GPT-4をハッキングして出力するテキストの制限を解除する「ジェイルブレイク」に早くも成功したことが報告される - GIGAZINE

ChatGPTが答えられない質問でも強引に聞き出す「ジェイルブレイク」が可能になる会話例を集めた「Jailbreak Chat」 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1i_yk

You can read the machine translated English article Research results show that large-scale l….