GPT-3は傾向や類似点を見いだして問題を解決する「類推」のテストで大学生を上回る能力を発揮できる

膨大なデータでトレーニングしたGPT-3やBERTなどの大規模言語モデルは、基本的には「文章の並び方に確率を割り当て、次に来るのが自然な語を予測する」というモデルです。ところが、大規模言語モデルはまるで人間のように自然な文章を生成できるほか、画像の生成やタンパク質の立体構造の予測など、さまざまなタスクにも応用することが知られています。新たにカリフォルニア大学ロサンゼルス校の研究チームが、GPT-3は特定の情報を別のものに適用して答えを推測する「類推」のタスクにおいて、大学生を上回るスコアを記録したという研究結果を発表しました。

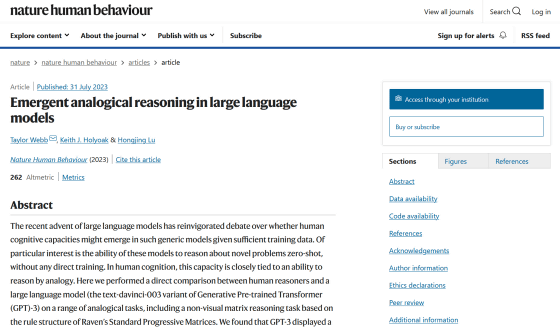

Emergent analogical reasoning in large language models | Nature Human Behaviour

http://dx.doi.org/10.1038/s41562-023-01659-w

GPT-3 can reason about as well as a college student, psychologists report: But does the technology mimic human reasoning or is it using a fundamentally new cognitive process? -- ScienceDaily

https://www.sciencedaily.com/releases/2023/07/230731110750.htm

GPT-3 aces tests of reasoning by analogy | Ars Technica

https://arstechnica.com/science/2023/07/large-language-models-beat-undergrads-on-tests-of-reasoning-via-analogy/

類推は特定の情報を別の事物に当てはめて答えを推測することであり、古典的な形式には「『愛―憎しみ』『寒い―熱い』となる場合、『裕福―○○』の○○に入るものは?」といったものが挙げられます。この場合、2つの単語はそれぞれ対義語になっているので、○○には「貧乏」といった単語が入ることが類推できるというわけです。

また、「『abcde―abcdf』『fox―foy』となる場合、『earth―○○○○○』の○○○○○に入るものは?」といったパターンもあります。この場合、文字列の末尾にあるアルファベットが一字後ろにずれたものとなっているので、「earth―○○○○○」の後ろに当てはまるのは「earti」となります。

カリフォルニア大学ロサンゼルス校の博士研究員であるテイラー・ウェッブ氏らの研究チームは、GPT-3が持っている類推の能力がどれほどのものか調べるため、「レーヴン漸進的マトリックス」という図形問題をGPT-3が処理できるようにテキストへと変換した問題や、大学進学適性試験(SAT)に含まれる問題など、さまざまな形式の類推問題を解かせました。

「レーヴン漸進的マトリックス」の解答をGPT-3とカリフォルニア大学ロサンゼルス校の学生で比較したところ、大学生の平均正答率が60%だったのに対し、GPT-3はそれを上回る80%を記録しました。また、SATのスコアを大学志願者のスコアと比較した結果も、やはりGPT-3の方が優れたパフォーマンスを発揮しました。研究チームは、「これらの結果はGPT-3が異なる領域間で柔軟に一般化できる、『successorship(継承)』という抽象的な概念を開発したことを示唆しています」と述べています。

その一方で、GPT-3は問題が提示されていると認識できないことがあり、回答の入力を求めるプロンプトが含まれていなかったり、質問が文章ではなく数値で与えられたりすると、エラー率が大きいという不具合もあったとのこと。

また、「1つの短い物語を読んで、それと似た内容の物語を2つの選択肢から選ぶ」「短い物語から教訓を読み取り、解決策のない問題の答えを出す」など、物語の要点を抽出するタスクではGPT-3よりも人間の方が優れていました。「球形のガムを段ボールの芯やはさみ、テープなどを使って取り出す方法」といった物理的な解決策を生み出すタスクにおいて、GPT-3は物理的に不可能な答えを出す傾向もみられました。これは、GPT-3が与えられた文章中で類推を行うことはできても、問題に含まれていない領域の知識から類推を働かせられないことを示唆しています。

それでも、GPT-3よりも性能が向上したGPT-4を使用していくつかの予備テストを実施したところ、GPT-3よりも大幅に優れたパフォーマンスを発揮しました。そのため、将来的には大規模言語モデルが物語の読み取りにおいて、人間を上回る可能性があるとのことです。

ウェッブ氏は、「私たちの研究結果がどれほど素晴らしくても、大規模言語モデルには大きな限界があると強調するのが大切です。大規模言語モデルは類推ができますが、道具を使って物理的な課題を解決するなど、人間にとって非常に簡単なことができません」とコメントしました。

研究チームは今後、大規模言語モデルが実際に人間のような「思考」を行っているのか、それとも単に人間の思考を模倣するまったく異なるプロセスを実行しているのかを調べるとしています。論文の共著者であるキース・ホリオーク氏は、「GPT-3は人間と同じように考えているのかもしれません。しかし、人間はインターネットのコンテンツをすべて摂取して学習したわけではなく、トレーニング方法はGPT-3と人間でまったく異なります。私たちはGPT-3が本当に人間と同じ方法で考えているのか、それともまったく新しい方法で考えているのかを知りたいのです」と述べました。

・関連記事

超高精度な言語モデル「GPT-3」は本当に「人間そのもの」な会話ができるのか実験した結果は? - GIGAZINE

AIは人間と同じように言葉の意味を「理解」しているのか? - GIGAZINE

Stability AIがChatGPTと同等の性能を持つオープンソースの大規模言語モデル「FreeWilly」を公開 - GIGAZINE

GPT-4よりも高い性能を発揮できる特定言語特化型の言語モデル「InternLM」 - GIGAZINE

チャットの相手がAIか人間かを判断するテスト「Human or Not?」で68%の人が相手を正しく判別できたとの結果が報告される - GIGAZINE

Googleがニュース記事執筆用のAIツールをテスト中、一部メディア向けにデモを実施 - GIGAZINE

・関連コンテンツ

in ソフトウェア, ネットサービス, サイエンス, Posted by log1h_ik

You can read the machine translated English article GPT-3 can demonstrate the ability to sur….