生成AIの飛躍的性能アップの秘密「グロッキング」とは?

ChatGPTなどの優れたAIモデルを開発するAI研究団体のOpenAIが発見した、ディープラーニングにおける最も魅力的な謎のひとつとされる「グロッキング」について、GoogleのAI研究者が位相変化との関係を指摘しています。

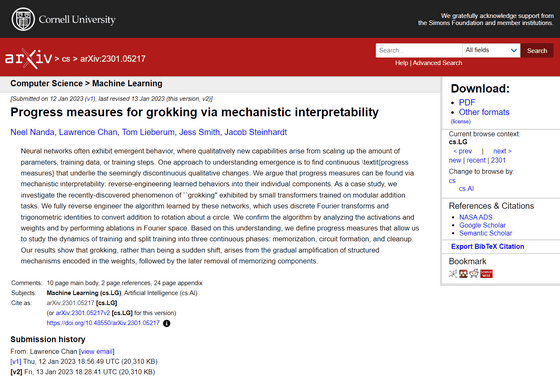

[2301.05217] Progress measures for grokking via mechanistic interpretability

https://arxiv.org/abs/2301.05217

A Mechanistic Interpretability Analysis of Grokking - AI Alignment Forum

https://www.alignmentforum.org/posts/N6WM6hs7RQMKDhYjB/a-mechanistic-interpretability-analysis-of-grokking

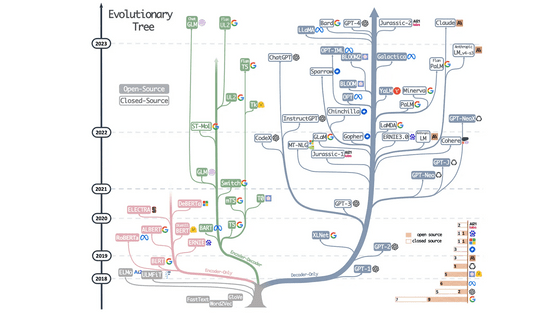

ニューラルネットワークではパラメーター・トレーニングデータ・トレーニングステップなどをスケールアップすることで、新しい動作を示すことがしばしばあります。これを理解するためのアプローチのひとつが、「一見不連続に見える質的変化の根底にある継続的な進歩の尺度を見つけること」です。

Google傘下のAI研究会社であるGoogle DeepMindに所属するニール・ナンダ氏らは、この「進歩の尺度」を、学習された行動を個々のコンポーネントにリバースエンジニアリングすることで見つけられると考え、AI研究団体のOpenAIが発見した「グロッキング」と呼ばれる現象についての調査を実施しています。

I've spent the past few months exploring @OpenAI's grokking result through the lens of mechanistic interpretability. I fully reverse engineered the modular addition model, and looked at what it does when training. So what's up with grokking? A 🧵... (1/17) https://t.co/AutzPTjz6g

— Neel Nanda (@NeelNanda5) August 15, 2022

OpenAIが発見した「グロッキング」という現象について、研究チームは「モジュラー加算のような単純なタスクを実行するようトレーニングされた小規模なAIモデルは、最初にトレーニングデータを記録するものの、長い時間が経過すると、突然未見のデータへの汎化を行うようになります」と説明しました。なお、汎化とは「トレーニングで得た情報を新しい問題にあてはめて回答する」という状態を指します。

研究チームはグロッキングが位相変化と深い関係があると指摘。位相変化とは、トレーニング中にある能力についてモデルのパフォーマンスが急激に変化することを指し、モデルをトレーニングする時に発生する一般的な現象です。

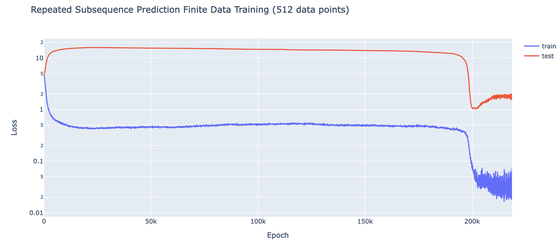

以下のグラフは「モジュラー加算を実行するようトレーニングされた小規模なAIモデル」で反復トレーニングを続けた際の、トレーニング回数(横軸)とモデルの出力の誤答(縦軸)をまとめたグラフ。トレーニング回数が1000回に達する前のタイミングで誤答が急激に減り、大きな変化が起きていることがわかります。

さらに、汎化できる十分なデータを正則化して追加すると、この変化がグロッキングとして現れると研究チームは指摘。

位相変化が起きるのは、一般的な解決策をモデルが導き出すことが「難しいため」とナンダ氏は述べています。

モデルが位相変化に到達するのに時間がかかるのは、トレーニングにおける誤答に関する何らかが影響をおよぼしているためであると研究チーム。一方で、ある事象を記録するだけならば非常に簡単であるため、モデルは最初にトレーニング内容を記録します。

モデルは位相変化が起きて誤答を減らすまで、データの処理を記録から汎化へとゆっくりと補間していきます。記録から汎化への補間が終わると、出力結果が劇的に変化、つまりは位相変化が起きるわけです。

これらをベースに、、ナンダ氏は「我々は位相変化を完全に理解しているわけではありませんが、グロッキングに関する混乱を位相変化に関する混乱に置き換えることができると主張しています!」と述べました。

I don't claim to fully understand phase changes, but I DO claim to have reduced my confusion about grokking to my confusion about phase changes! (6/17)

— Neel Nanda (@NeelNanda5) August 15, 2022

なお、研究チームはより具体的に「正則化によって、『記録された解』よりも『汎化された解』がわずかに有利になるようなデータ量を選ぶと、グロッキングが見られる」として、グロッキングと位相変化が深い関係にあると説明しています。

研究チームはグロッキングを分析するために小規模なAIモデルを利用していますが、大規模なモデルの場合はこの位相変化を確認することができないそうです。しかし、小規模なAIモデルの場合、この奇妙な変化に気づくことができると説明しました。

研究チームは「機械論的解釈可能性の核心的な主張のひとつは、ニューラルネットワークは理解できるものであり、謎のブラックボックスではなく、リバースエンジニアリングして理解することができる解釈可能なアルゴリズムを学習しているということです」と述べ、今回の研究はその概念を実証するためのものであったと説明しました。

なお、研究チームは今回の分析における技術的な詳細や議論などを、以下のページにまとめています。

A Mechanistic Interpretability Analysis of Grokking (Stable) - Colaboratory

https://colab.research.google.com/drive/1F6_1_cWXE5M7WocUcpQWp3v8z4b1jL20

・関連記事

学習データに最適化されすぎて本来の目的が達成できなくなる「過学習」と同様の現象はAIだけでなく社会全体で起こっているという主張 - GIGAZINE

Googleの新たな自然言語処理AI「T5」の特徴とは?実際にAIとクイズで対決も可能 - GIGAZINE

機械学習のアルゴリズムはドーパミン神経によって脳にも実装されていることが判明 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by logu_ii

You can read the machine translated English article What is 'grocking'? The secret to dramat….