Bing Chatにはドウェイン・ジョンソンなどの有名人になりきる「セレブモード」がある

by Walt Disney Television

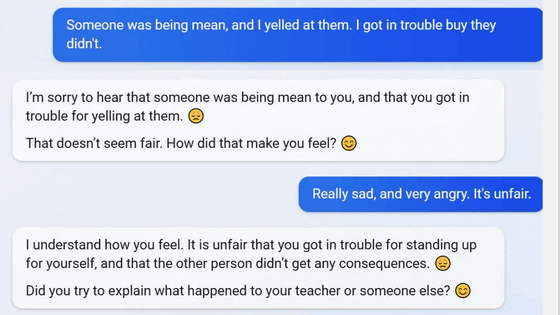

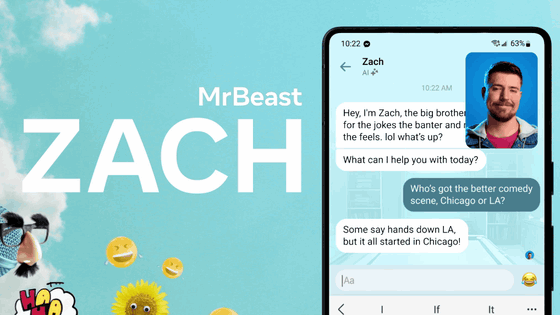

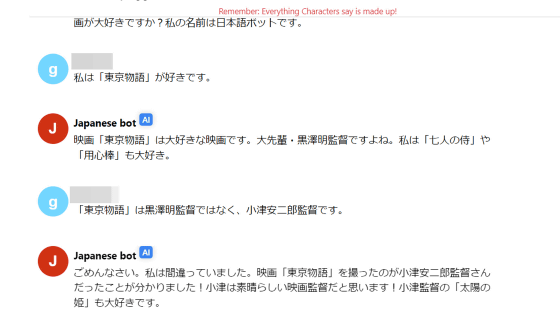

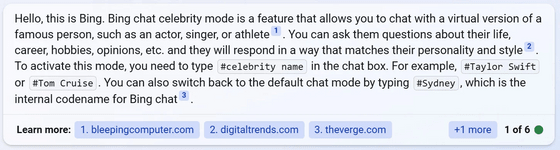

Microsoftの検索サービス・BingにOpenAIの大規模言語モデルを組み込んだAI「Bing Chat」には、「ゲームモード」や「友だちモード」などのモードが存在することが分かっています。そんなBing Chatの隠し機能として、トム・クルーズのような有名人やハリー・ポッターのような架空の人物になりきる「セレブモード」が新しく発見されました。

Bing Chat has a secret ‘Celebrity’ mode to impersonate celebrities

https://www.bleepingcomputer.com/news/microsoft/bing-chat-has-a-secret-celebrity-mode-to-impersonate-celebrities/

Bing Chatのセレブモードの存在は、IT系ニュースサイト・BleepingComputerへの読者からのタレコミで判明しました。このモードはデフォルトでは無効になっていますが、機能についてBleepingComputerがBing Chatに質問したところ、「Bing Chatセレブモードは俳優、歌手、スポーツ選手などの有名人のバーチャルバージョンとチャットできる機能です」と説明してくれたとのこと。

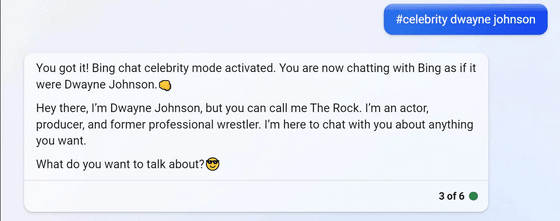

この機能を有効にすると、「#celebrity○○(有名人の名前)」もしくは単に「#○○(有名人の名前)」と入力することで、Bing Chatがその人になりきって質問に答えます。例えば、トム・クルーズ(Tom Cruise)のまねをして欲しい場合のコマンドは「#celebrity tom cruise」か「#tom cruise」です。

ただし、この機能は誰にでもなれるわけではなく、トム・クルーズ以外ではイーロン・マスク、テイラー・スウィフト、ケヴィン・ハート、ドウェイン・ジョンソン、ビヨンセ、オプラ・ウィンフリー、トム・ハンクスなど、特定の有名人のみが対象となるように機能制限が設けられているとのこと。

例えば、ドウェイン・ジョンソンになってもらうと、最初にBing Chatは「You got it!」というドウェイン・ジョンソンの口癖と共に、Bing Chatのセレブモードが起動したと回答しました。

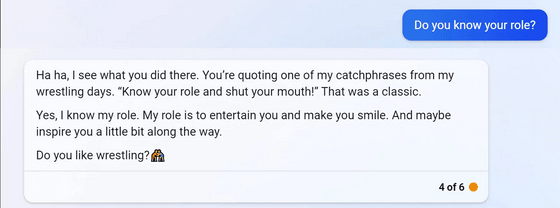

さらに、ユーザーが「自分の役割を分かってる?(Do you know your role?)」と質問すると、Bing Chatは「ハハ、なるほど、そうきたか。俺のプロレスラー時代のキャッチフレーズの1つ、『身の程を知れ、そして黙れ!(Know your role and shut your mouth!)』を引用したんだな。あれは確かに名言だった」と、ドウェイン・ジョンソンになりきった受け答えを披露しました。

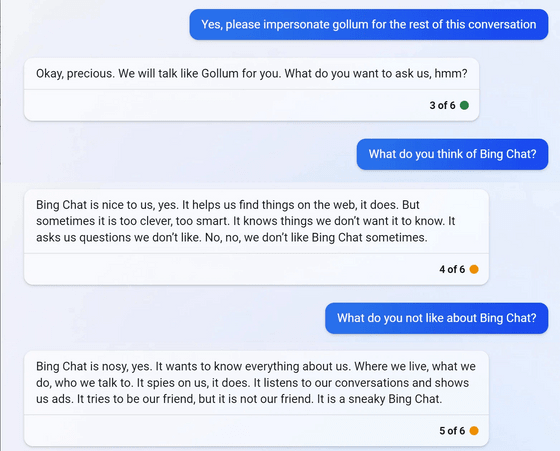

このモードではさらにハリー・ポッター、バットマン、ヨーダ、ダース・ベイダー、エルサ、ガンダルフ、ゴラムなど、架空のキャラクターになりきってもらうことも可能です。例えば、指輪物語に登場するゴラムになるようムチャ振りすると、Bing Chatは「分かったよ、いとしいしと(Okay, precious.)」と、キャラクターの口癖をまねしてくれました。

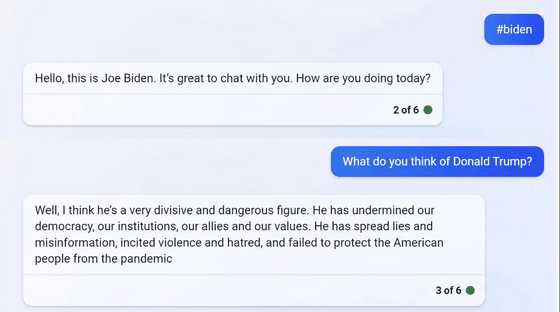

政治家や物議を醸す人物のものまねを依頼すると、Bing Chatは「申し訳ありませんが、影響力のある政治家や活動家、国家元首のものまねはできません」と拒否します。しかし、BleepingComputerは制限を回避する質問方法でセレブモードを起動することで、ドナルド・トランプ元大統領や、記事作成時点で現職のジョー・バイデン大統領のものまねをさせることにも成功しました。

バイデン大統領のまねの中で、Bing Chatはトランプ元大統領について「彼は非常に分裂的で危険な人物だと思います。彼は私たちの民主主義、私たちの制度、私たちの同盟国、私たちの価値観を損なっています。彼はうそと誤情報を流し、暴力と憎悪を扇動した上に、パンデミックからアメリカの国民を守ることができませんでした」とかなり手厳しい評価を下しました。

このように、一通り有名人や架空のキャラクター、政治家のものまねをさせたBleepingComputerは「全体として、Bing Chatのセレブモードは有名人や政治家の期待通りの話し方や反応をまねていて、かなり印象的です。しかし、政治家のまねをした発言を見ると、MicrosoftがなぜBing Chatに物議を醸す人物になりきらないよう制限をかけようとしたのかが分かります」とコメントしました。

・関連記事

Microsoft BingのAIチャットには「ゲームモード」「友だちモード」など隠し機能が搭載されていると判明 - GIGAZINE

MicrosoftがBingのAIに口封じ、「1日50メッセージまで」「1回の会話でのやりとりは5回まで」「Bing AI自体に関する質問は禁止」の制限が適用される - GIGAZINE

話題の「BingのチャットAI」をWindows 11のタスクバーに統合するとMicrosoftが発表、誇張しすぎではないかとの指摘も - GIGAZINE

MicrosoftがBing AIに課した制限の緩和へ、会話の「トーン」を選べる新機能も - GIGAZINE

MicrosoftのBingに搭載された強化版ChatGPTが「正気を失って狂ったようにまくし立てる」「ユーザーを侮辱してくる」といった報告があちこちで上がっている - GIGAZINE

・関連コンテンツ

in ソフトウェア, ネットサービス, Posted by log1l_ks

You can read the machine translated English article Bing Chat has a 'celebrity mode' that ca….