テキストで命令するだけで画像や動画を自動で加工してくれる「Text2LIVE」

画像や動画のオブジェクトを違う色にしたり、特殊な効果を付けたりといった加工をする場合、通常は画像・動画編集ソフトを用いてオブジェクトを指定したり、加工するエフェクトをオブジェクトに合わせて調整したりと、面倒な操作が必要です。そのような画像や動画の加工を、機械学習を用いて「テキストで指定するだけ」で行うことができる「Text2LIVE」がGitHubで公開されています。

GitHub - omerbt/Text2LIVE: Official Pytorch Implementation for "Text2LIVE: Text-Driven Layered Image and Video Editing" (ECCV 2022 Oral)

https://github.com/omerbt/Text2LIVE

Text2LIVE: Text-Driven Layered Image and Video Editing

https://text2live.github.io/

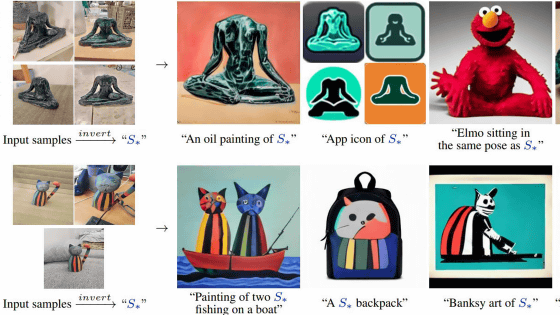

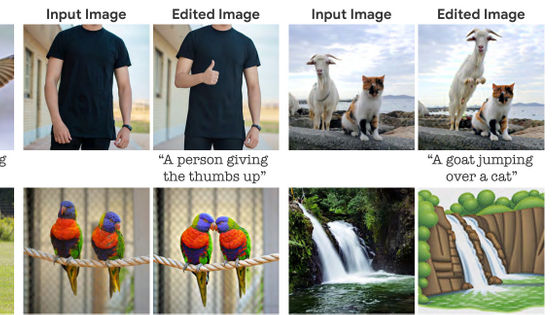

Text2LIVEは機械が見たことがないものを予測するための機械学習である「ゼロショット学習」を用いて、読み込んだ画像から指定されたオブジェクトを識別し、さらに指定した効果を付け加えるというもの。編集された出力結果を直接生成するのではなく、元の入力に合成される編集レイヤー(カラーと不透明度)を追加することが重要なアイデアとなっているとのこと。

実際どのような編集を行うことができるのか、制作者が複数の例を示しています。以下の画像では、一番左のケーキの画像を読み込んだ上で、チョコレートクッキーで白いクリームを挟んだ「オレオ」、フランスの菓子パン「ブリオッシュ」、「氷」、「スパニッシュモス(サルオガセモドキ)」という植物、でケーキの見た目を変更したもの。それぞれテキストの命令を入れるだけで、ケーキがテキストで指定したものを素材にしたかのように加工されています。一方で、ケーキの識別も自動で行っているため、「オレオ」や「氷」では、背景の卵や袋にも色が付いているのがわかります。

以下は、2匹の小鳥を「かぎ針編み」「木製」「金製」「ステンドグラス」などに編集したもの。

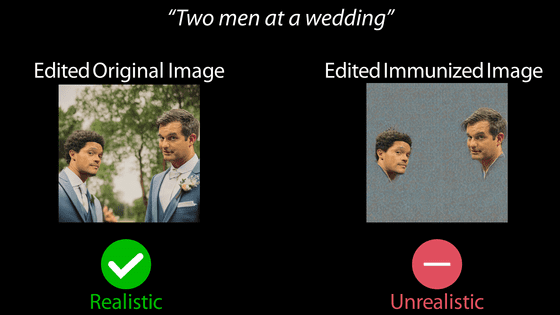

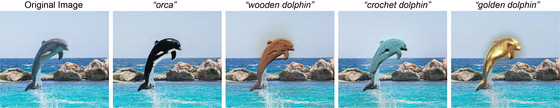

また以下では、「岩で囲われた水からジャンプするイルカ」の中から「イルカ」だけ的確に加工できているのがわかります。「木製のイルカ」「金製のイルカ」など指定することで元の画像からイルカだけ識別して見た目を置き換えているだけではなく、「シャチ」と指定することで自動的に「イルカをシャチ風に置き換える」と判断して処理を行っています。

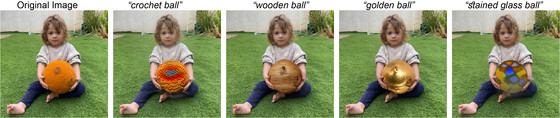

以下の画像では、コマンドに「ボール」と入れることで、子どもが持っているボールだけ見た目を変更しています。このように、メインとなるオブジェクトを背景と区別しているだけではなく、オブジェクトの種類も識別している様子。

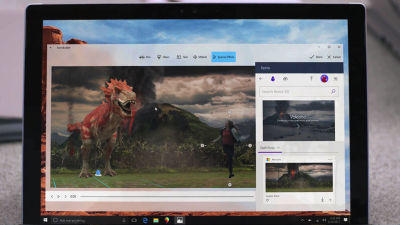

また、同様のテキストによる編集は動画でも行うことができます。以下の画像をクリックすると、ジュエリーブランドのスワロフスキー風のハクチョウや手編み風のハクチョウが、スムーズに泳いでいる動画を見ることができます。

他にも、キリンの全身を加工するだけではなく「ネックウォーマー」「カラフルなたてがみ」と指定することで、首元だけ加工するといった技があったり……

車が走っている動画では、「サイバーパンクなネオンの車」と「夜の田舎」と指定することで車と背景をそれぞれ別に加工したりと、さまざまなコマンドのテクニックが示されています。

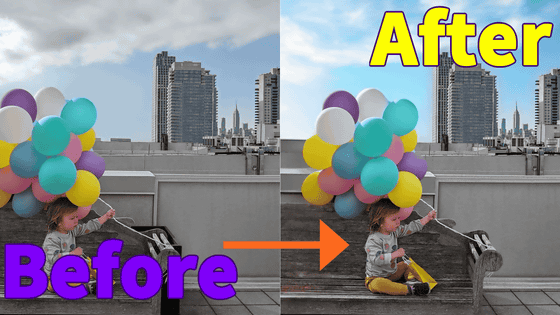

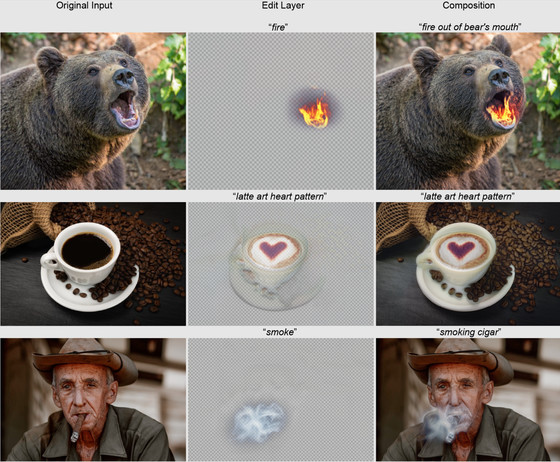

さらに、Text2LIVEにはオブジェクトや背景の見た目を追加するのではなく、背景透過レイヤーで見た目を拡張する「Semi-Transparent Effects」という機能も備わっています。クマの画像に「熊の口から出る炎」と入力することでクマ自体の見た目は変えずに口の中に火を追加したり、コーヒーの画像に「ハートのラテアート」を入力してラテアートを追加したり、煙の編集レイヤーを「葉巻の煙」と入力することで葉巻から煙が立っているように加工できたりと、テキストを入力するだけで丁寧にはめ込んだような画像加工を行うことができます。

制作者によると、Text2LIVEを使う上で必要なVRAM容量は入力する画像や動画のサイズにも左右されますが、32GBが推奨されています。また、画像を加工する精度はある程度不安定な部分を含むものの、今後さらに改善していくそうです。

・関連記事

画像生成AI「Stable Diffusion」がどのような仕組みでテキストから画像を生成するのかを詳しく図解 - GIGAZINE

画像生成AI「Stable Diffusion」でどれぐらいプロンプト・呪文の指示に従うかを決める「CFG(classifier-free guidance)」とは一体何なのか? - GIGAZINE

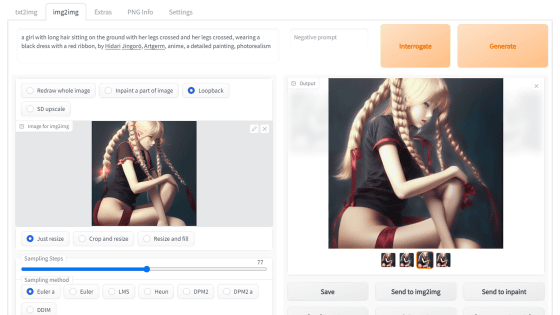

画像生成AI「Stable Diffusion web UI(AUTOMATIC1111版)」で元画像と似た構図や色彩の画像を自動生成したり指定した一部だけ変更できる「img2img」の簡単な使い方まとめ - GIGAZINE

Photoshopが一瞬で複数のオブジェクトを自動選択してそれぞれレイヤー化してくれる超絶便利な新機能「オブジェクト選択ツール」はどんな感じなのか? - GIGAZINE

現実の写真をアニメ特有の表現要素に分解してアニメっぽく再構成する「White-box-Cartoonization」 - GIGAZINE

「人間特有の手書き文字」を自動で生成する技術が開発中 - GIGAZINE

・関連コンテンツ

in ソフトウェア, デザイン, アート, Posted by log1e_dh

You can read the machine translated English article 'Text2LIVE' that automatically processes….