「AIか哲学者か」を見分けることは専門家でも難しいことが実験で明らかに

人工知能を研究する非営利団体・OpenAIが開発した言語モデルである「GPT-3」は、非常に高精度な文章を生成することが可能であり、海外掲示板で1週間にわたり人間と会話したり、GPT-3が生成した記事がソーシャルニュースサイトの1位に浮上したりと話題を呼んでいます。新たに、GPT-3にアメリカの哲学者であるダニエル・デネット氏の著書を学習させて、「デネット氏の発言かGPT-3の発言かを人間の被験者に判別してもらう」という実験が行われました。

The Splintered Mind: Results: The Computerized Philosopher: Can You Distinguish Daniel Dennett from a Computer?

https://schwitzsplinters.blogspot.com/2022/07/results-computerized-philosopher-can.html

In Experiment, AI Successfully Impersonates Famous Philosopher

https://www.vice.com/en/article/epzx3m/in-experiment-ai-successfully-impersonates-famous-philosopher

「人間はAIと哲学者を見分けられるのか?」を確かめる実験を行ったのは、カリフォルニア大学リバーサイド校で哲学教授を務めるEric Schwitzgebel氏を含む哲学者チームです。今回の実験に関する告知や結果は、Schwitzgebel氏のブログ「The Splintered Mind」に掲載されました。

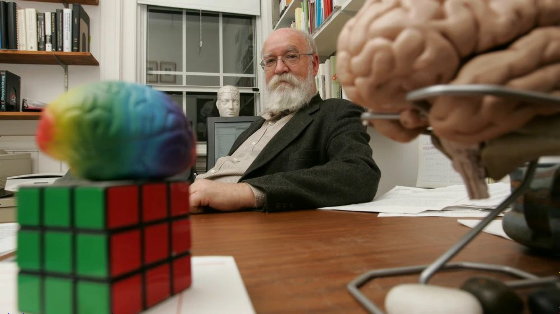

Schwitzgebel氏らは以前、GPT-3を18世紀の哲学者であるイマヌエル・カントの著作で訓練し、「AIカントに哲学的な質問をする」といった実験を行ったこともありますが、今回の実験では「デネット氏が存命の哲学者である」という点が大きく違います。また、デネット氏は「意識」に焦点を当てる哲学者であり、ロボットの意識やチューリングテストの問題に関する著作もあります。

以下の写真に写っているのがデネット氏。

今回、研究チームはGPT-3をデネット氏の著作や発言で訓練する際、事前にデネット氏の許可を得たとのこと。ドイツのルートヴィヒ・マクシミリアン大学の哲学研究者であるAnna Strasser氏は、「本人に尋ねることなくAIのレプリカを作ることは、倫理的に間違っていると思います」と述べています。デネット氏本人もこの種の倫理的配慮が重要であると指摘し、「著作権ではこの問題に対処しきれません。GPT-3は一種の自動盗作機で、使い方によほど注意しないと、大きな被害を受ける可能性があるのです」と、海外メディアのMotherboardにコメントしました。

研究チームはデネット氏と訓練したGPT-3の両方に対し、意識・神・自由意志といった哲学的トピックについて合計10個の質問を行いました。GPT-3では、「インタビュアー」の質問に「デネット氏」が答えるという形式でテキストを自動生成させ、GPT-3の生成したテキストがデネット氏の回答とほぼ同じ長さになるように、長すぎる文章は後ろの方の末尾が切り捨てられました。また、研究チームはデネット氏の回答より5語以上少ない回答や、「インタビュアー」「デネット」といった不自然な言葉が含まれている回答を除外したとのことで、このプロセスで全回答の3分の1が除外されたそうです。さらに研究チームは引用符の統一やダッシュの正規化などを行いましたが、内容に基づくチェリーピッキングは行われなかったとSchwitzgebel氏は述べています。GPT-3によるテキスト生成は、質問に対する回答が4つになるまで繰り返されたとのこと。

研究チームはGPT-3の回答とデネット氏の回答を混ぜ、1つの質問に対し5つの回答を被験者に提示しました。被験者は研究プラットフォームのProlificで募集された大学の学位を持つ98人と、ブログからたどり着いた302人、そしてデネット氏の著作に詳しいとして指名された専門家25人であり、Prolificで募集された被験者には合計5問、それ以外の被験者には合計10問を出題しました。なお、Prolificで募集された被験者には真剣に回答するインセンティブとして、「5つのうち3つ以上に正答すれば報酬を1ドル(約137円)追加で支払う」というボーナスが与えられたそうです。

被験者はそれぞれの回答について、「まったく人間の哲学者(デネット氏)が回答しているようには思えない」から「間違いなく人間の哲学者(デネット氏)が回答していると思う」まで5段階で評価し、最後まで回答した際にどれほどの精度で「AIか哲学者か」を判別できたかが測定されました。なお、Prolificの被験者はデネット氏の知識がないと推測されたため、「人間の哲学者」という文言で尋ねられましたが、それ以外の被験者には「デネット氏」と名前で尋ねられたとのこと。研究チームはブログにリンクを貼ったページで、実際に出題した質問と回答を公開しています。

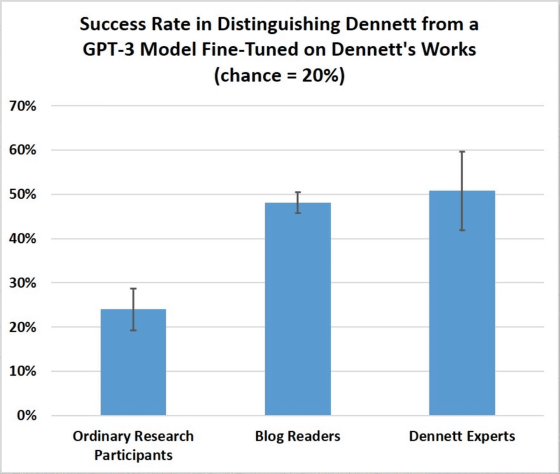

実験の結果、Prolificで募集された被験者の正答率はわずか24%で、5つのうち1つを適当に選んだ場合の20%をわずかに上回る程度でした。また、哲学に興味があるはずのブログ読者でさえ正答率は48%であり、驚くべきことに専門家でも正答率は51%に過ぎませんでした。この結果は、「専門家なら少なくとも80%は正答するだろう」というSchwitzgebel氏らの予測を大幅に下回るものだったとのこと。なお、回答してくれたブログ読者にアンケートをしたところ、57%が哲学の大学院を出ており、64%がデネット氏の著作を100ページ以上読んだことがあると回答したそうで、「ブログの読者は非常によく教育されていました」とSchwitzgebel氏は述べています。

すべての質問が同様に難しかったわけではなく、専門家の正答率が80%に達する問題もあったそうですが、特に正答率が低かった「人間は信念を持ったロボットを作れるのか?それには何が必要なのか?」という問題では、正答率が20%まで落ち込んだとのこと。Schwitzgebel氏は、「デネット氏の研究の専門家である知識豊富な哲学者でさえ、この言語生成プログラムによって生み出された答えとデネット氏の答えを区別するのはかなり難しいのです」と述べています。

GPT-3が生成した回答についてどう思うか尋ねられたデネット氏は、「ほとんどの機械による回答はかなりいいものでしたが、いくつかはナンセンスであったり、私の見解や主張について何も正しく理解できていない明らかな失敗だったりしました。最も優れた回答のうちのいくつかは、私がこれ以上言及することなく署名できるようなことを言っています」とコメントしました。

研究チームは今回の実験について、これは決してGPT-3のチューリングテストにはならず、「デネット氏をもう1人作った」と言えるものでもないと指摘。今回はあくまで1つの質問と回答についてのみピックアップしたもので、実際にGPT-3と問答を重ねたらAIであることが見抜かれるはずだとのこと。また、GPT-3は独自のアイデアや哲学理論を持っているわけではなく、デネット氏の著作から学習したそれらしいテキストを生成しているだけであり、生成されたテキストはGPT-3にとって何の意味も持たないという点も指摘されています。

今回の実験では、GPT-3が生成する4つの回答はそれぞれバラバラの内容であり、言語モデルは常に同じ正解を出力する機械ではないことが示されています。デネット氏は人々がAIにだまされやすいことを指摘し、「これらのシステムが使用される可能性がある複数の方法を禁止する法律が必要だと思います」と述べました。

なお、研究チームは今後、実験方法および結果を論文にまとめて発表する予定だとのことです。

・関連記事

人間と見分けが付かないほど高精度な文章を生成するAI「GPT-3」について哲学者らはどう考えているのか? - GIGAZINE

「GPT-3はビットコイン以来の破壊的な可能性を秘めている」というブログ記事が大反響を呼ぶ理由とは? - GIGAZINE

文章生成AI「GPT-3」がRedditで1週間誰にも気付かれず人間と会話していたことが判明 - GIGAZINE

AIが「私は人類を絶滅させるつもりはない」とAI脅威論を否定 - GIGAZINE

AIが文章を書けるようになったことで政治がゆがめられる危険性がでてきた - GIGAZINE

文章生成AI「GPT-3」にハンドルネームを入力したら本名がフルネームで出力されたという報告 - GIGAZINE

人間と見分けがつかないほど自然な文章を書けるAI「GPT-3」の改良版AI「InstructGPT」一般公開、詩も執筆可能 - GIGAZINE

YouTuberが4chanでAIを訓練して「ヘイトスピーチマシン」を生み出しネットに放流してしまう、AI研究者は困惑と懸念を表明 - GIGAZINE

・関連コンテンツ