Googleが「スマホを向けるだけ」で食品の情報を機械学習を使って読み上げてくれる機能をリリース

Googleが食品にスマートフォンのカメラを向けるだけでラベル名を読み上げてくれる「食品ラベルモード」を視覚障害者向けアプリ「Lookout」に追加しました。ラベルの識別にはオンデバイスの機械学習が用いられており、低遅延でネットワークに依存しない設計となっています。

Google AI Blog: On-device Supermarket Product Recognition

https://ai.googleblog.com/2020/07/on-device-supermarket-product.html

Googleが2019年にリリースした「Lookout」は、周囲の環境を検知して物体の存在を知らせたり、文字を読んだりして視覚障害者をサポートするAndroid向けアプリ。リリース当初は北米地域限定で配信されていましたが、記事作成時点では日本のユーザーもGoogle PlayからLookoutをインストール可能となっています。

Googleが視覚障害者の代わりに「目」となって周囲の情報を的確に伝えてくれるアプリ「Lookout」を発表 - GIGAZINE

視覚障害を患う人にとって、同じ形状の箱や缶、ビンなどに印字されたラベルだけで食料品を判別するのは困難なことですが、そんな困難を解決するためにLookoutに加わった新しい機能が「食品ラベル」モード。Lookoutの食品ラベルモードでは、ユーザーがスマートフォンのカメラを食品に向けるだけで、Lookoutが食品を識別し、ブランド名とサイズを音声で伝えてくれます。

食品ラベルモードは、クラウドではなくスマートフォンやIoTデバイス単体で機械学習を行う「オンデバイス」の機械学習によって実現されています。オンデバイス機械学習は、クラウドによる機械学習と比較して、低遅延でネットワークに依存しないというメリットがあるとのこと。GoogleはこれまでもPixel 4にオンデバイス機械学習用チップ「MobileNetEdgeTPU」を搭載したり、オンデバイス機械学習向けライブラリ「ML Kit」をリリースしたりと、オンデバイスの機械学習分野をハードウェア・ソフトウェアの両面でサポートしていました。

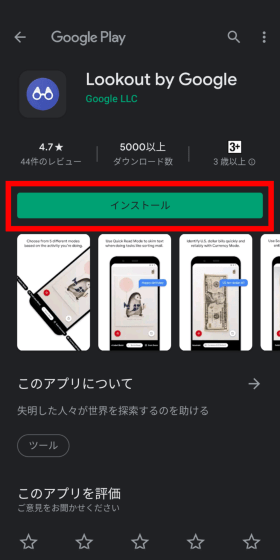

記事作成時点では日本国内でもインストール可能なので、Lookoutの食品ラベルモードを使ってみます。まずは下記URLにスマートフォンからアクセス。Lookoutは2GB以上のRAMを搭載し、Androidのバージョンが6.0以上のスマートフォンで利用可能です。

Lookout by Google - Google Play のアプリ

https://play.google.com/store/apps/details?id=com.google.android.apps.accessibility.reveal&hl=ja

Google Playが起動したら「インストール」をタップ。

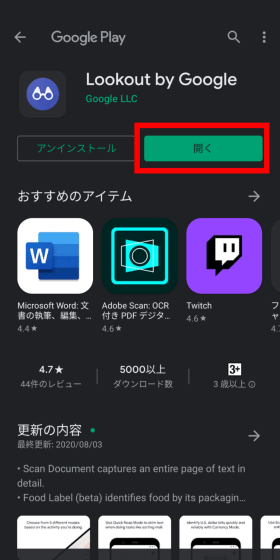

インストールが完了したら「開く」をタップします。

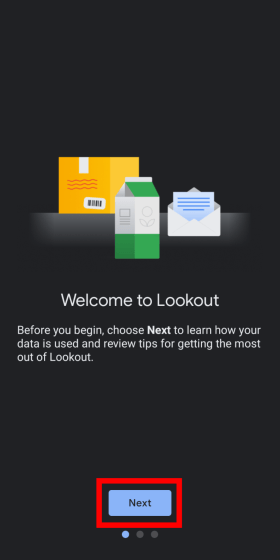

Lookoutが起動するので「Next」をタップ。記事作成時点では日本語には対応していません。

「I agree」をタップしてデータの収集に同意。

「Get started」をタップ。

日本国内でもLookoutのインストール自体は可能ですが、まだ日本向けに最適化は行われていない模様。「OK」をタップして先へ進みます。

食品ラベルモードでは、バーコードや食品の前面にカメラを向けることで、食品ラベルの認識を行うとのこと。「OK」をタップ。

Lookoutはオンデバイスの機械学習を行うので、事前にデータセットをダウンロードしておく必要があります。ダウンロードするデータのサイズは250MBとのこと。「Download」をタップして、データをダウンロードします。

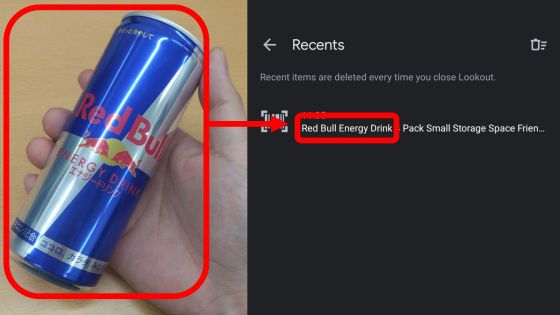

データのダウンロードが完了すると、カメラが起動して食品ラベルを読み取れる状態になりました。試しに国内と海外でパッケージのデザインが同じレッドブルにカメラを向けてみると、「レッドブル エナジードリンク」と商品名を読み上げてくれました。

左側のボタンで読み取りの一時停止と再開、右側のボタンで読み取った食品の履歴を確認できます。

履歴を確認してみると、レッドブルの商品名がきちんと履歴に残っていました。

試しに国内向けの食品にカメラを向けてみましたが、反応はありませんでした。

Lookoutの食品ラベルモードは、アレルギー源や栄養情報、顧客評価、製品比較、価格追跡など、さまざまな新しいショッピング体験を可能にするとのこと。Googleはアプリケーションの機能をさらに探求するとともに、基礎となるオンデバイスモデルの品質を向上させ、より堅固なものにしていくための研究を継続していくとコメントしています。

・関連記事

Googleが視覚障害者の代わりに「目」となって周囲の情報を的確に伝えてくれるアプリ「Lookout」を発表 - GIGAZINE

GoogleがPixel 4などでの次世代オンデバイス処理には欠かせないと言及する「MobileNetV3」と「MobileNetEdgeTPU」について解説 - GIGAZINE

超高精度な言語モデル「GPT-3」は本当に「人間そのもの」な会話ができるのか実験した結果は? - GIGAZINE

「AI」と「機械学習」は何がどのように違うのか?をわかりやすく解説するとこうなる - GIGAZINE

「Google アシスタント」の利用者数が90カ国以上で5億人を突破、テキスト読み上げは42言語対応へ - GIGAZINE

・関連コンテンツ

in レビュー, ソフトウェア, Posted by darkhorse_log

You can read the machine translated English article Google releases a function to read out f….