従来の3倍以上も高速で消費電力の94%を削減するニューラルネットワーク用チップをMITが開発

MITの研究者が、従来よりも3倍以上高速に計算処理でき消費電力を94%も削減できるニューラルネットワーク用のチップを開発しました。

Neural networks everywhere | MIT News

http://news.mit.edu/2018/chip-neural-networks-battery-powered-devices-0214

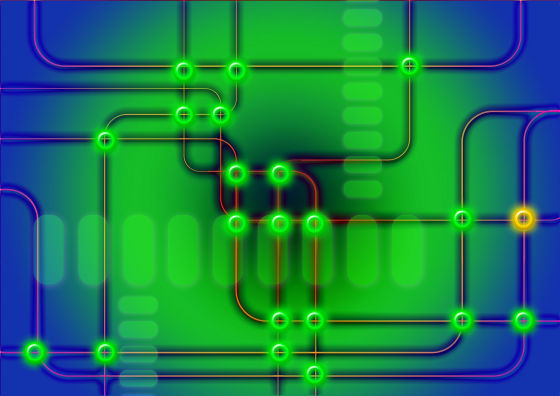

一般的なプロセッサモデルでは、チップ内のプロセッサとメモリが分かれており演算を行う時にメモリとCPU間でデータの受け渡しが行われます。そのため、「大量の計算処理が行われる機械学習アルゴリズムでは、データ転送がエネルギー消費の支配的な要因になっています」とMITコンピューターサイエンスの学生アビシェック・ビスワスさんは話します。そこで、機械学習アルゴリズムの計算を「ドットプロダクト」と呼ばれる特定の操作に単純化してメモリ内に実装することで、データをCPUとメモリで往復させる処理を避けることで、演算の高速化と省電力化を実現しようというのが、新しく開発したニューラルネットワーク用のチップです。

ニューラルネットワークは典型的にはレイヤー内に配置されます。ネットワークの一つのレイヤーでの単一の処理ノードは、一般的には下位のレイヤーにあるいくつかのノードからデータを受信して、上位レイヤーのいくつかのノードにデータを渡します。ノード間のそれぞれの接続は、独自の「重み」を持っています。重みとは、次のノードが実行する計算においてどれだけ大きな役割を果たすかを示す指標で、ニューラルネットワークでの「トレーニング」とは、重みを設定する作業です。

下部レイヤー内の複数のノードからデータを受信するノードは、それぞれの入力に対応する接続の重みをかけた結果を足し合わせる計算が「ドットプロダクト」の定義。ドットプロダクトがあるしきい値を超えると、ノードはそれ自体の重みをもつ接続を通じて、次の層のノードにドットプロダクトを送信するという作業を行うとのこと。

今回、ビスワスさんたちが開発したチップでは、ノードの入力値は電圧に変換され、その後、重みを乗算します。ドットプロダクトを合算するのは単に電圧を足し合わせることになり、合わさった電圧だけがデジタル情報としてのちの処理のために保存するという仕組み。これによってチップは複数のノードに対してドットプロダクトを計算することができ、試作段階で1つのステップでメモリとCPU間でデータをやり取りすることなくドットプロダクト16回分を計算できたそうです。

MITによると、新チップによって現時点でニューラルネットワークの計算速度を従来の3倍から7倍に向上させることに成功しており、消費電力は94~95%も削減することに成功しているのこと。これまでスマートフォンなどのアプリでは、サーバーにデータをアップロードしてサーバー上で計算処理した結果を返していましたが、新チップであればローカル(端末側)でニューラルネットワークを実行できると考えています。

・関連記事

ARMが新AIプロセッサ「ARM Machine Learning」を発表、クラウドなしで端末による機械学習処理が可能に - GIGAZINE

Intelがクラウドに依存せずチップ単体で自律的に学習していけるAIチップ「Loihi」を開発中 - GIGAZINE

極小サイズでディープニューラルネットワークを単独処理できる専用チップ「Myriad X」をIntelが発表 - GIGAZINE

世界初のAIプロセッサ「NPU」を搭載するSoC「Kirin 970」はモバイルAI時代を切り開く - GIGAZINE

iPhone 8/Xの「A11 Bionic」はMacBook ProのIntel Core i5を凌駕する性能を持つ - GIGAZINE

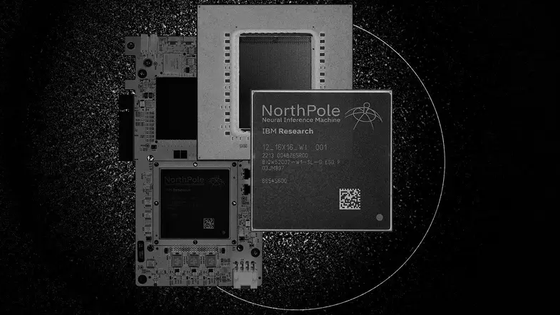

IBMの「脳」を模した超省電力チップ「TrueNorth」が着実に進化、ネズミの脳レベルに到達 - GIGAZINE

AIを実現する「ニューラルネットワーク」を自動的に構築することが可能なAIが出現 - GIGAZINE

・関連コンテンツ

in ハードウェア, Posted by darkhorse_log

You can read the machine translated English article MIT develops chips for neural networks t….