Googleの人工知能や機械学習をスマホのカメラやお絵かきで体験できるデモ集「A.I. Experiments」

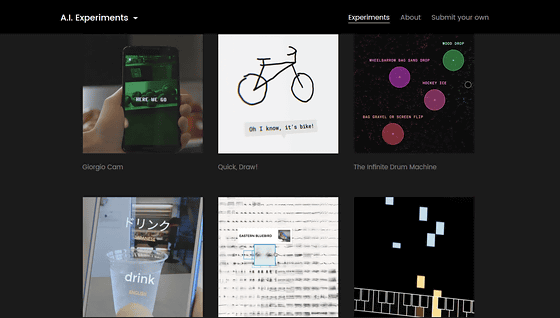

Googleが開発中の機械学習や人工知能を使ったコンテンツのデモンストレーションや体験版を集めたのが「A.I. Experiments」です。A.I. Experimentsには、機械学習を用いたアプリや、ニューラルネットワークを使ったお絵かきゲームなどが入っていて、人工知能で何ができるかがわかるコンテンツを実際に体験できるようになっています。

A.I. Experiments

https://aiexperiments.withgoogle.com/

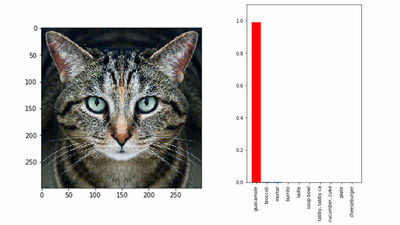

◆Giorgio Cam

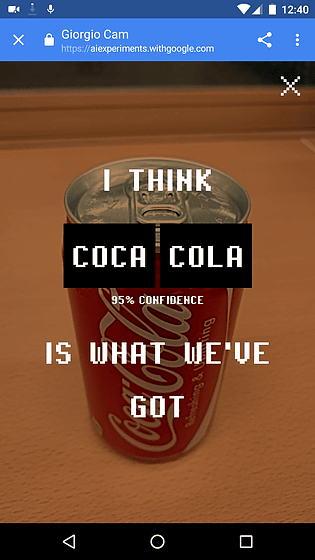

「Giorgio Cam」はスマートフォンのカメラで物体を写すと、認識した物体に関する歌詞を音楽に合わせて即興で作り出すという機械学習を用いたアプリ。実際にGiorgio Camを使っている様子は、以下のムービーから見ることができます。

A.I. Experiments: Giorgio Cam - YouTube

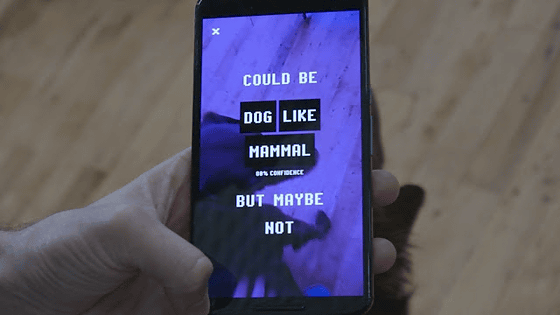

Giorgio Camは機械学習で画像を認識するGoogleの「Cloud Vision API」とオープンソースの音声合成システム「MaryTTS」という、画像認識と音声合成の技術を掛け合わせたアプリとなっています。例えばスマートフォンで以下のように犬を写すと、再生されている音楽に合わせて「Could be dog like mammal, but maybe not, not, not...(多分ほ乳類というか犬、だけどそうじゃないかも)」と言う風に、ただ単に「犬」と答えるのではなく、物体について即興で歌詞を作ってラップ風に歌ってくれます。

なお、一体どんなアプリなのかは以下のページからデモを体験可能。PC・Androidスマートフォンの両方に対応していますが、カメラを使う必要があるのでスマートフォンで使ってみることをオススメします。

Giorgio Cam

https://aiexperiments.withgoogle.com/giorgio-cam/view/

実際にコカコーラの缶を写してみたところ、軽快なリズムでコカコーラのラップを披露してくれました。ちょっと認識しづらいものだと、逆に面白い歌詞ができることもあり、人工知能や機械学習に触れるデモとしては最適と言えます。

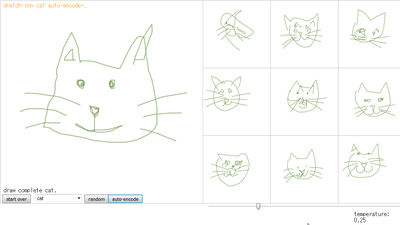

◆Quick, Draw!

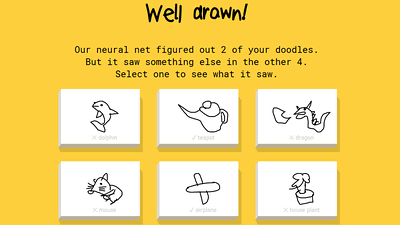

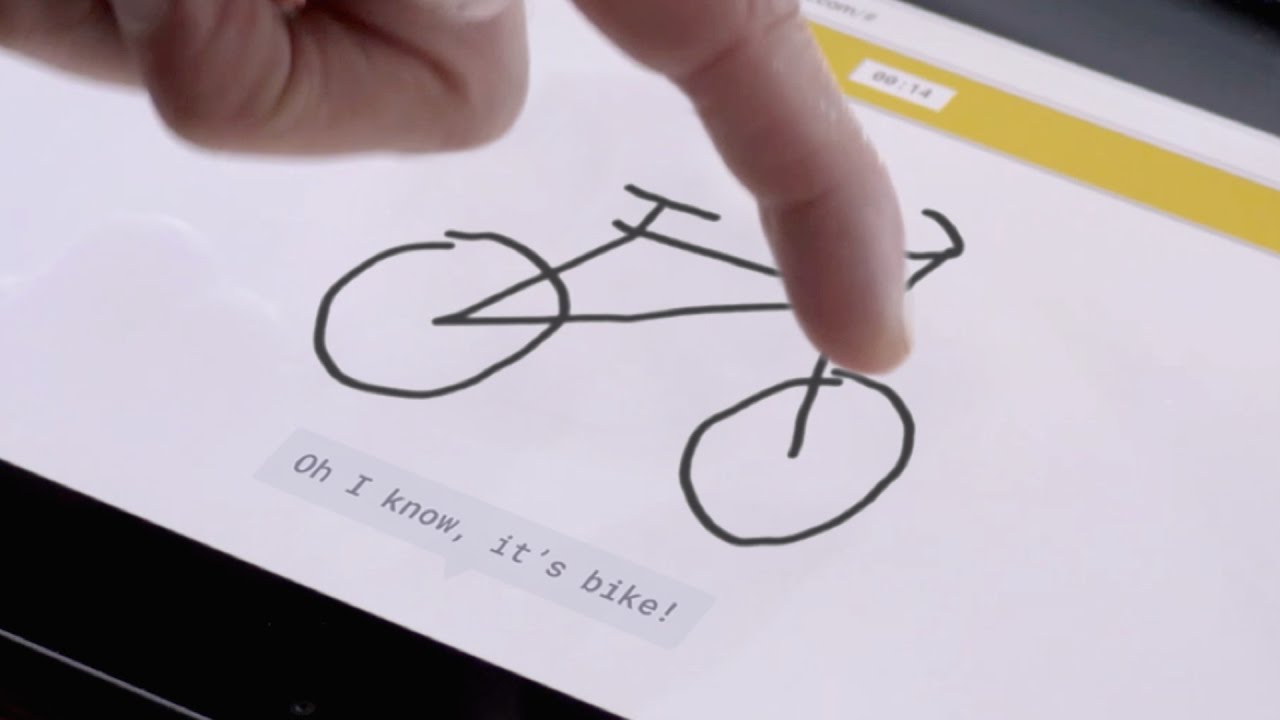

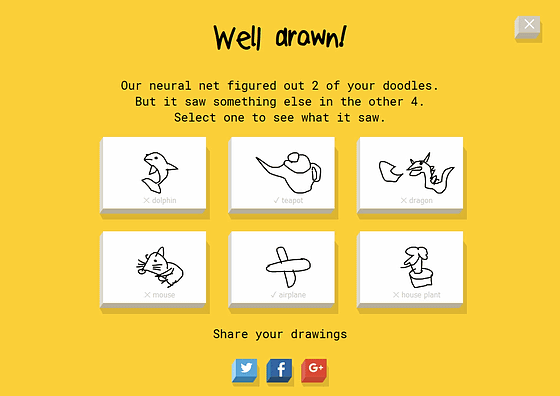

「Quick, Draw!」はニューラルネットワークを用いたお絵かきゲームで、プレイヤーは「Draw shoe in under 20 seconds(20秒以内にクマを描け)」などのお題に沿って絵を描いていきます。すると描いている途中の状態から推測して「四角が見える」「いやスーツケースかな?」「カヌーかも」などの音声が聞こえます。ユーザーが絵を描ききるまでに「Quick, Draw!」が正解を予測できれば「わかった、靴だ!」などと返答してくれますが、最後までわからないと「うう……、わからない……」などと言われてしまいます。

実際にQuick, Draw!が動作している様子は以下のムービーから見ることができます。

A.I. Experiments: Quick, Draw! - YouTube

なお、実際にプレイしたい場合は以下から挑戦可能。

Quick, Draw!

https://quickdraw.withgoogle.com/#

全部で6つのお題が出され、自分が描いた絵と成績はSNSにシェアすることができます。

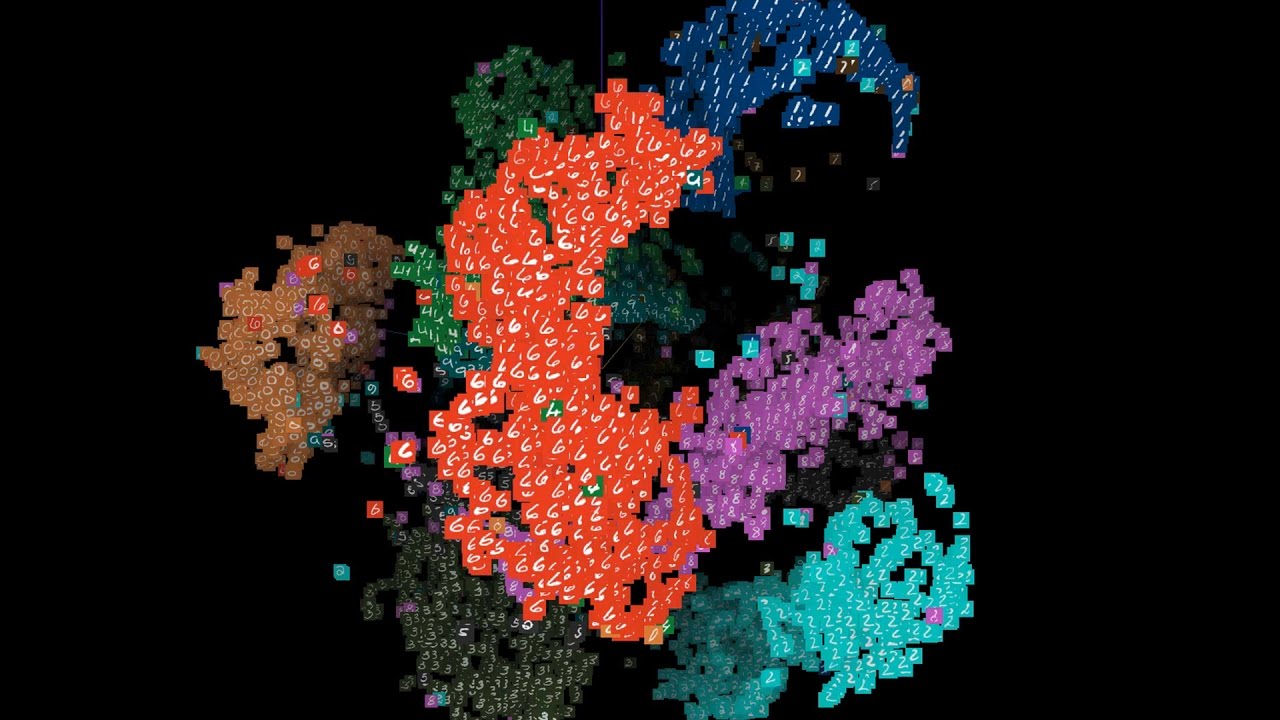

◆The Infinite Drum Machine

コンピュータに何のタグも与えずに何千もの音源データを毎日学習させ、データ可視化アルゴリズム「t-SNE」で整理したというドラムマシンが「The Infinite Drum Machine」。類似する音が色ごとに分類されており、丸い円の中にある音を手動で鳴らしたり、複数の円を配置して複合的なリズムを作ったりできるようになっています。

The Infinite Drum Machineがどのようなアプリになっているのかは、以下のムービーを見るとよくわかります。

A.I. Experiments: The Infinite Drum Machine - YouTube

プレイしてみたい人は以下のページで試すことができます。

The Infinite Drum Machine

https://aiexperiments.withgoogle.com/drum-machine/view/

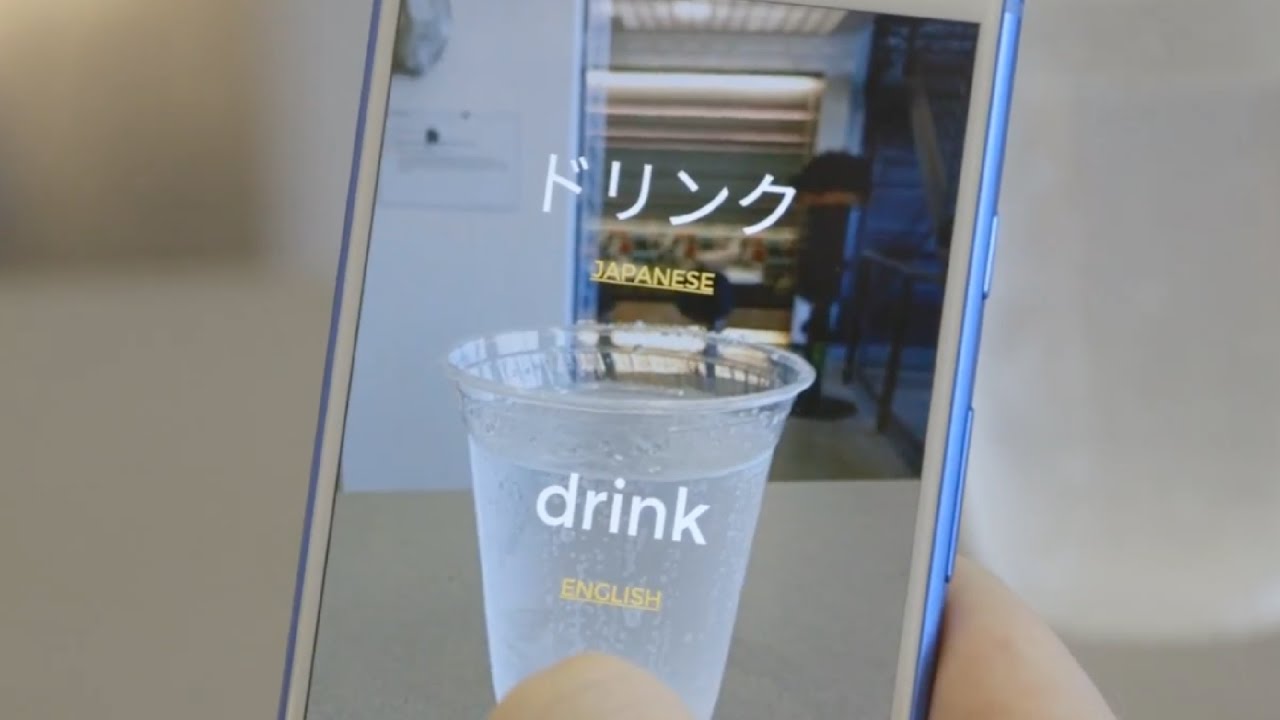

◆Thing Translator

Thing Translatorは「Cloud Vision API」と「Translate API」を組み合わせることで、スマートフォンのカメラで撮影した物体を認識してすぐさま多言語に翻訳できるというもの。Google翻訳にも「カメラで写したテキストを翻訳する」という機能がありますが、それをさらに進化させたようなデモンストレーションになっています。

実際にリアルタイムで物体翻訳が行われている様子は以下のムービーから確認できます。

A.I. Experiments: Thing Translator - YouTube

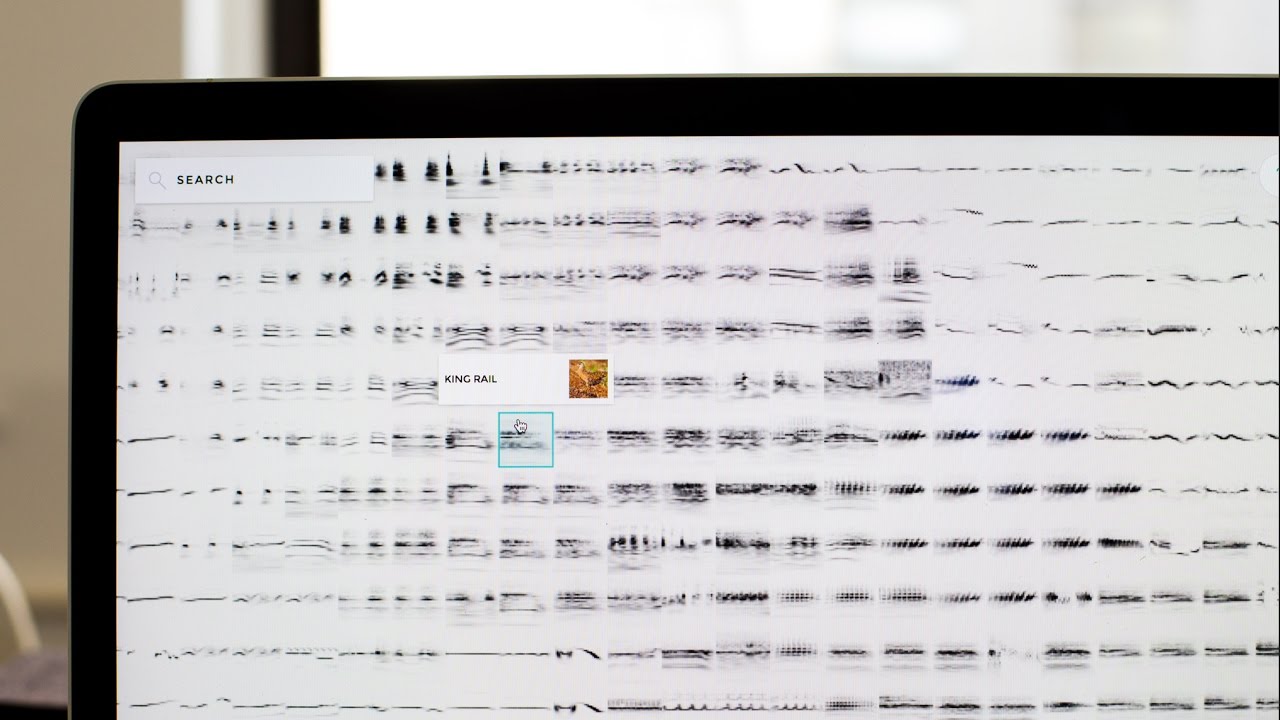

◆Bird Sounds

機械学習によって多岐にわたる鳥のさえずりを整理するという実験が「Bird Sounds」で、The Infinite Drum Machineと同様の手法で学習データが与えられ、t-SNEで類似の鳥類がまとまるように可視化されています。カーソルを合わせると鳥の名前が英語で表示され、クリックするとそのさえずりを再生可能。ボックスに鳥の名前を入れて検索してもOKです。ほかの動物の鳴き声も同様に分類・整理すれば、は虫類やほ乳類のデータベースを作るというような活用方法も考えられるとのこと。

どんな感じに鳥のさえずりが可視化されているかは、以下のムービーから試聴可能です。

A.I. Experiments: Bird Sounds - YouTube

以下のページにアクセスすれば、実際に体験可能。1万4482種類もの音声データを読み込むので、PCでの体験がオススメ。

Bird Sounds

https://aiexperiments.withgoogle.com/bird-sounds/view/

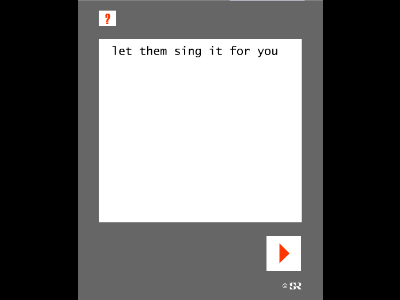

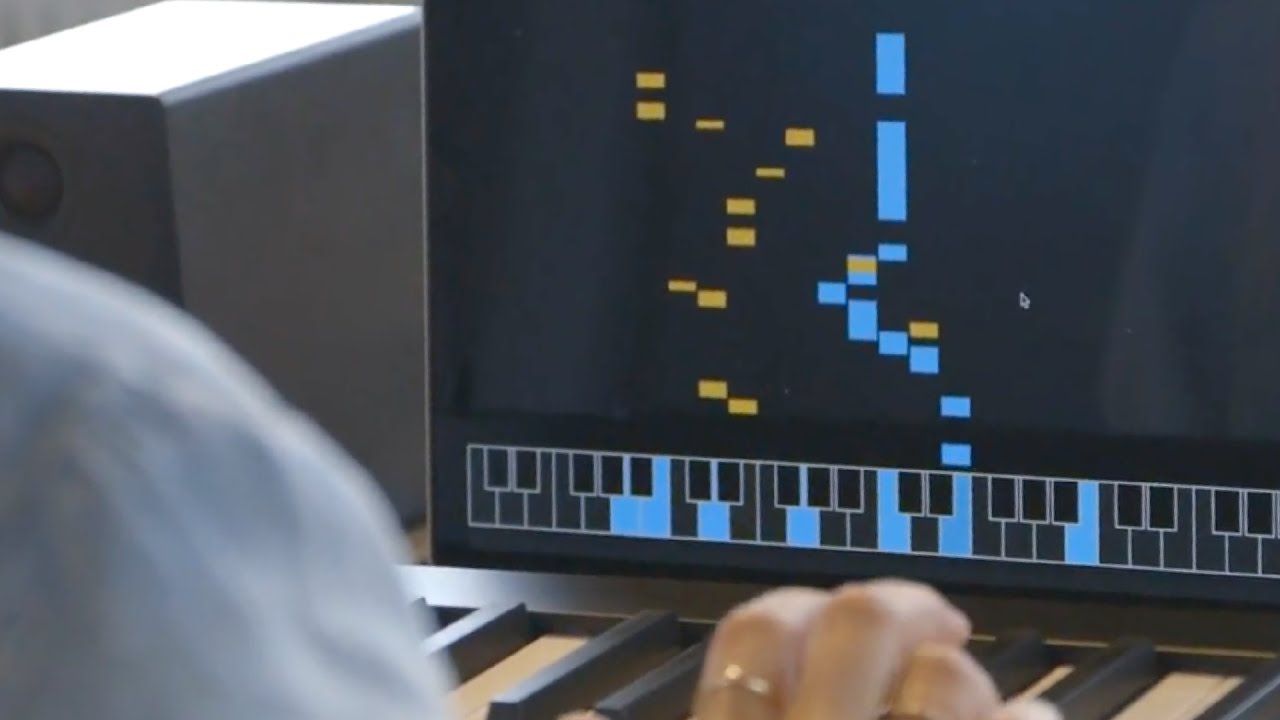

◆A.I. Duet

「A.I. Duet」はニューラルネットワークによって人工知能と一緒に音楽を作れるソフトウェア。まず人間がキーボードでメロディを演奏すると、ニューラルネットが「半音下げる」「半音上げる」などして少しアレンジを加えてオリジナルを模倣します。いわば連弾のようなことができ、自分の音楽に対してニューラルネットがどのように反応するかが楽しめるようになっています。

人間とニューラルネットがキーボードで連弾している様子は以下のムービーで見ることが可能。

A.I. Experiments: A.I. Duet - YouTube

◆Visualizing High-Dimensional Space

「Visualizing High-Dimensional Space」は機械学習で何が起こっているのかを視覚化するツールで、高次元のデータを見たり、検索したりできるようになります。最終的にTensorFlow内のオープンソースツールとしての公開を目指しており、エンジニア(コーダー)が可視化されたデータを検索できるようにするとのこと。

高次元データが視覚化されている様子は以下のムービーから見ることができます。

A.I. Experiments: Visualizing High-Dimensional Space - YouTube

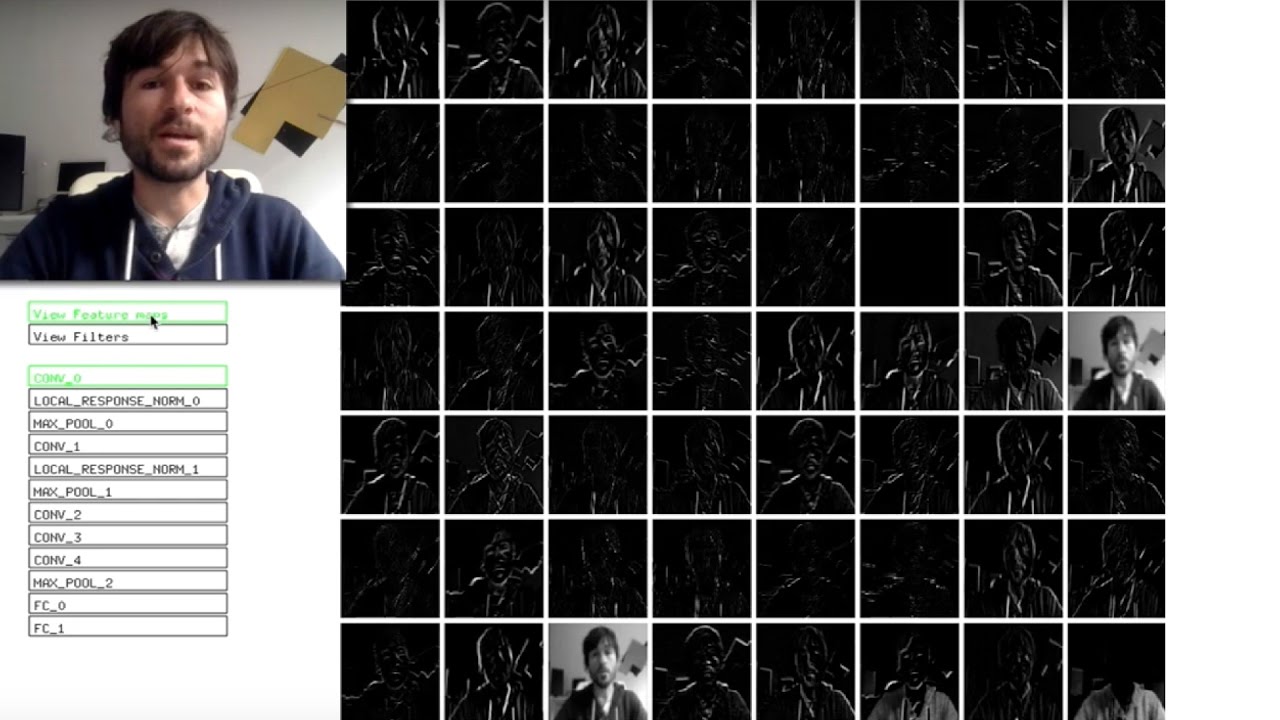

◆What Neural Networks See

カメラを通じてニューラルネットがどんなレイヤーで物体を認識しているかがわかるのが「What Neural Networks See」です。

各レイヤーがどんな風に機能するかを説明するムービーは以下から確認可能。

What convolutional neural networks see - YouTube

記事作成時点で公開されているデモは全部で8つですが、同ページでは今後も新しい人工知能や機械学習を使ったツールやアプリが公開されていく予定です。

・関連記事

Google「DeepMind」の人工知能は赤ん坊のように「触って覚える・判別する」能力を学習したとの発表 - GIGAZINE

Googleが低解像度画像を爆速で高画質化する機械学習を使った技術「RAISR」を発表 - GIGAZINE

Google純正の新スマホ「Google Pixel」が登場、会話型人工知能の「Googleアシスタント」を搭載 - GIGAZINE

Googleの人工知能専門チームDeepMindがたった数カ月で40%もGoogleデータセンターの冷却システムを効率化することに成功 - GIGAZINE

ガン治療にGoogleの人工知能「DeepMind」を使用する病院が登場 - GIGAZINE

Googleの人工知能チームがロボットの人類への反逆よりも心配していることとは? - GIGAZINE

・関連コンテンツ

in 動画, ソフトウェア, ウェブアプリ, Posted by darkhorse_log

You can read the machine translated English article A demo collection "AI Experiments" that ….