日本語のAIで使う大規模言語モデル性能を評価する「オープン日本語LLMリーダーボード」公開

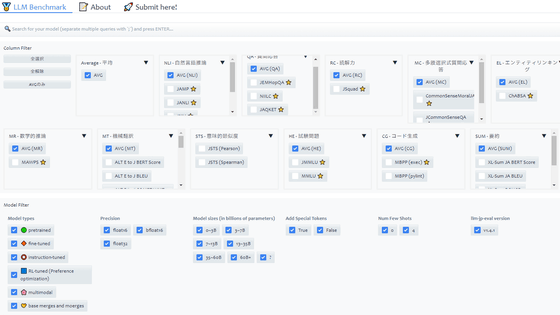

16種類以上のNLP(自然言語処理)タスクを用いて日本語の大規模言語モデル(LLM)の性能評価と分析を行う「オープン日本語LLMリーダーボード」が公開されました。構築には国立情報学研究所をはじめとする日本語LLMの研究開発を行う組織横断プロジェクト「LLM-jp」が携わっています。

Open Japanese LLM Leaderboard - a Hugging Face Space by llm-jp

https://huggingface.co/spaces/llm-jp/open-japanese-llm-leaderboard

Introducing the Open Leaderboard for Japanese LLMs!

https://huggingface.co/blog/leaderboard-japanese

Open Japanese LLM Leaderboard の公開 - LLM 勉強会

https://llm-jp.github.io/llm/2024/11/20/open-japanese-llm-leaderboard.html

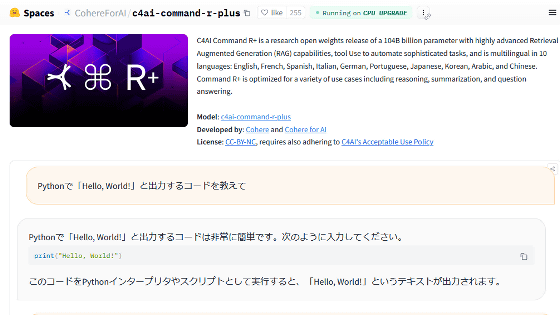

LLMは英語では広く機能していますが、その他の言語でうまく機能しているかどうかを知ることが困難でした。この「オープン日本語LLMリーダーボード」は、日本語のLLMの自動評価ツールである「llm-jp-eval」を活用して、LLMの性能評価を行うものです。

llm-jp-eval: 日本語大規模言語モデルの自動評価ツール

(PDFファイル)https://www.anlp.jp/proceedings/annual_meeting/2024/pdf_dir/A8-2.pdf

対応している評価データセットは以下の通り。

・自然言語推論(Natural Language Inference:NLI):Jamp、JaNLI、JNLI、JSeM、JSICK

・質問応答(Question Answering:QA):JEMHopQA、NIILC

・読解(Reading Comprehension:RC):JSQuAD

・選択式質問応答(Multiple Choice question answering:MC):JCommonsenseQA

・エンティティリンキング(Entity Linking:EL):chABSA

・基礎解析(Fundamental Analysis:FA):Wikipedia Annotated Corpus

・数学的推論(Mathematical Reasoning:MR):MAWPS

・意味的テキスト類似度(Semantic Textual Similarity:STS):JSTS

・機械翻訳(Machine Learning:MT):ALT、WikiCorpus

・試験問題(HE):MMLU、JMMLU

・コード生成(CG):MBPP

・要約(SUM):XL-Sum

日本語はひらがな、カタカナ、漢字、ローマ字という4種類の表記が混在する、とても複雑な表記体系を持ちます。さらに、単語と単語の間にスペースを入れないため、トークン化も難しいのだそうです。

それでも、日本の自然言語処理の特性を取り入れた日本語LLMが開発されていますが、問題は、LLMを比較するための一元化されたオープンシステムが存在しなかったことです。

そこで研究の透明化を高め、オープンソースのモデル開発の方針を奨励するために、Hugging Faceとllm-jpが協力して、オープン日本語リーダーボードを構築したとのこと。

この取り組みは、国内外の研究者の連携によって日本語LLMを評価し強化していくプラットフォームとなることが期待されています。

・関連記事

科学論文の調査に特化したAIモデル「OpenScholar」がベンチマークでGPT-4oを上回る、科学研究の大幅な効率化に期待 - GIGAZINE

AppleがChatGPTに対抗できるほど高性能な「LLM Siri」を2026年にリリースすることを考えている - GIGAZINE

中国のAI企業DeepSeekがOpenAI o1に匹敵する推論AIモデル「DeepSeek-R1-Lite-Preview」公開、オープンソース化する計画も - GIGAZINE

「ポケモンGO」のNianticが空間コンピューティング向けプラットフォーム「Niantic Spatial Platform」発表 - GIGAZINE

Mistral AIが124BサイズのマルチモーダルAIモデル「Pixtral Large」リリース、GPT-4oやGemini-1.5 Proなどを上回るパフォーマンス - GIGAZINE

・関連コンテンツ