AI生成キャラクターをリアルな表情でアニメーションさせられるツール「Act-One」をRunwayがリリース

AI開発企業のRunwayが、人物の動画を撮影するだけで手軽にAIが生成したキャラクターに被写体の表情を転送できるAIツール「Act-One」をリリースしました。Act-OneはRunwayの動画生成AIモデル「Gen-3 Alpha」を利用できるユーザーなら誰でも使用可能です。

Runway Research | Introducing Act-One

https://runwayml.com/research/introducing-act-one

Introducing Act-One | Runway - YouTube

Introducing, Act-One. A new way to generate expressive character performances inside Gen-3 Alpha using a single driving video and character image. No motion capture or rigging required.

— Runway (@runwayml) October 22, 2024

Learn more about Act-One below.

(1/7) pic.twitter.com/p1Q8lR8K7G

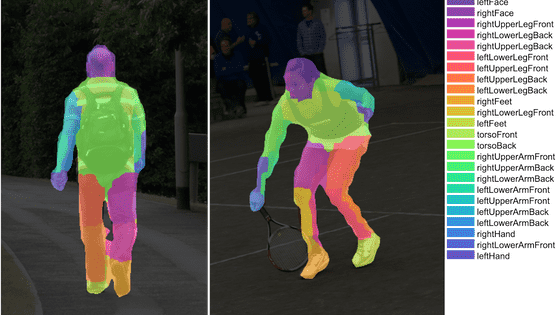

3Dモデルに表情を付ける「フェイシャルアニメーション」と呼ばれる作業には、これまでモーションキャプチャー機器やさまざまな角度からの撮影など、複雑なプロセスが必要でした。以下は「猿の惑星:創世記」での撮影の様子。俳優にはモーションキャプチャーのために数多くのセンサーを付けて演技することが求められます。

Turning Human Motion-Capture into Realistic Apes in Dawn of the Planet of the Apes | WIRED - YouTube

しかし、近年さまざまなAI企業が手軽なフェイシャルアニメーションを実現するようなAIツールを開発しており、RunwayのAct-Oneもその一つです。

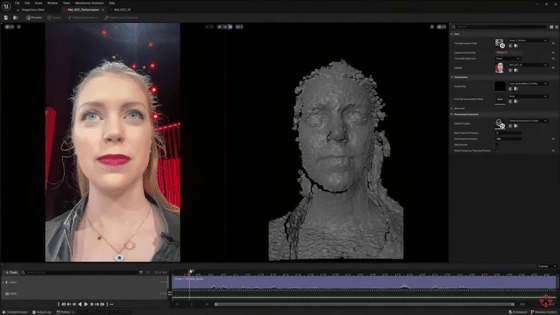

Act-Oneは顔の表情のモデリングに重点を置いたAIツールで、スマートフォンのカメラなどを用いて映像を撮影するだけで、被写体の顔の表情をAIが生成したキャラクターの表情に転送することが可能です。

Act-One allows you to faithfully capture the essence of an actor's performance and transpose it to your generation. Where traditional pipelines for facial animation involve complex, multi-step workflows, Act-One works with a single driving video that can be shot on something as… pic.twitter.com/Wq8Y8Cc1CA

— Runway (@runwayml) October 22, 2024

RunwayはAct-Oneについて「Act-Oneはモーションキャプチャーやキャラクターリギングを必要とせず、単一のビデオ入力から、無数の異なるキャラクターデザインやさまざまなスタイルに変換できます」と述べています。

Without the need for motion-capture or character rigging, Act-One is able to translate the performance from a single input video across countless different character designs and in many different styles.

— Runway (@runwayml) October 22, 2024

(3/7) pic.twitter.com/n5YBzHHbqc

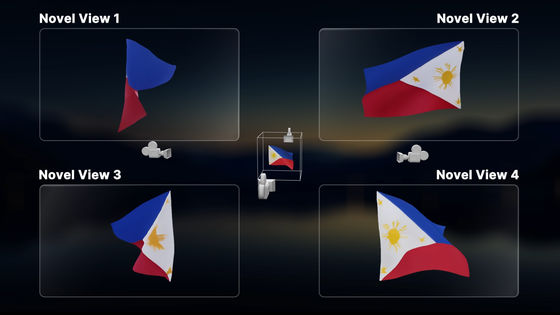

Act-Oneの強みの1つは、さまざまなカメラアングルと焦点距離からシネマティックな品質のリアルな出力が可能という点で、高価な機材や複雑なワークフローがなければ実現が困難だったキャラクターの複雑なパフォーマンスを小規模なクリエイターでも実現することができます。Runwayによると、スマートフォンのカメラと台本を読む1人の俳優がいるだけで、感情に訴えかけるコンテンツを作成できるとのこと。

One of the models strengths is producing cinematic and realistic outputs across a robust number of camera angles and focal lengths. Allowing you generate emotional performances with previously impossible character depth opening new avenues for creative expression.

— Runway (@runwayml) October 22, 2024

(4/7) pic.twitter.com/JG1Fvj8OUm

Runwayのクリストバル・バレンズエラCEOは「生成モデルが一貫性のあるビデオを生成できるかどうかが問題となる段階はもう終わりを告げました。現在では優れたモデルが新しいベースラインになりました。これらの違いはアプリケーションやユースケースについてどのように考えるか、そして最終的に何を構築するかにあります」と述べています。

We are now beyond the threshold of asking ourselves if generative models can generate consistent videos. A good model is now the new baseline. Generating pixels with prompts has become a commodity. The difference lies (as it has always been) in what you do with a model - how you… https://t.co/s0wVvPga7j

— Cristóbal Valenzuela (@c_valenzuelab) October 22, 2024

リアルな表情の出力を実現できるAct-Oneには包括的な一連の安全対策が導入されており、公人や著名人のコンテンツを無断で生成しようとする試みを自動的に検出してブロックするための保護手段や、ユーザーが使用する音声は正当なものであるかを確認する技術ツールが含まれています。また、ツールを責任を持って使用しているか、誤用がないかといった継続的な監視も行われるそうです。

なお、Act-Oneは2024年10月22日以降、Runwayの動画生成AIモデル「Gen-3 Alpha」のユーザー向けに段階的に展開されるとのこと。

Runwayが動画生成AIモデル「Gen-3 Alpha」をリリース、数日以内に誰でも5~10秒の動画生成が利用可能に - GIGAZINE

Runwayは2024年9月に、映画・テレビ番組製作会社のライオンズゲートと映画制作におけるAIの使用に関する提携を結んだことを発表していました。ライオンズゲート副会長のマイケル・バーンズ氏はリリースの中で「Runwayは、先見の明があり、クラス最高のパートナーであり、AIを活用して最先端の資本効率の高いコンテンツ作成の機会を開発するのを支援してくれます。私たちはAIを現在の業務を強化、補完するための優れたツールとみなしています」と述べています。

・関連記事

Runwayが動画生成AIの「Gen-3 Alpha Turbo」をリリース、Gen-3 Alphaよりも高速かつ安価&5秒と10秒の動画生成&無料トライアル含むすべてのプランで利用可能 - GIGAZINE

テキストから動画を生成できるAI「Runway Gen 2」登場、ジェネレーティブAIの主戦場はついに映像へ - GIGAZINE

Runwayの動画生成AIは写真系YouTuberの動画をスクレイピングしてトレーニングされたものと指摘される - GIGAZINE

Microsoftが顔写真と音声ファイルからリアルに話す映像を作成できるAIモデル「VASA-1」公開 - GIGAZINE

・関連コンテンツ

in ソフトウェア, 動画, Posted by log1r_ut

You can read the machine translated English article Runway releases 'Act-One,' a tool that c….