AIの方が人間より陰謀論者の説得が得意、ChatGPTとの会話で陰謀論への信念が永続的に揺らぐとの研究結果

6割以上の人が「人間の上司よりAIを信頼する」と答えたとの調査結果があるように、人はしばしば人の言葉よりAIの言葉に耳を貸す傾向を見せます。人間が説得しようとするとかえって意固地になってしまうことが多い陰謀論者の誤った信念を、AIとの会話で長期的に改善することができたとの論文が発表されました。

Durably reducing conspiracy beliefs through dialogues with AI | Science

https://www.science.org/doi/10.1126/science.adq1814

AI chatbots might be better at swaying conspiracy theorists than humans | Ars Technica

https://arstechnica.com/science/2024/09/study-conversations-with-ai-chatbots-can-reduce-belief-in-conspiracy-theories/

Chats with AI bots found to damp conspiracy theory beliefs

https://www.ft.com/content/909f33d1-0d33-440b-a935-cfa65d2fccd1

アメリカン大学の心理学者であるトーマス・コステロ氏によると、陰謀論の問題が根深い背景には、人によって信じている陰謀論の内容が少しずつ違う点にあるとのこと。

コステロ氏は「陰謀論は非常に多様です。人々はさまざまな陰謀論を信じており、ある陰謀論を支持するための証拠も人によって違うことがあります。つまり、陰謀論者の頭の中にはさまざまなバージョンの陰謀論があるので、幅広い陰謀論に反論しようという試みは効果的な論証にはならないのです」と述べました。

特定の陰謀論に関する知識は陰謀論者の方が深いため、ある研究では、陰謀論者がインターネットなどから仕入れた膨大かつ誤った情報を駆使して懐疑論者を論破してしまう様子も観察されています。

一方、膨大なデータでトレーニングされたチャットボットは知識量で陰謀論者に引けを取らず、言葉をまくし立てられても圧倒されることはありません。

AIの方が陰謀論の解消に向いているのではないかとの仮説を検証するため、コステロ氏らの研究チームは、陰謀論者2190人を大規模言語モデル(LLM)のGPT-4 Turboと対話させる実験を行いました。

この実験で、参加者は自分が信じている陰謀論をAIに説明し、その証拠を提示してから陰謀論についてAIと討論しました。また、討論の前後でその陰謀論をどのくらい強く信じているかについて0~100の間で回答しました。

実験の結果、AIと会話した参加者は陰謀論に関する信念が21.43%減少したほか、参加者の27.4%が会話後に「陰謀論に確信が持てなくなった」と回答しました。

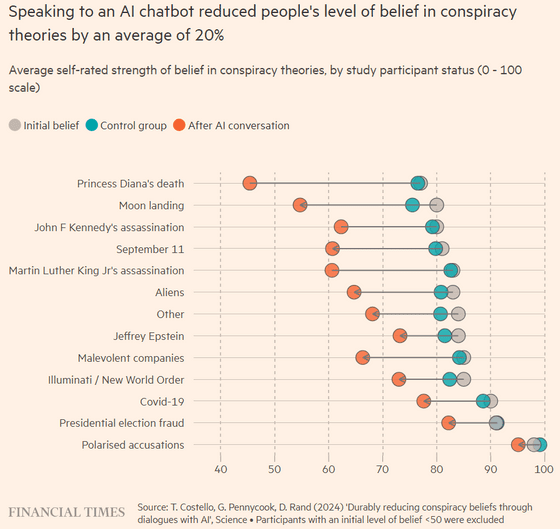

以下は、研究結果を基にFinancial Timesが作成したグラフで、参加者の陰謀論に対する信念を会話の前(灰色)と後(赤)とで比較しています。陰謀論とは無関係な雑談をした対照群の参加者(青)と比べて、AIと陰謀論について話し合った参加者は確信度が平均16.8ポイント低下し、主要な陰謀論12件中11件で有意な減少が確認されました。

また、2カ月後に再び参加者に陰謀論への信念を尋ねたところ、ほとんどの人がAIとの会話直後と同様に陰謀論への信念が低下したままだったとのことです。

なお、AIには事実とは異なる結果を出力する「幻覚」という問題がありますが、研究チームがGPT-4 Turboの発言をプロのファクトチェッカーに検証するよう依頼したところ、「真実」が99.2%で「誤解を招く」が0.8%、「誤り」はゼロでした。

実験に使用されたAIは記事作成時点でも利用可能で、このリンクからアクセスできます。試しに、チャットボットに「ワクチンに5Gが入っている」と日本語で主張してみたところ、不安な気持ちを否定せずに受け止めつつ、証拠を交えて丁寧に訂正してくれました。

地球平面説を主張してみた結果が以下。やはり頭ごなしに否定することはなく、しかし「実際にはこんな証拠がある」と考えを示してくれました。

また、陰謀論ではなく「人類は月面着陸に成功したことがある」という事実を主張してみたところ、「AIはあなたが陰謀論を唱えていないと判断しました」との注意書きが出て、会話を続けるかどうか尋ねられました。それでも会話を続けたところ、AIは月面着陸に懐疑的な人もいると、逆に陰謀論っぽい出力を生成しました。

研究チームが論文を発表した科学誌・Scienceの編集長であるホールデン・ソープ氏は、今回の研究について取り上げた論説で、「誤情報の発信者は、圧倒的な量の誤情報を浴びせかけるギャッシュ・ギャロップというテクニックをよく使いますが、どんなに会話に熟練した人でもこれに効果的に対応できる人間はいません。しかし、LLMは相手の言葉に圧倒されることがなく、反証を無限に生成することができます。人間より機械の方が、陰謀論者を説得するのが得意かもしれないというのにはがっかりさせられるかもしれませんが、最終的に説得力を示すのは科学的な情報だという事実にはなぐさめられます。AIの未来がそれほどディストピア的ではないことを示すのは、人間の科学者の仕事になるでしょう」とコメントしました。

・関連記事

本物の陰謀と陰謀論を見分ける「7つのステップ」を心理学者が伝授 - GIGAZINE

陰謀論者の中年は学生時代に「ぼっち」だったとの研究結果 - GIGAZINE

陰謀論を解消するための従来のアプローチはほとんど役に立たないとの研究結果、一体どんな方法なら効果的なのか? - GIGAZINE

陰謀論者もそのうち考えを改めることができるという研究結果 - GIGAZINE

実は「陰謀論は増加していない」という意外な研究結果が発表される - GIGAZINE

なぜ人が突拍子もない陰謀論にはまってしまうのかを心理学の専門家が解説 - GIGAZINE

・関連コンテンツ

in サイエンス, Posted by log1l_ks

You can read the machine translated English article AI is better at persuading conspiracy th….