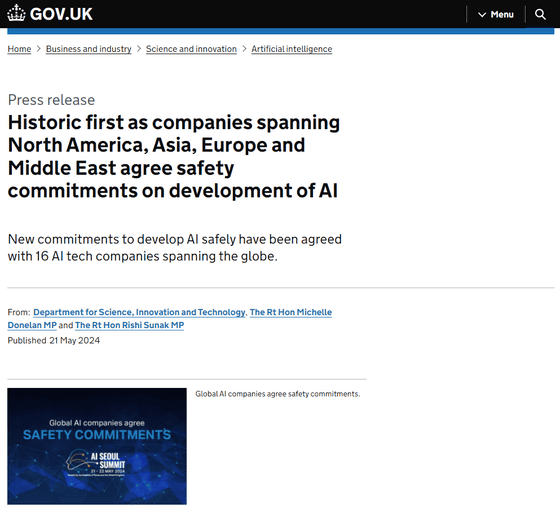

「安全なAIを開発する」ことでOpenAIやGoogleなど16社が合意

OpenAIやGoogle、Amazon、Meta、Microsoftなど16社が、第2回となるAIサミットで、AIの安全性に関する一定の合意に至ったことを発表しました。

Historic first as companies spanning North America, Asia, Europe and Middle East agree safety commitments on development of AI - GOV.UK

https://www.gov.uk/government/news/historic-first-as-companies-spanning-north-america-asia-europe-and-middle-east-agree-safety-commitments-on-development-of-ai

Frontier AI Safety Commitments, AI Seoul Summit 2024 - GOV.UK

https://www.gov.uk/government/publications/frontier-ai-safety-commitments-ai-seoul-summit-2024/frontier-ai-safety-commitments-ai-seoul-summit-2024

AIサミット、世界16企業が安全な開発を約束 英韓共催で開幕 | ロイター

https://jp.reuters.com/business/technology/XIL6EB7W3FJZXBEKPIOTRY3BT4-2024-05-22/

AIサミットは世界の主要なAI開発企業が参加するサミットで、第1回は2023年11月にイギリス・ブレッチリーで開催。第2回はイギリスと韓国の共催で、2024年5月21日・22日に韓国の首都ソウルで開催されました。

サミットでは「安全なAIを開発すること」、つまりリスクを十分に軽減できないと考えられる場合にはAIモデルを開発・展開しないことや、最先端AIのことを指す「フロンティアAI」の安全性について説明可能なガバナンスと透明性の確保について、合意が行われました。

合意したのは以下の16社です。

・Amazon

・Anthropic

・Cohere

・Google/Google DeepMind

・G42

・IBM

・Inflection AI

・Meta

・Microsoft

・Mistral AI

・Naver

・OpenAI

・Samsung Electronics

・Technology Innovation Institute

・xAI

・Zhipu.ai

「十分なリスク軽減ができない場合」で示されるリスクの閾値の定義は、政府を含む関係者からの意見を取り入れた上で、2025年初頭にフランスで開催される「AIアクションサミット」で発表が予定されています。

今回の合意について、イギリスのリシ・スナク首相のコメントは以下の通りです。

「世界のさまざまな地域の、これほど多くの主要AI企業が、AIの安全性に関する取り組みに合意したのは世界で初めてのことです。これらの取り組みは、世界の主要なAI企業が安全なAIを開発する計画について、透明性と説明責任を提供することを保証するものです。これはAIの安全性に関するグローバルスタンダードの先例となるものであり、革新的な技術の恩恵を解き放つものです」

また、科学・イノベーション・技術大臣のミシェル・ドネラン氏によるコメントは以下の通りです。

「AIの真の可能性は、我々がリスクを把握することで初めて解き放たれるものです。AIが安全に開発されるようにするのは我々全員の責任であり、今回の合意は、AI企業による取り組みを強化し、世界がよりよくなったことを意味します。イギリスはAIの安全性に関しては世界のリーダーであり、私は(第1回サミットでフロンティアAIの安全かつ責任ある開発に合意した)ブレッチリー宣言の効果を活用して、AIの安全性を世界的な課題に位置づけ、他国を刺激し続けています。より強力なモデルが現れて、世界でより多くの安全性テストが行われる中、我々はAIのリスクを管理し、経済成長のための革新の可能性をつかめるようにします」

・関連記事

EUの人工知能(AI)法が加盟国に承認されて成立、「安全で信頼できるAIシステムの開発と導入の促進」を目指す - GIGAZINE

Metaがインドの選挙期間中に偽情報や暴力を扇動するAIが生成した画像を含むFacebook広告を承認していたことが判明 - GIGAZINE

「人類に壊滅的なリスクをもたらすAI」を安全に提供するためにAnthropicが既存ポリシーの反省点を公開 - GIGAZINE

OpenAIで超知性の制御と安全性を研究していた「スーパーアライメント」チームが解散、元幹部は「派手な製品が安全性より優先されている」 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by logc_nt

You can read the machine translated English article 16 companies including OpenAI and Google….