GPT-4 TurboがベンチマークでGPT-4を下回ってしまう、ただしベンチマークの内容に問題がある可能性あり

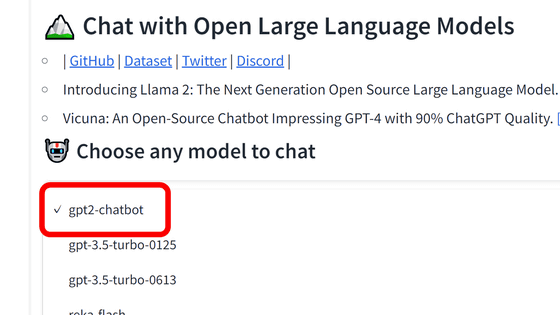

ChatGPTなどのAIを展開するOpenAIが、2023年11月6日に開催した開発者向けイベント「DevDay」で発表した「GPT-4 Turbo」について、GPT-4を使用したコーディング支援ツールを開発しているMentatがベンチマークを行ったところ、GPT-4よりも性能が低いという結果が出ました。

Benchmarking GPT-4 Turbo - A Cautionary Tale | Mentat

https://blog.mentat.ai/benchmarking-gpt-4-turbo-a-cautionary-tale

GPT-4 Turboについての詳細は下記記事にて解説している通り。OpenAIはGPT-4 Turboについて、「GPT-4よりも性能が向上した」と述べていました。

OpenAIがGPT-4のアップグレード版大規模言語モデル「GPT-4 Turbo」を発表、2023年4月までの知識を持ちコンテキストウィンドウは128Kで価格は控えめ - GIGAZINE

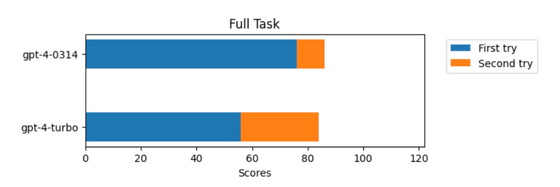

Mentatはプログラミング学習サイトのExercismから122問の演習問題を取得し、Aiderを通して同じプロンプトで演習問題を解かせることでGPT-4とGPT-4 Turboの性能を比較しました。それぞれの問題について1回目のプロンプトで適切な回答が帰ってこなかった場合、エラーメッセージとともに「コードを修正してください」と2回目のプロンプトを送信して正答率を計測したとのこと。

GPT-4は122問のうち86問で正解し、正答率70%を上回りました。一方GPT-4 Turboは122問中84問で正解し、正答率は68.8%にとどまりました。この結果だけであれば同等の性能があると言えそうですが、Mentatは正解の内訳が違うと述べています。GPT-4は1回目のプロンプトで正解できた問題数が76問で、2回目のプロンプトで10問正解しましたが、GPT-4 Turboは1回目のプロンプトで56問しか解決できず、28問は2回目のプロンプトでの正解だったとのこと。

こうした現象が発生した理由について、MentatはGPT-4のトレーニングデータに演習問題の内容が含まれており、その記憶がGPT-4 Turboに縮小された時に失われてしまったからではないかと推測しています。

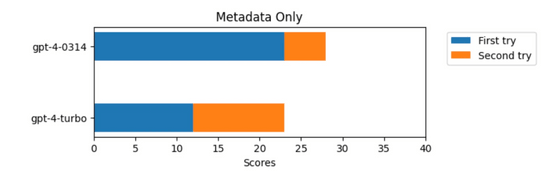

実際、演習問題の指示を削除し、問題のタイトルと関数のプレースホルダーだけを提示した場合でもGPT-4は1回目のプロンプトで57.5%の問題に正解し、2回目での正解分も合わせると正答率は70%に達しました。一方GPT-4 Turboは1回目の正答率は30%で、2回目と合わせても57.5%になり、GPT-4よりも記憶している問題数が少ないことが示されています。

MentatはX(旧Twitter)に投稿されているGPT-4とGPT-4 TurboでSAT(大学進学適性試験)を解かせてみたという下記のポストについても言及し、GPT-4のスコアが高くなるのはトレーニング時に試験問題を記憶したからではないかと述べています。

OpenAI claims GPT4-turbo is “better” than GPT4, but I ran my own tests and don’t think that's true.

— Jeffrey Wang (@wangzjeff) 2023年11月7日

I benchmarked on SAT reading, which is a nice human reference for reasoning ability. Took 3 sections (67 questions) from an official 2008-2009 test (2400 scale) and got the… pic.twitter.com/LzIYS3R9ny

トレーニング時に使用したデータでベンチマークを行うことはAIが正しい形式で適切に応答できるかを確認したり、ファインチューニングされたモデルを相互に比較したりすることにおいては価値があるものの、別のデータセットでトレーニングされたモデルや縮小されたモデルの比較においては適切に評価が行えるとは言えません。MentatはGPT-4 Turboの評価にはより優れたベンチマークが必要だと述べており、すでにトレーニング終了後に行われたオープンソースリポジトリへのコミットを元にしたテストを構築中とのことです。

・関連記事

大規模言語モデル「Phind」がコーディングにおいてGPT-4を上回る - GIGAZINE

GPT-4よりも高い性能を発揮できる特定言語特化型の言語モデル「InternLM」 - GIGAZINE

GPT-4とClaude 2は「16世紀に書かれたラテン語の魔術書」まで翻訳することが可能、学者が「人間のプロに匹敵する」と太鼓判 - GIGAZINE

OpenAIがコーディング不要でChatGPTをカスタムできる「GPTs」発表&自分のGPTsを公開できる「GPT Store」も展開予定 - GIGAZINE

「自動ムービー編集」「ゲーム開発」「文章校正」「論文要約」などGPT-4がわずか3週間で生み出した14の画期的ツール - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1d_ts

You can read the machine translated English article GPT-4 Turbo is lower than GPT-4 in the b….