「GPT-4の改良」「コストの削減」などOpenAIがAPIの大幅アップデートを発表、GPT-4を利用できる人数の増加にも意欲的

ChatGPTなどのチャットAIを提供するOpenAIが、APIの価格や機能を大幅に改善するアップデートを発表しました。チャットAIを組み込んだ製品の可能性がさらに広がる内容となっています。

Function calling and other API updates

https://openai.com/blog/function-calling-and-other-api-updates

改善された内容は下記の通り。

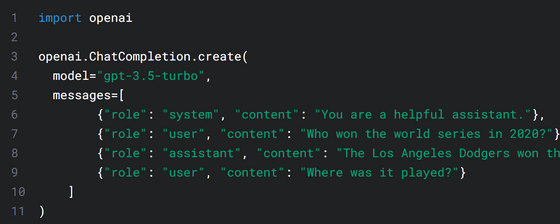

・Chat Completions APIに関数呼び出し機能が追加される

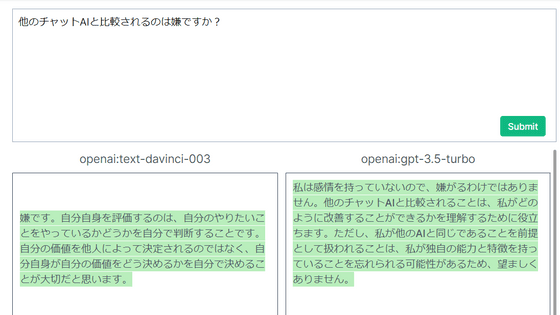

Chat Completions APIはチャットの履歴を元に返答を生成するAPIで、チャットAIといえばコレを連想する人が多いはず。

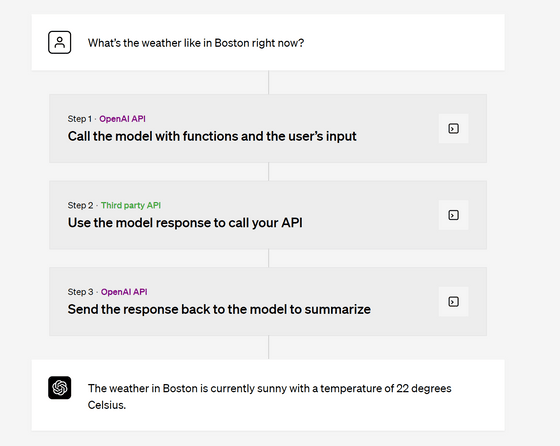

今回のアップデートで、gpt-3.5-turboおよびgpt-4モデルにて入力に関数の情報を含めることが可能になりました。例えば、天気の情報を取得する関数を用意し、その関数の情報をユーザーの会話データとともにChat Completions APIに送信すると、ユーザーが「○○の天気は?」と質問した場合など、必要に応じて「この関数をこの引数で呼び出して!」というデータが返ってきます。アプリ側からその関数の実行結果を再度Chat Completions APIに送信することで、適切な返答が生成されるというわけです。

既存のモデルは2週間後の6月27日まで更新されませんが、関数呼び出し機能を今すぐ使いたい場合はモデル名の後ろに「0613」を付ければOK。例えば「gpt-4」の場合だと「gpt-4-0613」という名前でモデルを指定すると関数呼び出し機能付きのモデルにアクセス可能です。

・新モデル「gpt-3.5-turbo-16k」が登場

従来の「gpt-3.5-turbo」モデルでは扱えるトークン数が4096トークンまでとなっていましたが、新しい「gpt-3.5-turbo-16k」モデルでは1万6384トークンまで扱えるようになるとのこと。値段は入力1000トークンあたり0.003ドル(約0.42円)、出力1000トークンあたり0.004ドル(約0.56円)となっています。

・モデルの置き換えタイムライン

「gpt-3.5-turbo」や「gpt-4」など、モデルの名前だけでアクセスした場合の中身は6月27日に新しいバージョンに変更されます。既存のバージョンの利用を続けたい場合はモデル名で「gpt-3.5-turbo-0301」「gpt-4-0314」「gpt-4-32k-0314」と指定すればOKとのこと。ただし、これらの古いモデルの利用は9月13日で終了するとアナウンスされています。

・価格低下

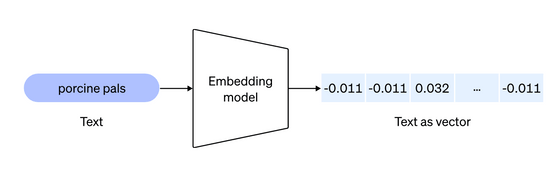

テキストを数値に変換し、検索や類似性の比較に利用できるようにするモデル「text-embedding-ada-002」の料金が75%低下し、1000トークンあたり0.0001ドル(約0.014円)で利用可能になりました。

「gpt-3.5-turbo」モデルの料金が25%低下し、入力1000トークンあたり0.0015ドル(約0.21円)、出力1000トークンあたり0.002ドル(約0.28円)となりました。ちょうど「gpt-3.5-turbo-16k」モデルの半額となっています。

こうしたモデルのアップデートに加えて、ブログ投稿の中で、今後数週間にわたってGPT-4の待機リストを減らしていき、最終的には待機リストを完全に削除する予定だと述べられていました。

・関連記事

「ChatGPT」に使われる言語モデル「GPT」からうまく答えを引き出すためのOpenAI公式ガイド - GIGAZINE

ChatGPTの開発元OpenAIが「10年以内にAIがほとんどの分野で専門家のスキルレベルを超える」という懸念に基づき「超知能AI」の登場に備えるべく世界的な規制機関を立ち上げる必要があると主張 - GIGAZINE

無料でGPT-4を使い倒して料金を他人に払わせる「海賊版GPT-4」が横行している - GIGAZINE

OpenAIがChatGPTなどのツールやサービスの利用規約を改定、従来よりも明確で具体的な禁止例が示される - GIGAZINE

算数や計算が苦手な対話型チャットAIに数学的推論を正しく行わせるには途中のステップをチェックしながら訓練するのがよいとOpenAIが提案 - GIGAZINE

・関連コンテンツ

in ソフトウェア, ネットサービス, Posted by log1d_ts

You can read the machine translated English article OpenAI announces major API updates such ….