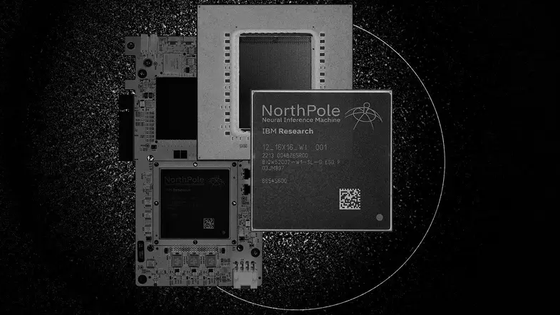

AIをさらに効率的に動かせる新型チップ「NeuRRAM」発表、より小型のデバイスで大規模なAIアルゴリズムの実行と精度アップが可能に

人工知能のアルゴリズムは近年急速な発達を遂げていますが、技術的な問題や環境への懸念もあり、現在のペースで成長し続けることは困難とされています。そこで、元スタンフォード大学所属で現在はAIスタートアップ企業ウェイアー・ワン氏らが2022年8月に「NeuRRAM」とよばれる新たなチップを発表しました。この小さなチップでより複雑なアルゴリズムが実行できるようになる可能性があるとされています。

A compute-in-memory chip based on resistive random-access memory | Nature

https://doi.org/10.1038/s41586-022-04992-8

A Brain-Inspired Chip Can Run AI With Far Less Energy | Quanta Magazine

https://www.quantamagazine.org/a-brain-inspired-chip-can-run-ai-with-far-less-energy-20221110/

今回開発されたチップは神経系の処理に着想を得た「ニューロモルフィック・コンピューティング」と呼ばれる、エネルギー効率の高いものです。従来のチップでは大規模なディープラーニングを行うために必要な計算能力が不足していましたが、NeuRRAMではその問題が解決されています。

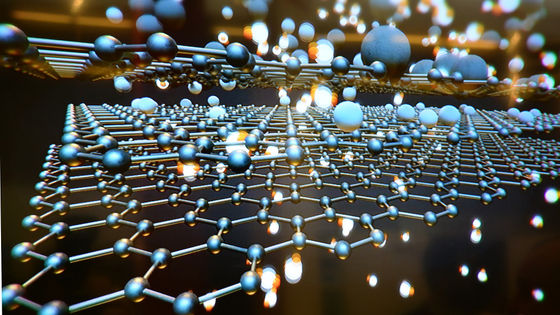

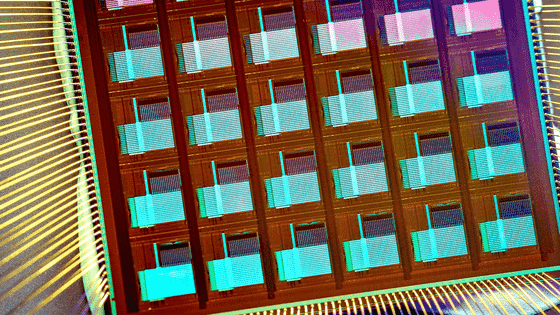

従来のチップは2進数で情報を処理していますが、「抵抗変化型メモリ(RRAM)」とよばれる新しいメモリを使用したNeuRRAMでは独立した範囲内に複数の値を保持するアナログ方式で動作させることでより多くの情報を保存できるとのこと。その結果従来のチップよりも最大1000倍のエネルギー効率が得られるとワン氏らは主張しています。さらに、チップの小型化によってスマートウォッチやスマートフォンなどの以前はAIの使用に適していなかった小型デバイスでも複雑なアルゴリズムが実行できるようになるとのこと。

従来のコンピューターにおいて、コンピューターのメモリは、実際に計算が行われる「プロセッサ」から離れた「マザーボード」上に配置されますが、情報の伝達において非効率的です。そこでメモリとプロセッサを同じ場所に配置する一体型のチップが考案されましたが、技術的に困難であるとされていました。それでも数十年前にメモリが保存されている場所で計算を実行する新たなチップを作成する材料が開発されましたが、従来のコンピューターのパフォーマンスには劣り、何十年も見落とされていたそうです。

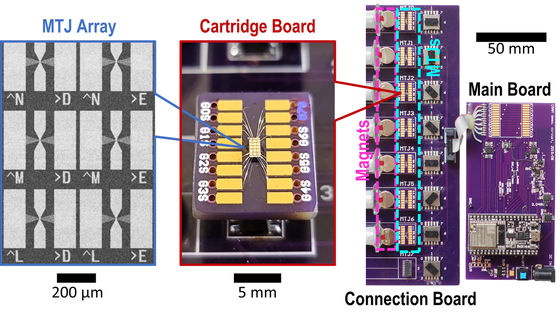

2015年ごろからコンピューターの研究者はRRAMを用いたデバイスが大規模なAIの実行に利用できる可能性を認識し、開発が進められました。また、2015年にカリフォルニア大学サンタバーバラ校の科学者チームがRRAMを搭載したデバイスがメモリを保存する以外の用途があることを報告しました。この発表は単純な行列の乗算などの基本的な計算タスクがメモリでも実行可能であるという点で画期的でした。

NeuRRAMはアナログ処理を行うため、デジタル処理と異なりチップが多数の行列計算を並行して実行することができるとされ、その結果デジタルRRAMメモリよりも高いエネルギー効率が実現できました。

しかし、NeuRRAMが行うアナログ処理には2つの問題があり、1つはアナログRRAMチップが正確でなければならないという問題です。アナログRRAMの都合上、変動とノイズが生じる可能性があり、AIアルゴリズムを実行することが困難になるとされています。一方でワン氏らはAIアルゴリズムがノイズに慣れるように調整されていれば従来のコンピューターと同様の正確さを生み出すことができると発表しています。

もう1つの問題は、アナログRRAMの柔軟性の低さです。アナログRRAMで大規模なAIの実行を行うためには多くの配線と回路が必要になり、エネルギーとスペースが必要でした。そこで、ワン氏らは新たなチップを設計することで省スペース化と省エネルギー化を達成しています。

なお、ワン氏らは指の爪程度のサイズのNeuRRAMチップを複数枚積み重ねて規模を拡大するとともに、さらなる省エネルギー化やエネルギーの高効率化を目指しています。

・関連記事

AI(人工知能)に対するありがちな「誤解」とそれに対する回答まとめ - GIGAZINE

6億種超のタンパク質構造を予測したAI「ESM-2」によるデータベースをMetaが公開、予測速度はAlphaFoldより60倍高速 - GIGAZINE

Metaが言語・画像・音声など複数分野に適応できる自己学習型AI「data2vec」を発表 - GIGAZINE

AI技術の最先端を行くNVIDIAはAIの未来をどのように予測しているのか? - GIGAZINE

・関連コンテンツ