手術のムービーを見て学習し実際に縫合手術をマスターしたAI「Motion2Vec」が登場

医療ロボットの開発は近年目覚ましい速度で進んでおり、2017年には「外科医の10倍以上の精度で目の手術が可能なロボット」が登場しましたが、これはあくまでも人間の操作を必要とするロボットハンドに過ぎませんでした。GoogleやIntelが研究機関との連携により作り上げたAI「Motion2Vec」は、手術の映像を見て学習することで、人間の外科医に近い動作をロボットハンドで実現することが可能になったとのことです。

Motion2Vec

https://sites.google.com/view/motion2vec

Intel, Google, UC Berekely AI team trains robot to do sutures

https://techxplore.com/news/2020-06-intel-google-uc-berekely-ai.html

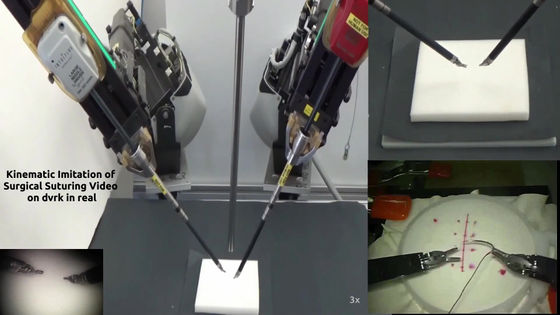

カリフォルニア大学バークレー校のAI技術者Ajay Tanwani氏を中心に、Google BrainやIntel AI Labsが参加した研究チームは、手術用ロボットハンド「ダ・ヴィンチ」を人間の外科医に近い精度で操作可能なAIである「Motion2Vec」を開発することに成功しました。

「Motion2Vec」が実際にロボットハンドを動かしている様子は、以下のムービーを見ると分かります。

Motion2Vec: semi-supervised representation learning from surgical videos - YouTube

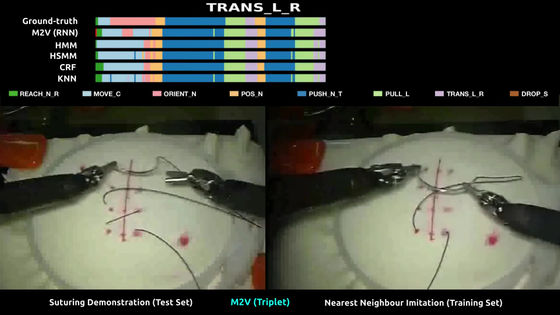

「Motion2Vec」が採用しているシャムネットワークという学習手法は、2つの画像の似ている点と似ていない点を抽出して学習を行うニューラルネットワークです。研究チームは、外科手術の動作の研究用に公開されているデータセットJIGSAWSに収録されている、熟練度が違う外科医8人がダ・ヴィンチで行った縫合の映像を使用して、Motion2Vecのトレーニングを行いました。

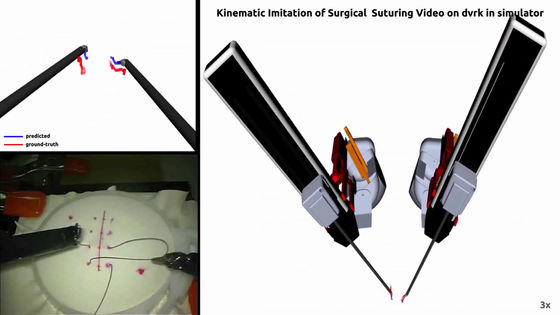

映像からロボットハンドの動作を学習したら、次にロボットハンドをどう動かしたらその動きを模倣できるかをシミュレーションします。

実際に、「Motion2Vec」にダ・ヴィンチを操作させたところ、精度は85.5%以上で、誤差は平均して0.94cmと、それまでのAIよりも高い成績を収めました。また、このトレーニングに必要とした映像資料はわずか78本だったとのことです。

論文の共著者であるケン・ゴールドバーグ氏は、今回の研究の意義について「例えばYouTubeは、1分ごとに500時間の映像資料を得られる素晴らしいデータベースです。しかし、人間なら大抵の映像を見るだけでその意味を理解できますが、ロボットは映像をピクセルの推移としか認識できません。そこで我々は今回、ロボットが映像を見てそれを分析し、ムービーを意味のある映像として捉えられるようにすることを目的としました」と話しました。

また、今後の展望について「我々は、まだ外科医をロボットに置き換えることまではできません。当面の目標は、システムを利用している外科医が『ここに縫合が必要だ』と言えば、ロボットがそれを理解して取りかかれるようにすることです。そうすれば、外科医はより複雑で繊細な手術に集中できるようになります」と話しました。

・関連記事

医師の代わりに自動で手術してくれるロボットが開発中、実際に手術する様子のムービーはこんな感じ - GIGAZINE

世界で初めてロボットが人間の目の手術に成功、人間の外科医の10倍の精度を発揮 - GIGAZINE

YouTubeで外科手術の技術を学ぶ医師が増えてきている - GIGAZINE

採血時の注射針の刺し直しを格段に減らす可能性を秘めた「人間と同じくらい採血がうまいロボット」が登場 - GIGAZINE

・関連コンテンツ

in ソフトウェア, ハードウェア, 動画, Posted by log1l_ks

You can read the machine translated English article AI 'Motion2Vec' that learned and actuall….