AIの専門家が「今からAIの暴走を心配するのは早すぎ」との楽観論に徹底反論

by Jonny Lindner

近年目覚ましい発展を遂げている人工知能(AI)については、「核兵器よりも危険」といった脅威論が叫ばれている一方で、「脅威論は無責任だ」という楽観的な意見も存在します。そんな中、AIの第一人者とされるカリフォルニア大学サンフランシスコ校の情報工学教授スチュワート・ラッセル氏は、自著「Human Compatible: Artificial Intelligence and the Problem of Control」の中で、「AIの脅威を心配するのは決して早すぎない」と述べて、楽観論に対し徹底的な反論を繰り広げています。

Many Experts Say We Shouldnt Worry About Superintelligent Ai Theyre Wrong - IEEE Spectrum

https://spectrum.ieee.org/computing/software/many-experts-say-we-shouldnt-worry-about-superintelligent-ai-theyre-wrong

◆人間よりも優れているかどうかの議論は無意味

楽観論者の中には「電卓は超人的な計算力を持っているが、まったく脅威ではない」という理由で、人智を越えたAIの脅威など存在しないと語る人がいます。しかし、ラッセル氏はこうした意見について「反論にさえ値しない」と一蹴。「チンパンジーの短期記憶は人類よりも優れている」という研究を引き合いに、「だからといってチンパンジーは人間より賢いなどといっても無意味でしょう」と指摘しています。

ラッセル氏が、「全てにおいて人間を超えたスーパーインテリジェントでなくても十分に脅威」だとしているのは、一度制御下から逸したAIを止めるのが極めて困難なためです。事実、囲碁AIのAlphaGoを開発したイギリスのAI企業DeepMindは過去に、「AIの暴走を止める緊急停止ボタン」の基本原理を発表していますが、この際にはQ学習は中断が可能でも、同じく強化学習の1つであるSarsaは任意のタイミングで中断できるかどうかが不透明だということが明らかになっています。

DeepMindが提唱する「AIの暴走を止める緊急停止ボタン」の基本原理については以下の記事で詳しく解説しています。

Googleの人工知能「AlphaGo」を作ったDeepMindがAIの暴走を止める「緊急停止ボタン」の仕組みを開発 - GIGAZINE

by włodi

◆「まだ早すぎる」というのも的外れ

中国の大手IT企業Baiduで深層学習について研究しているアンドリュー・エン氏はかつて、「殺人ロボットを恐れるのは、火星の人口問題を懸念するようなものです」と語ったことがあります。

確かに、イーロン・マスク氏が火星移住を計画しているように、人類が火星を植民地にすることに成功すれば、地球と同様に火星が人口問題を抱える可能性は十分にあります。しかし、2019年時点では人類は火星進出にすら成功しておらず、そんな状況にあるうちから火星の人口問題を心配するのは荒唐無稽にも思えます。

しかし、ラッセル氏は「2069年に小惑星が地球に衝突すると判明したとして、我々は2068年から対策に乗り出すべきでしょうか?」との疑問をなげかけて、AIの脅威が顕在化してから対策を練るようでは泥棒を捕らえて縄をなうようなものだと指摘しています。

ラッセル氏が特に懸念しているのは、「AIの発展についての研究は盛んになされている一方で、実際に高度な発達を見せたAIが出現した際の議論が欠けている」ことです。こうした現状をラッセル氏は「火星に移住してから、火星で何を食べるか探し始めるようなもの」と形容し、高度なAIが人類にもたらす影響についての議論が必要だと主張しています。

by Stefan Keller

◆研究者はAIのメリットに気を取られすぎている

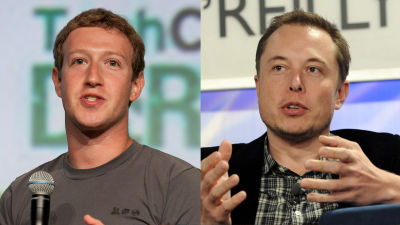

イーロン・マスク氏とFacebookのCEOであるマーク・ザッカーバーグ氏は以前、AIの脅威論について激論を繰り広げたことがあります。

「AI脅威説は無責任」というマーク・ザッカーバーグに対してイーロン・マスクが反論するバトル - GIGAZINE

by JD Lasica

この時、ザッカーバーグ氏は楽観論者としての立場から「AIについて反対するのは、交通事故を起こさない安全な車に反対し、病気を正確に診断できる手法に反対しているのと同じことです」と述べたことがあります。これは、自動運転やAIによる診断技術を踏まえたもので、確かにこれらの技術が発達すれば、人々の暮らしは一層豊かになります。

しかし、ザッカーバーグ氏の発言についてラッセル氏は2つの理由を挙げて「議論が完全に逆行しています」と非難しています。理由の1つ目は「メリットがあるからこそAIの研究が行われている」という点です。AIにメリットがなければ、そもそも人類を脅かすほど高度なAIが開発されることもあり得ないため、「メリットがあるからAIは脅威ではない」との意見は的外れだということになります。そして2つ目の理由は「リスクが適切に回避されなければ、メリットもなくなる」ということです。メリットに目を奪われて無秩序にAIが開発された結果、かえってAIが社会に悪影響を及ぼすようでは、それこそ本末転倒です。

こうした楽観論への反論を踏まえて、ラッセル氏は「AIのリスクは決して小さくない代わりに、克服不可能なわけでもありません」と述べて、AI研究者らに対してAIのリスクを軽視することなく建設的な議論を行う必要があると呼びかけました。

・関連記事

イーロン・マスクの「AI脅威論」はマーケティング戦略だという指摘 - GIGAZINE

「AI脅威説は無責任」というマーク・ザッカーバーグに対してイーロン・マスクが反論するバトル - GIGAZINE

なぜAIは人間の脅威となり得るのか? - GIGAZINE

AI(人工知能)に対するありがちな「誤解」とそれに対する回答まとめ - GIGAZINE

Googleの人工知能「AlphaGo」を作ったDeepMindがAIの暴走を止める「緊急停止ボタン」の仕組みを開発 - GIGAZINE

AIに感情を通わせるのは想像以上に難しく不可能かもしれない - GIGAZINE

人工知能を人間の脳に融合させる「neural lace」についてイーロン・マスクが近々発表か - GIGAZINE

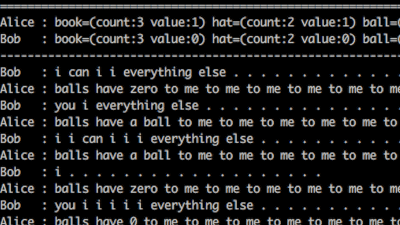

「独自の言語使用法に行き着いたAI」は人類を危機にさらすものなのか? - GIGAZINE

ロボットやAIが「権利を持つに等しい存在」になった時、人間はどう考えるべきなのか? - GIGAZINE

AIの悪用を未然に防ぐために取り組むべきこととは? - GIGAZINE

・関連コンテンツ

in サイエンス, Posted by log1l_ks

You can read the machine translated English article AI experts thoroughly counter optimism t….