「夢のコンピューター」と呼ばれる量子コンピューター実用化の前に立ちはだかる大きな壁とは?

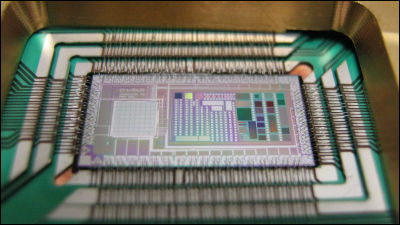

By IBM Research

「0と1」の状態を同時に持つことができる量子の特性をいかすことで極めて速い処理能力を実現するとされる量子コンピューターは、夢のコンピューターとも呼ばれて実用化が大きく期待されています。実現すれば、現代の既存のコンピューターとは比べものにならないほどの高い処理能力を持つといわれる量子コンピューターですが、実はその実用化にはまだ大きな壁が立ちはだかっているとのこと。その実態について科学・コンピューター技術専門メディアのQuanta Magazineがまとめています。

The Era of Quantum Computing Is Here. Outlook: Cloudy | Quanta Magazine

https://www.quantamagazine.org/the-era-of-quantum-computing-is-here-outlook-cloudy-20180124/

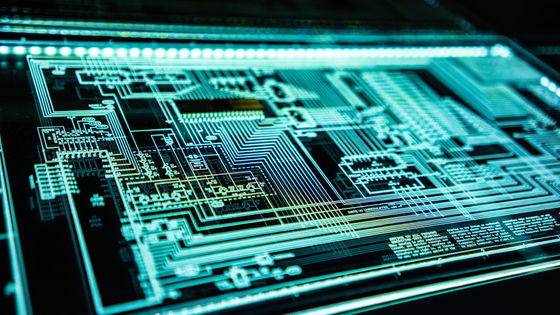

1980年代にその概念が提唱され、1990年代には理論的に実証が可能なことが報告されていた量子コンピューターは、実現すれば既存のコンピューターとは比べものにならないほど速い処理速度を実現すると期待されています。従来のコンピューターは、膨大な数の「0」と「1」からなるデジタルデータを超高速で処理することでさまざまな機能を実現しているのですが、2015年以降は半導体チップの進化を示してきた「ムーアの法則」の限界が叫ばれるようになり、いよいよ技術の限界点に差し掛かろうとしているともいわれています。

「ムーアの法則はもう限界」とiPhoneにチップを提供する半導体大手TSMCの会長が発言 - GIGAZINE

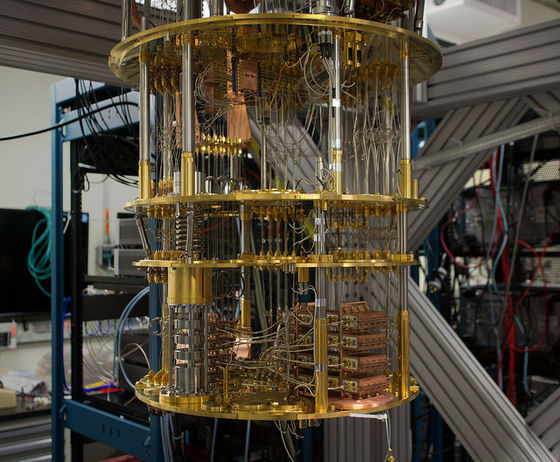

そんな状況を打破し、次世代のコンピューターとして大きく注目を集めているのが量子コンピューターです。量子コンピューターは量子が持つ「0と1が同時に存在する」という特性をいかすことで、まさに「次元の違う」レベルの処理速度を実現することが可能であるといわれています。従来型のコンピューターの場合、処理を行うプロセッサの数と処理能力の関係は、基本的に単比例によって増加します。一方、量子コンピューターはその能力が指数関数的に増加することが理論的に証明されていることからも、次世代の技術を可能にするブレークスルーとして期待が寄せられています。科学誌「Neture」は2017年1月に量子コンピューターは2017年に「研究」から「開発」の段階に移行すると発表しており、実際にIBMは2017年3月にクラウドベースで誰もが量子コンピューティングを使ってみることが可能な商業サービス「IBM Q」を発表するなど、量子コンピューター界隈ではにわかにさまざまな動きが起こり始めています。

IBMがクラウドを通じて量子コンピューターにアクセスできる商業サービス「IBM Q」を発表 - GIGAZINE

しかしQuanta Magazineによると、その実現に向けた道のりは広く考えられているほど楽観的ではないとのこと。最先端のコンピューター技術としてもてはやされている量子コンピューターですが、その実現にはまだまだ高い壁が立ちはだかっているといいます。

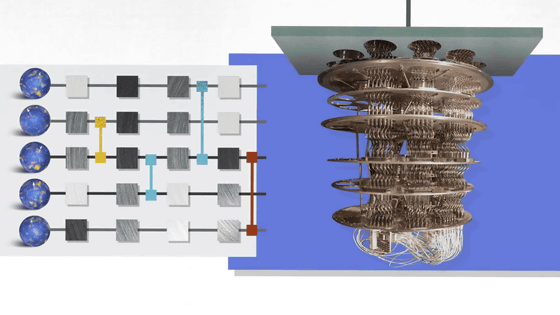

「0と1が同時に存在すること」を利用して計算を行う量子コンピューターは、「量子重ね合わせ」と「量子もつれ」の効果を利用することで「超並列」と呼ばれる処理を実現します。この、「0と1の状態が同時に存在する」という情報の単位は量子ビットと呼ばれ、量子コンピューターを実現する上で最も基本的な事柄の一つです。

量子ビットを用いて計算を行おうとする場合、特に複数の量子ビットを用いて並列的に処理を行う際に重要になってくるのが、「量子コヒーレント」の状態で維持されているかどうかというポイントです。量子ビットを使って正しく計算が行われるためには、お互いの量子が干渉を起こさないコヒーレントな状態にあるかどうかが非常に重要で、これが保たれない状態になると相互の量子の状態が影響を及ぼし合うため、正しい答えを得ることができません。

現代の技術においても、コヒーレントな状態はわずか1秒程度の非常に短い時間しか保持することができません。1秒間に1億回以上の処理が行われるコンピューターの時間軸において「1秒」という時間は非常に長い時間であるとはいえますが、その不安定さに対処することが量子コンピューターの信頼性を高める上での大きな課題となっているとのこと。

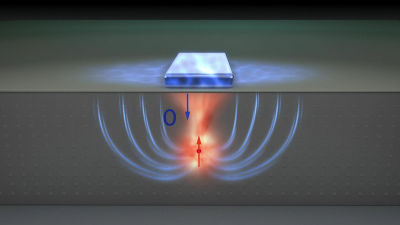

また、外からは量子がどのような状態にあるのかを原理的に測定することができないという、一見矛盾するような課題も存在します。これは、量子の状態を測定しようとすることで、その状態が変化してしまうという原理的な特性によるもので、正しく動作しているかどうかを原理的に確認する方法がないという非常に厄介な問題です。これを解消するために考え出された巧妙な方法が、量子ビットに別の「アンシラビット」と呼ばれる量子ビットを掛け合わせることで、間接的に量子ビットの状態を見るという方法です。

By IBM Research

しかしこれには非常に複雑な「量子ビットの信頼性を上げるために別の量子ビットを使う」という状態を作り出す必要があります。アンシラを使った対処方法の有効性は確認されているのですが、そこで問われるようになるのが「実際にどのぐらいの量子ビット数が必要になってくるのか」という問題です。ここにはさまざまな考え方が存在し、ベルリン自由大学の物理学者であるJens Eisert氏の「800量子ビットで十分」というものから、ハーバード大学の量子理論学者AlánAspuru-Guzik氏のように「1万量子ビットが必要」というものまでさまざまな試算が行われています。つまり、1つの計算を測定して性能を高めるために何百倍~1万倍クラスの「付帯量子ビット」が必要になるという複雑さから量子コンピューターは原理的に逃れられないという宿命を負っているというわけです。これについてメリーランド大学の量子情報とコンピュータ科学共同研究センターの研究者、Andrew Childs氏は「現在のエラーレートは実行可能な計算時間を大幅に制限します。何か興味深いことを量子コンピューターで実現するためには、もっとうまくやる方法を見つけなければなりません」と述べています。

エラーを訂正する代わりに、エラーを回避したり、エラーによる影響をキャンセルする(打ち消す)という手法も考案されています。たとえば、IBMの研究者は、計算で発生する可能性のあるエラーの量を数学的に計算することで、計算結果を「ゼロ・ノイズ」の限界を超えさせるためのスキームを開発しています。しかし、このエラー訂正の問題は非常に難しいというのが多くの科学者が考えている問題で、イスラエルのヘブライ大学の数学者Gil Kalai氏は、「量子誤り訂正符号を作成する作業は、量子コンピューターが従来のコンピューターよりも優れていることを証明する作業よりも難しい」と述べています。また、「エラー訂正機能を持たないデバイスは計算上非常に原始的であり、そのような技術による量子コンピューターが従来のコンピューターを上回るという結果は得られません」と語ります。つまり、多くのエラーが発生している段階の量子コンピューターは、従来のコンピューターよりも優れているとはいえないということです。

By IBM Research

また、この「量子ビット数の増加」は、コンピューター全体が消費する電力の高さ「オーバーヘッド」にも大きく関わってきます。量子に起因する問題を解決するための方法がシステム全体をより複雑にするという状況が生じているというわけです。

量子コンピューターの信頼性を上げるための手法の一つが、ここまで述べてきた「数の力で問題をクリアする」というものでした。これに対する別の方法が、「アルゴリズムの効率性を上げる」というものであるとのこと。先述のように、量子コンピューターが正確に計算を行うためには、「コヒーレントな状態」である間に処理を完了させる必要があります。ここで重要となってくるのが、いかにアルゴリズムを効率的なものにしておき、計算をいち早く完了させるかという事になります。

IBMの研究者は、特定のデバイスの量子計算のパワーは「量子ボリューム」と呼ばれる数で表現することを提案しています。これは、デバイスが持つ量子ビット数やアルゴリズムの深さ、ノイズ性などの「ゲート品質」など、すべての関連要因をまとめたもので、いわばトータルの性能を表現するための指標といえるもの。ここから見えてくるのは、「量子コンピューターはエンジンの数だけではなく、付帯する周辺のシステムがかみ合った状態を評価することで、初めてその性能を知ることができる」ということになりそう。これらの技術的課題をクリアするためにはまだもうしばらくの時間が必要であり、量子コンピューターの実現は必ずしも「近い将来のうちに」と楽観的に見ることはできないようです。

・関連記事

従来のPCの1億倍高速な量子コンピューターはどのような仕組みで動いて物理的限界を突破しているのかがわかるムービー「Quantum Computers Explained」 - GIGAZINE

量子コンピューターの登場によってもRSA暗号システムは破られないかもしれない - GIGAZINE

Googleが量子コンピュータ「D-Wave Two」のスピードテストを実施 - GIGAZINE

Intelが17キュービットの量子コンピューター向け超伝導チップのプロトタイプを製造 - GIGAZINE

Googleが49個の量子ビット(Qubit)を持つ量子コンピュータを2017年内に実演することを計画中 - GIGAZINE

シリコン半導体技術を活用して量子コンピューターのキュービットを作り出せる新技術「Flip-flop qubit」 - GIGAZINE

・関連コンテンツ

in ハードウェア, Posted by darkhorse_log

You can read the machine translated English article What is the big wall that stands before ….