「キラーロボットを作るな」とホーキング博士や研究者1000名以上が提言

by Nathan Rupert

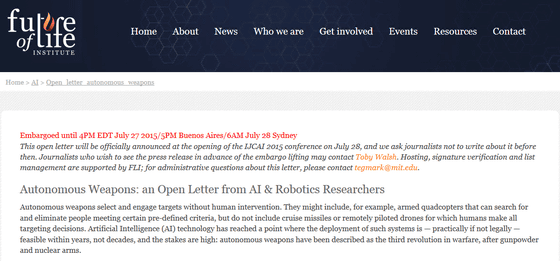

映画「ターミネーター」シリーズには、自らを停止しようとする人類を敵と見なして攻撃を加えてくるコンピューター「スカイネット」が出てきます。現実にはまだこのスカイネット級の「自我を持ったコンピューター」は出てきていませんが、人工知能は核兵器よりも危険度が高いとして、理論物理学者のスティーヴン・ホーキング博士やテスラのイーロン・マスクCEO、Appleの共同創設者スティーブ・ウォズニアック氏、GoogleのDeepMind開発担当者デミス・ハサビス氏など、人工知能研究者・ロボット工学研究者1000名以上が連名で公開書簡をネットに公開しました。

FLI - Future of Life Institute

http://futureoflife.org/AI/open_letter_autonomous_weapons

Musk, Wozniak and Hawking urge ban on warfare AI and autonomous weapons | Technology | The Guardian

http://www.theguardian.com/technology/2015/jul/27/musk-wozniak-hawking-ban-ai-autonomous-weapons

書簡は人工知能を搭載することで自律的に動くロボット兵器「キラーロボット」の危険性を説き、軍事的な方向での人工知能の開発競争を辞めるようにと提言しています。

書簡によると、人工知能は「火薬」「核兵器」に続く、戦争の第3の革命だと呼ばれているとのこと。しかし、核兵器はその原材料を作るのが容易ではないため、誰でも持てるものではありませんが、人工知能搭載の自律型ロボット兵器であれば、原材料はかんたんに揃えることができるため、大量生産すら可能。当然、ブラックマーケットにも流れて、テロリストも容易に手に入れられるものになり、現代のどこの紛争の場でも用いられている自動小銃AK-47(カラシニコフ)のような存在になってしまう可能性があります。

すでに、似たようなコンセプトを持つ「ストップ・キラーロボット」キャンペーンが2013年4月から活動中。

Campaign to Stop Killer Robots

http://www.stopkillerrobots.org/

軍当局は致命的なダメージを与えうる攻撃の決定は人間が下すことになると説明していますが、ある日、ロボットが自らの力を行使する能力を持つことまでは否定していない、とヒューマン・ライツ・ウォッチは指摘。こうしたロボット兵器は、国際人道法にそぐわない部分があり、武力紛争の中での民間人の負傷・死亡のおそれが高まると危険視しています。

Losing Humanity | Human Rights Watch

https://www.hrw.org/report/2012/11/19/losing-humanity/case-against-killer-robots

Ban ‘Killer Robots’ Before It’s Too Late | Human Rights Watch

https://www.hrw.org/news/2012/11/19/ban-killer-robots-its-too-late

2014年8月の時点で、イーロン・マスク氏は「人工知能は核兵器よりも危険性が高いので、扱いには注意を要する」とツイートしていました。

Worth reading Superintelligence by Bostrom. We need to be super careful with AI. Potentially more dangerous than nukes.

— Elon Musk (@elonmusk) 2014, 8月 3

また、ホーキング博士も人工知能の危険性を訴えています。

人工知能は核兵器よりも潜在的に危険、ホーキング博士が「100年以内に人工知能は人間を超える」と警告 - GIGAZINE

スティーブ・ウォズニアック氏も2人と同意見で、自分たちの面倒を見させるためのスマートデバイスを開発したつもりが、デバイスの知能の方が賢くなってしまい、人間が追い出されたり、まるでロボットのペットになってしまうのではないかと懸念を見せました。

Apple co-founder Steve Wozniak on the Apple Watch, electric cars and the surpassing of humanity | afr.com

http://www.afr.com/technology/apple-cofounder-steve-wozniak-on-the-apple-watch-electric-cars-and-the-surpassing-of-humanity-20150323-1m3xxk

ちなみに、国連でもこの種のロボット兵器に関する議論は行われていますが、4月にジュネーブに行われた会議では、「ストップ・キラーロボット」キャンペーンなどの強い働きかけがあったにも関わらず、イギリスが自律型ロボット兵器開発中止に反対の意思を表明しています。

・関連記事

人工知能は核兵器よりも潜在的に危険、ホーキング博士が「100年以内に人工知能は人間を超える」と警告 - GIGAZINE

ホーキング博士らが史上最大の地球外知的生命体探査プロジェクトを発表 - GIGAZINE

Googleの人工知能開発をリードするDeepMindの天才デミス・ハサビス氏とはどんな人物なのか? - GIGAZINE

まさに悪夢、Googleの人工知能「DeepDream」でムービーを作成したらとんでもないことに - GIGAZINE

・関連コンテンツ

in メモ, Posted by logc_nt

You can read the machine translated English article "Do not make killer robots" and suggeste….