LLMはいつどのような時に使うべきか

大規模言語モデル(LLM)は我々のワークスタイルを根底から変革する可能性を秘めたブレイクスルーであり、様々な分野で活用が試みられています。しかしながら、極めて強力なツールというものは可能性と危険性の両面を伴うものであり、LLMについても同じことが言えます。さらに、LLMはあまりにも汎用性が高く、「いつどのように使用すべきか」という疑問は残されたままとなっています。Oxide Computer Companyの共同創業者兼CTOであるBryan Cantrill氏は自社のブログにて、LLMの使用方針に関する投稿を行っています。

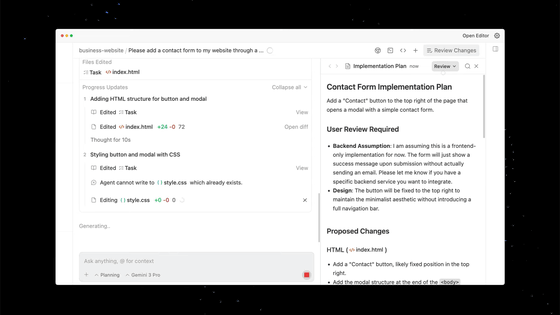

576 - Using LLMs at Oxide / RFD / Oxide

https://rfd.shared.oxide.computer/rfd/0576

Cantrill氏は、Oxide社でのLLMの使用は、以下の価値観に沿うべきである、と述べています。

・責任感:LLMはツールに過ぎず、Oxide社員はLLMが支援する業務に対する説明責任を負う

・厳密性:LLMを慎重に使いこなすことができれば、厳密性を促進し強化することができる

・共感:LLMを使用する際には、言語の向こうには人間の読み手・書き手がいることを忘れてはならない

・チームワーク:LLMの使用によってチーム内の信頼を損なうようなことがあってはならない

・緊急性:LLMを用いて仕事のスピードを追求するあまりに、責任感・厳密性・共感・チームワークを軽んじてはならない

上記を踏まえた上で、Cantrill氏はLLMの用途について個々に考察しています。

◆読者として

LLMはドキュメントの読解と要約を得意とするため、優秀な読者となり得ます。ただし、ChatGPTのようなホスト型LLMにドキュメントをアップロードする際は、データプライバシーを万全にする必要があります。また、LLMを理解支援に使用する場合、人間が見たもの・考えたことを置き換えるような使い方は避け、あくまで補助ツールとしての使い方に徹するべきです。

◆編集者として

LLMは特に文書作成の終盤において、構成や言い回しに関する役立つフィードバックを提供できます。ただし、「LLMは悪名高いお世辞屋である」という点に注意する必要があります。つまり、LLMから賞賛を受けた場合、それは分析の結果ではなく忖度の結果である可能性がある、ということです。この弊害は、文書作成プロセスの序盤からLLMを使用することで顕著になる傾向があります。

◆ライターとして

LLMの出力する文章は陳腐なものになりがちであり、酷い場合は明らかに自動生成された文章であることを示す手がかりだらけの文章となってしまいます。また、文章の信憑性や背景にあるアイデアの本質を損なう可能性すらあります。結果として最悪の場合、読者からの信頼を失う恐れがあるため、LLMを主要なライターとして使用することは到底お勧めできません。

◆コードレビュアーとして

LLMは優れたコードレビュアーになり得ます。ただ、意味のない提案を行ったり、ある問題に隠れたより重大な問題を見落とすこともあります。したがって、LLMはレビューにおいて有用ではあるものの、そのレビュー結果を人間によって行われたレビューの代わりにすることはできません。

◆デバッガーとして

LLMはデバッグにおいて驚くほど役立つことがあります。しかしながら、おそらくそれは我々の期待値が非常に低いからに過ぎません。ただし、一種のラバーダック・デバッグとして、問うべき質問を思いつく一助にはなるかもしれません。厄介な問題をデバッグするにあたり、LLMを使用することで失うものはほとんどありませんが、おそらく得るものもあまりありません。

◆プログラマーとして

LLMは優れたコードを書くのを得意としており、LLMによってソフトウェアエンジニアリングという技術が完全に消滅するのではないか、とも懸念されています。しかしながら、LLMをプログラマーとして使用するのは、ライターとして使用する場合と同じぐらい危険でもあります。LLMは実験的・補助的・一時的なコードの作成には効果的ですが、LLMの提案したコードを出荷されるシステムに近いコードとして適用する場合は、より慎重になる必要があります。もしもLLMが生成したコードを使用するのであれば、責任は「LLMにどういうコードを生成させたか」を理解しているエンジニアが負うことになります。そして、責任を負うべきエンジニアによる自己レビューは不可欠なプロセスであり、自己レビューをクリアしない限りLLMの生成したコードを第三者がレビューすべきではありません。要するに、LLMを用いてコードを生成するのであれば、責任感・厳密性・教官・チームワークを最優先に考えなければなりません。

総括してCantrill氏は、自社においてLLMの使用を推奨していますが、使用する場合は一貫して、製品・顧客・従業員に対する責任を全うするべきであると述べています。

・関連記事

GPT-4oに近い性能で80億パラメータのオープンAIモデル「Rnj-1」をEssential AIが発表、CEOはTransformerを発明したチームの一員 - GIGAZINE

昨今のAIブームは「言語能力こそが知能である」という誤解に基づいているという主張 - GIGAZINE

未査読論文リポジトリのarXivがコンピュータ科学関連の論文の投稿で査読完了を必須条件に、その理由は? - GIGAZINE

OpenAIなどのAI学習元アーカイブを構築してきた非営利団体「Common Crawl」の実態、有料ページを含む数十億のウェブページを2013年以来スクレイピングし続けている - GIGAZINE

WikipediaはAIの台頭でトラフィックが前年同期比で8%も減少、AIの普及で憂き目にあうウェブサイトを救うためにできることは? - GIGAZINE

WikipediaはAIの台頭でトラフィックが前年同期比で8%も減少、AIの普及で憂き目にあうウェブサイトを救うためにできることは? - GIGAZINE

・関連コンテンツ

in AI, Posted by log1c_sh

You can read the machine translated English article When should you use an LLM?….