予測ベースの報酬による強化学習でAIが高難易度の死にゲーで人間以上のハイスコアをたたき出す

AIの非営利研究機関として設立されたOpenAIが開発したRandom Network Distillation(RND)は、好奇心に基づき環境を探索させることで強化学習エージェントを学習させるという、予測をベースとした方法です。OpenAIはこのRNDを用いて、ゲーム「Montezuma's Revenge」における人間の平均的なスコアを上回るスコアをたたき出すエージェントの学習に成功しています。

Reinforcement Learning with Prediction-Based Rewards

https://blog.openai.com/reinforcement-learning-with-prediction-based-rewards/

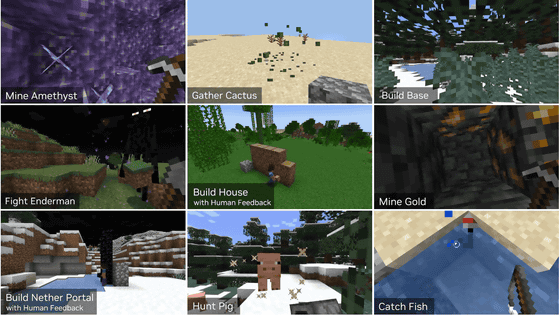

RNDは、固定されたランダムニューラルネットワークがどのような出力を行うか予測することが難しいような、「(エージェントが)慣れていない状況」を実行するようにとエージェントに奨励します。「(エージェントが)慣れていない状況」でどのようなことが起きるのかを予測することは難しいため、それによる報酬はとても大きなものとなるとのこと。なお、RNDは任意の強化学習アルゴリズムに適用することが可能かつ実装が簡単であり、効率的に拡張できるという特徴も持ち合わせています。

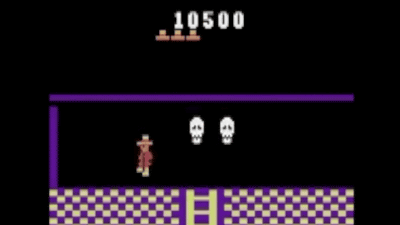

なぜRNDの精度を確かめるためにMontezuma's Revengeが選ばれたのかというと、Googleの開発した自己ゲーム学習AIのDQNも、人間の平均スコア(4700)を上回ることができなかったため。Montezuma's Revengeのレベル1には24個の部屋が用意されているのですが、DQNは15部屋しか探索できませんでした。

Googleの人工知能「DQN」で主人公がすぐ死ぬゲーム「Montezuma’s Revenge」をプレイさせてみた結果こうなった - GIGAZINE

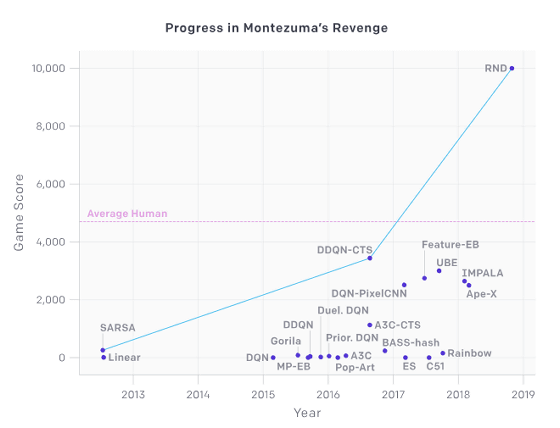

それに対して、RNDを用いて学習したAIエージェントは、レベル1の24部屋すべてを探索可能となり、人間の平均スコアを上回ることも可能。各種AIエージェントがMontezuma's Revengeをプレイすると、スコアがどれくらいになるのかは以下のグラフの通り。縦軸がスコア、横軸がAIエージェントの開発時期を示しており、人間の平均スコア(4700)を越えているのはRNDのみとなっています。

RNDを用いて学習を行ったAIエージェントが、Montezuma's Revengeをプレイする様子は以下のムービーで見ることができます。

Reinforcement Learning with Prediction-Based Rewards - YouTube

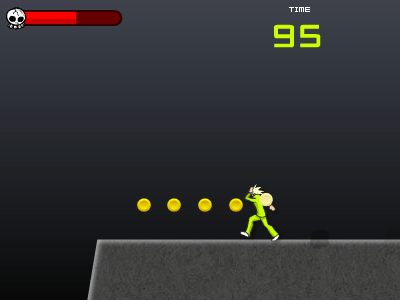

「Montezuma's Revenge」はGoogleの人工知能「DQN」がプレイに苦戦したゲームで、ステージ上の高い場所から落ちたりドクロに触れたりすると主人公が死んでしまうというもの。RNDで強化したAIエージェントは幅広い可能性を示してくれたとのこと。

エージェントは左へ行ったり右へ行ったりしながら……

カギをゲットしてステージを進んで行きます。

高所から落下しないように細い足場を通り、ロープや段差を使って移動。

ただカギを収集するだけでなく、ステージ上の宝石を集めてスコアを高めていきます。

さらに、触れると死亡なレーザーゲートの隙間も巧みにくぐり抜けていきました。

トーチを取ることも可能。

いろんなレベルをクリアできます。

ただゲームをクリアするだけでなく、ステージ上に出現するドクロと一緒にダンスする主人公。RNDを用いて学習すれば、AIとは思えない遊び心を持ったエージェントを作り出すことが可能になるようです。

・関連記事

Googleの自己ゲーム学習AI「DQN」も苦戦した「Montezuma’s Revengeでハイスコアをたたき出すAIの開発」をたったひとつのデモンストレーションから学習することで達成 - GIGAZINE

Googleの人工知能「DQN」で主人公がすぐ死ぬゲーム「Montezuma’s Revenge」をプレイさせてみた結果こうなった - GIGAZINE

Googleの人工知能「DQN」が人間より上手にプレイできるゲームとできないゲームの境界線 - GIGAZINE

AIのマルチタスク学習時に生じる報酬の差異を埋めるための技術「PopArt」をDeepMindが開発 - GIGAZINE

・関連コンテンツ

in 動画, ソフトウェア, ゲーム, Posted by logu_ii

You can read the machine translated English article With reinforcement learning with predict….