メモリ1GB未満のノートPCでも動くビジュアル言語モデル「Smolvlm-256m」「Smolvlm-500m」をHugging Faceがリリース

AI開発プラットフォームのHugging Faceが、画像や短い動画、テキストを分析できるAIモデルとしては最小となる「SmolVLM-256M」「SmolVLM-500M」をリリースしました。Hugging Faceによれば、この2モデルはメモリが1GB未満のノートPCでも適切に動作するように設計されているとのことです。

SmolVLM Grows Smaller – Introducing the 256M & 500M Models!

https://huggingface.co/blog/smolervlm

Hugging Face claims its new AI models are the smallest of their kind | TechCrunch

https://techcrunch.com/2025/01/23/hugging-face-claims-its-new-ai-models-are-the-smallest-of-their-kind/

Hugging Faceによれば、SmolVLM-256Mのパラメータ数は2億5600万で、世界最小のビジュアル言語モデル(VLM)だとのこと。また、SmolVLM-500Mのパラメータ数も5億で、VLMとしては超軽量であるという特徴を持ちます。

SmolVLM-256MはVLMとしては最小の規模でありながら、画像のキャプション付けやテキスト応答、基本的な視覚的推論など、多くのマルチモーダルタスクをこなせるとのこと。より大規模なSmolVLM-500Mは、2Bモデルよりも小さいにもかかわらず、さまざまなタスクで優れた性能を発揮し、プロンプトに対してより堅牢(けんろう)な応答が可能です。

Hugging Faceによれば、従来のSmolVLM 2Bや他の大規模VLMで使用されていたSigLIP 400M SO(パラメータ数4億)と比較実験を行った結果、性能向上がわずかであったことから、SmolVLM-256MとSmolVLM-500Mのエンコーダーにはより小サイズなSigLIP base patch-16/512(パラメータ数9300万)が採用されているとのこと。加えて、AppleのVLM研究とGoogleのPaliGemmaにヒントを得ることで、より高い解像度で画像を処理できるようになったそうです。

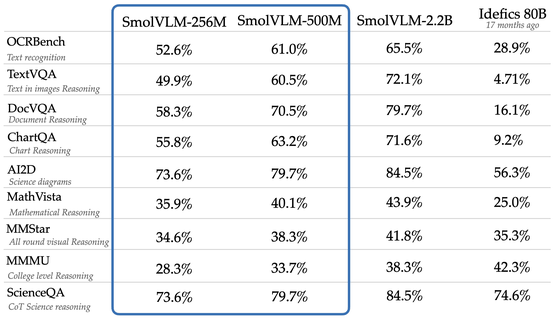

SmolVLM-256MとSmolVLM-500Mを、Hugging Faceが開発したSmolVLM-2.2BやIdefics 80Bとベンチマーク結果を比較した表が以下。より小規模なSmolVLM-256MでもOCRBenchで52.6%、TextVQAで49.9%など、一部のタスクではIdefics 80Bの性能を上回っているとHugging Faceはアピールしています。

さらにHugging Faceは、ColBERTライクな検索モデルを開発しているチームによって「ColSmolVLM」というモデルが開発されていることを明かしています。ColSmolVLMは自身の10倍の規模を持つモデルに匹敵する性能を持ち、最先端のマルチモーダル検索速度を実現したとのこと。ColSmolVLMはファインチューニングが容易で実験がしやすいため、検索可能なデータベースをより速く、より低コストで構築できるようになるとHugging Faceは述べています。

また、Hugging FaceはIBMと協力してDocling用のモデルも開発しており、特に256Mモデルを使用した初期の実験結果が印象的な成果を示しているとのこと。今後のアップデートについても期待が寄せられていると報告しています。

SmolVLM 256MとSmolVLM 500Mのモデルは、以下からダウンロード可能。

SmolVLM 256M & 500M - a HuggingFaceTB Collection

https://huggingface.co/collections/HuggingFaceTB/smolvlm-256m-and-500m-6791fafc5bb0ab8acc960fb0

また、SmolVLM 256MとSmolVLM 500Mをブラウザ上から試すことができるデモサイトは、以下で公開されています。このデモサイトでは、ブラウザ上で高速なグラフィックス処理を可能にするWebGPUを推論演算に使うとのこと。

SmolVLM 256M Instruct WebGPU - a Hugging Face Space by HuggingFaceTB

https://huggingface.co/spaces/HuggingFaceTB/SmolVLM-256M-Instruct-WebGPU

SmolVLM 500M Instruct WebGPU - a Hugging Face Space by HuggingFaceTB

https://huggingface.co/spaces/HuggingFaceTB/SmolVLM-500M-Instruct-WebGPU

なお、IT系ニュースサイトのTechCrunchは、「SmolVLM-256MやSmolVLM-500Mのような小型モデルは安価で多様な機能を持つかもしれませんが、大型モデルではそれほど顕著ではない欠陥も抱えている可能性があります」と指摘しています。

・関連記事

Googleがオープンソースのビジュアル言語モデル「PaliGemma」を公開&Llama 3と同等性能の大規模言語モデル「Gemma 2」を発表 - GIGAZINE

GoogleのAIに匹敵するオープンソースのAIモデル「Falcon 2」をUAEがリリース - GIGAZINE

Metaがテキストベースのプロンプトに視覚情報ベースで回答するAIエージェントのベンチマーク「OpenEQA」をリリース - GIGAZINE

Googleが映像と音声を理解して質問に答えるGPT-4oっぽいAIエージェント「Project Astra」を発表 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1i_yk

You can read the machine translated English article Hugging Face releases visual language mo….