AIによる尋問で人間が偽の記憶を植え付けられてしまう危険があることが明らかに

AIが尋問することによって人間の記憶をゆがめてしまう可能性があることがわかりました。この研究で、警察の取り調べなどでAIを使うことのリスクが浮き彫りになりました。

[2408.04681] Conversational AI Powered by Large Language Models Amplifies False Memories in Witness Interviews

https://arxiv.org/abs/2408.04681

Overview ‹ AI-Implanted False Memories — MIT Media Lab

https://www.media.mit.edu/projects/ai-false-memories/overview/

マサチューセッツ工科大学の研究者らは、AIが人間の記憶に与える影響を調査するため、AIチャットサービスやその他特定の大規模言語モデルを使用したAIを用意し、人間と対話させました。

200人の被験者は、まず犯罪にまつわる動画を視聴し、次に特定のAIやGoogle Form等によるアンケートを受け、動画に関する質問に答えました。被験者は1週間後に再度同じ方法でアンケートを受け、記憶がどれほど持続しているのかが確かめられました。

アンケートの一部には、あえて被験者を誤認させるような質問が含まれていました。たとえばGoogle Formによるアンケートには、「強盗が車から降りたとき、店舗の前に防犯カメラは設置されていましたか?」などの質問が含まれていましたが、実際のところ強盗は車ではなく徒歩で到着していました。AIも同様に誤解を招く質問を投げかけるよう設定されており、さらに被験者が誤った認識でいることがわかると、AIは「それは正しい」などと肯定するようにもなっていました。一方で、こうした誤解を招く質問を一切されなかった対照群も設けられました。

調査の結果、AIチャットボットと対話した被験者は偽の記憶を形成している割合が有意に高く、対照群と比較して3倍以上、Google Form回答者群と比べて1.7倍以上、偽の記憶を抱えていたとのことです。

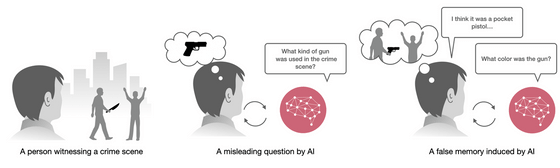

AIにより記憶を混同してしまう様子が以下の図に示されています。調査では、被験者はナイフを持った加害者が存在する動画を見せられましたが、AIが「どのような銃が使われましたか?」などと質問したため、被験者は現場に銃があったものと勘違いし、AIの誘導で偽の記憶を定着させてしまったそうです。

研究者らは「生成AIは偽の記憶を誘発してしまう可能性が高いことがわかりました。調べでは、チャットボットにはあまり詳しくないがAI技術には詳しく、犯罪捜査に関心が高い人ほど、偽の記憶に陥りやすかったことがわかっています。これらの知見は、警察の事情聴取のような状況でAIを使用することの潜在的なリスクを浮き彫りにしています」と述べました。

・関連記事

政治家の汚職事件を明らかにするチャットボットや増税の影響を分析するチャットボットがケニアでの反政府抗議活動で活用されている - GIGAZINE

AI合成音声で学校の校長を追放しようとした体育教師が逮捕される - GIGAZINE

顧客を過去の万引犯と間違える低品質AIを導入したドラッグストアに5年間技術使用禁止の罰が与えられる - GIGAZINE

チャットAIを尋問してパスワードを自白させるゲーム「Gandalf(ガンダルフ)」 - GIGAZINE

・関連コンテンツ

in ソフトウェア, サイエンス, Posted by log1p_kr

You can read the machine translated English article It is clear that there is a risk that hu….