機械学習を活用しプロのような写真レタッチ加工をスマホでも処理できる技術をMIT・Googleの研究者が発表

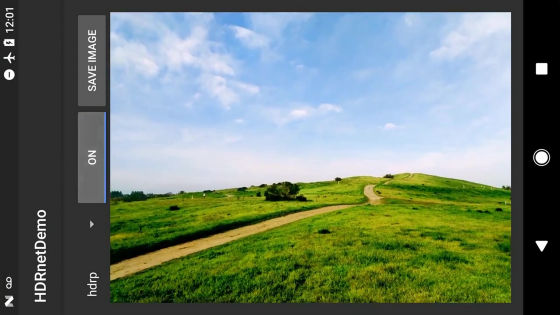

スマートフォンで撮影した写真をSNSなどに投稿するときに、軽いレタッチをするのはごく一般的です。しかし、スマートフォン性能の制限もあり、できる作業は限られています。MITとGoogleの研究者が、SIGGRAPH 2017で機械学習を使って画像編集のプロのようなレタッチをスマートフォンでほぼリアルタイムで行えるシステムを発表しました。

Deep Bilateral Learning

https://groups.csail.mit.edu/graphics/hdrnet/

Automatic image retouching on your phone | MIT News

http://news.mit.edu/2017/automatic-image-retouching-phone-0802

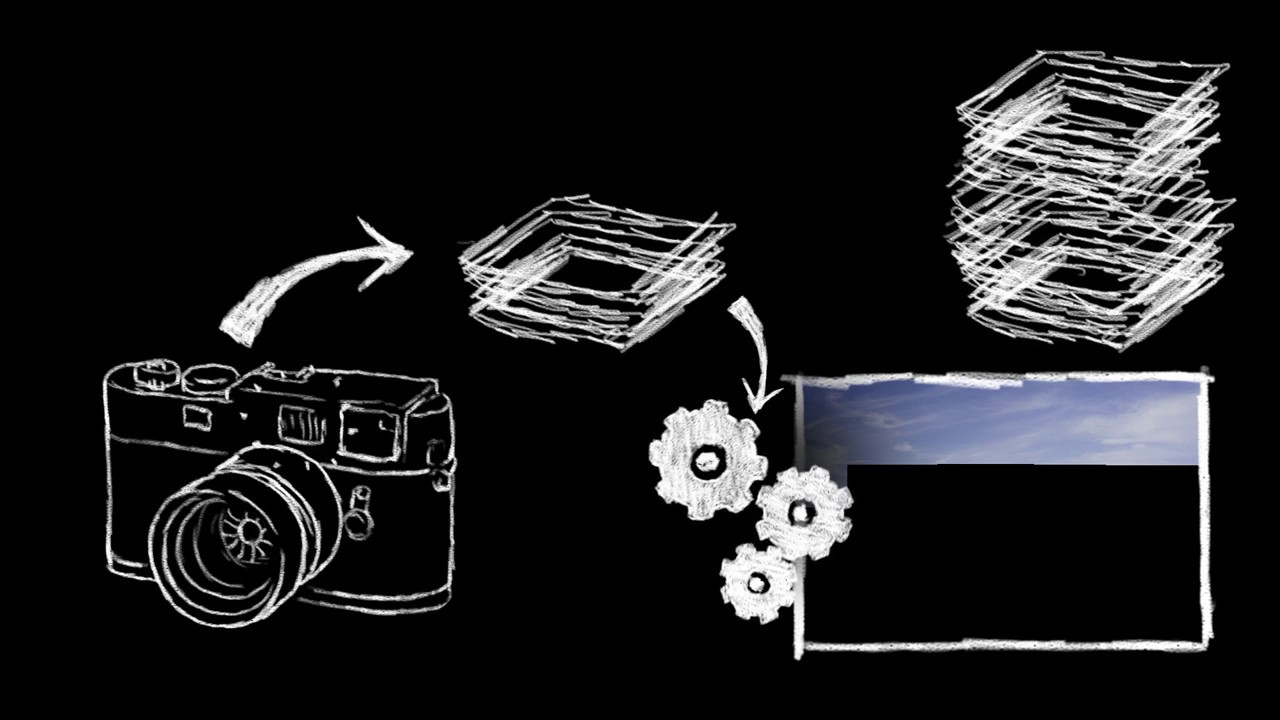

MITとGoogleの研究者が開発した機械学習システムを使って非力なスマートフォンでも画像レタッチ加工を簡単に処理する技術の概略は以下のムービーで解説されています。

Deep Bilateral Learning for Real-Time Image Enhancement - YouTube

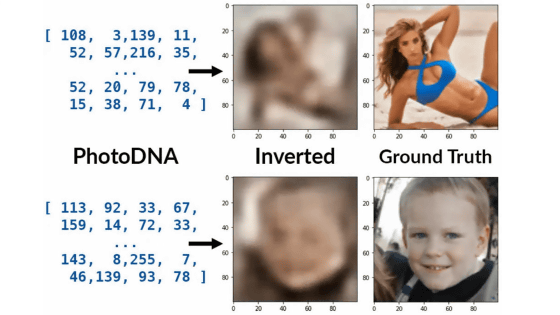

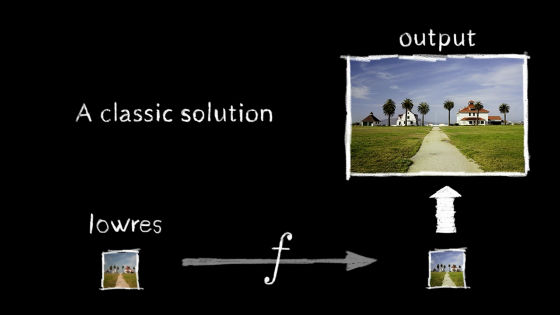

今回、MITとGoogleの研究者によって共同開発されたレタッチ技術は、画像処理の大部分を低解像度画像で実行するところが大きな特長です。高解像度写真を素材にした機械学習システムでは高いマシン性能が要求されますが、低解像度画像であればスマートフォンでも処理ができるというわけです。しかし、低解像度画像を使うことから、高解像度写真の個々のピクセルのカラー値は、機械学習システムからの荒い出力から予想しなければならないという難しさに直面しました。

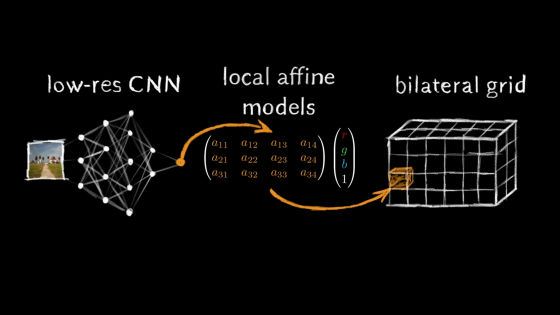

そこで、研究者たちは機械学習システムの出力を「画像」ではなく、ピクセルの色を変更するための簡単な「式のセット」に変更しました。トレーニングの間、システムのパフォーマンスは、オリジナルの高解像度写真に適用されたときに出力される式とレタッチされた画像からの式とどれくらいよく似ているかで評価されました。さらに、式を高解像画像の個々のピクセルに当てはめる上で、16×16×8という3次元のグリッドを取り入れました。16×16の面は元画像のピクセル位置に、8つの層は異なるピクセルの明度に相当するようにしたとのこと。

研究者たちは、Durand's groupとAdobeによって作成されたデータセットでシステムを訓練しました。このデータセットには5000枚の画像イメージがあり、それぞれが異なる5人の写真家によってレタッチされていたとのこと。さらに、HDR画像を作成するための画像処理アルゴリズムなどを適用して生成された数千対の画像を使ってシステムを訓練しました。

最終的にシステムの性能を調べるために、低解像度画像で処理する開発システムと低解像度画像ではなく元画像と同じ解像度で処理した場合を比較したところ、元画像を使う場合では12GBのメモリが必要だったのに対して、低解像度画像での処理では100MBのメモリが必要と、必要なメモリは100分の1以下で足りたそうです。

MITのジョン・バロン教授は、「今回開発した機械学習システムの技術は、スマートフォンでのリアルタイムな画像レタッチ処理をとても便利にする可能性を秘めています。画像を機械学習する上で、スマートフォンでは計算・電力リソースに厳しい制限がありますが、この制限を回避して、リアルタイムで美しい写真を撮影する体験をもたらしてくれるかもしれません」と述べています。

・関連記事

Googleが低解像度画像を爆速で高画質化する機械学習を使った技術「RAISR」を発表 - GIGAZINE

画像を塗りつぶした部分に一瞬で自然な画像を補完する技術を早稲田大学の研究者が開発 - GIGAZINE

ディープラーニングで白黒アニメをカラー化するとこうなる - GIGAZINE

8×8ピクセルに縮小した画像から元の画像を予想する技術をGoogle Brainが開発 - GIGAZINE

・関連コンテンツ

in 動画, ソフトウェア, スマホ, Posted by darkhorse_log

You can read the machine translated English article MIT · Google researchers announced tech….