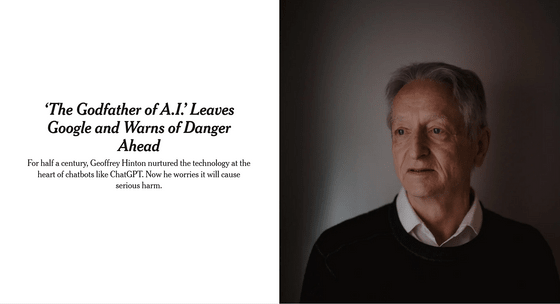

「AIのゴッドファーザー」がAI研究を後悔しGoogleを退社

コンピューター科学と認知心理学の研究者であるジェフリー・ヒントン氏は、2018年に「コンピューター科学のノーベル賞」とされるチューリング賞を受賞した、この分野の大家です。ニューラルネットワークにおける功績から「AIのゴッドファーザー」と呼ばれているヒントン氏が、2023年4月にGoogleを辞めていたことが分かりました。

‘The Godfather of AI’ Quits Google and Warns of Danger Ahead - The New York Times

https://www.nytimes.com/2023/05/01/technology/ai-google-chatbot-engineer-quits-hinton.html

ヒントン氏は、2012年にニューラルネットワークのアーキテクチャであるAlexNetの論文を教え子らとともに発表し、これにより「ニューラルネットワーク」という言葉の名付け親となったAI研究のパイオニアです。翌年の2013年にGoogleで働くようになってからは、10年以上にわたってGoogleでAIシステムの研究を行ってきました。

しかし、ヒントン氏はカナダ・トロントにある自宅で受けたThe New York Timesのインタビューで、2023年4月にスンダー・ピチャイCEOに連絡し、辞意を伝えていたことを明らかにしました。ヒントン氏は、「自分がAI研究に携わっているうちはGoogleや他のAI企業を公に批判したくない」との思いから、これまで声高にAIの危険性を唱えることを避けていましたが、AIの危険性について自由に発言するためにGoogleを後にしたとのこと。

インタビューの中でヒントン氏は、自身が半生をささげたライフワークを後悔していると吐露した上で、「悪者がAIを悪事に利用するのを防ぐ方法は、なかなか見当たりません」と話しました。

記事作成時点で75歳となるヒントン氏のAI研究者としてのキャリアは、イギリス・エディンバラ大学の大学院生だった1972年にさかのぼります。このころからニューラルネットワークの基礎となる技術の構想を持っていたヒントン氏ですが、当時そのアイデアを理解する研究者はほとんどいませんでした。

そして、1980年代にはアメリカのカーネギーメロン大学の教授として教壇に立っていましたが、国防総省からの資金援助を嫌ってカナダへと渡りました。当時、アメリカのAI研究のほとんどは国防総省の資金提供を受けていましたが、ヒントン氏は戦争でAIが使われること、ヒントン氏が言うところの「ロボット兵」に深い懸念を抱いており、国防総省の関与を嫌ったためです。

そして2012年に、トロント大学の学生であったアレックス・クリジェフスキー氏とイルヤ・サツキヴァー氏とともにAlexNetの研究論文を発表しニューラルネットワーク技術の基礎を打ち立てました。

ヒントン氏とともにニューラルネットワークを開発した2人のうち、イルヤ・サツキヴァー氏は後にOpenAIの共同設立者となった人物。サツキヴァー氏もまた、AI技術のリスクから「私たちは間違っていた」と語り、それまでオープンにしてきたAI研究の情報公開を制限する方針へと転じています。

OpenAIの共同設立者が「私たちは間違っていた」と語る、AIの危険性からデータをオープンにしない方針へと大転換 - GIGAZINE

その後、Googleがヒントン氏と学生2人が立ち上げた会社を買収してからも、ヒントン氏らはAI研究を続け、これがChatGPTやBardといったAIの登場につながりました。ヒントン氏ら3人は2018年に、ニューラルネットワーク研究の功績でチューリング賞を受賞しています。

当時、ヒントン氏は「ニューラルネットワークは機械が言語を理解し、生成するための強力な方法」だと考えていましたが、人間に匹敵するとは思っていなかったとのこと。しかし、ChatGPTを始めとするジェネレーティブAIが登場したことにより「もしかすると、このシステムで起きていることは人の脳で起きていることよりもずっと優れているかもしれない」と感じ、AIへの見方が大きく変わりました。

企業によるAI開発競争に懸念を持つヒントン氏が、これまでGoogleにとどまっていたのは、Googleが危険な技術を公開しないよう注意を払っていたからです。しかし、MicrosoftがBing検索にチャットボットを導入し、GoogleもBardでこの分野に参入したことで、ヒントン氏はGoogleの「AI技術の節度ある管理者」としての役割に疑問を持つようになりました。

Bardの公開は、Google社内からも「時期尚早」との批判が出ていることが報じられています。

Google社員は「Bard」の性急すぎる発表に不満を抱いている - GIGAZINE

ヒントン氏の当面の懸念は、インターネット上に偽の写真や動画、文章が氾濫して一般人が「何が真実か分からなくなること」です。また、AIが雇用市場を根底から覆すことも危惧しています。これまでのところ、ChatGPTのようなジェネレーティブAIは人間の仕事を補完していますが、パラリーガル(法務関係の仕事)やパーソナルアシスタント、翻訳者など定型的な仕事をしている人に取って代わる可能性があることも指摘されています。

また、AIは膨大なデータを分析し、人間が予期していない行動も学習することから、将来的には人類を脅かす存在になるかもしれないと、ヒントン氏は憂慮しています。もし、企業がAIにコードを生成させるだけでなく、実際にそのコードを実行させるハードウェアを与えれば、真の自律兵器、つまりヒントン氏が恐れる殺人ロボットが現実のものになるかもしれません。

ヒントン氏の教え子や同僚など、多くの専門家はこのような脅威論は仮定の話であると考えています。しかし、ヒントン氏はGoogleやMicrosoftなどの大企業の競争が世界的なものに発展し、国際的な規制も行われなければ、開発競争に歯止めをかけることはできなくなるかもしれないと考えています。

ヒントン氏は、「AIが人間より賢くなれるという考えは少数派で、ほとんどの人はそんなことはあり得ないと思っていましたし、私もそうでした。もしあるとしても、30年か50年は先の話だと。しかし、もう私はそうは思いません」と話しました。

AIの危険を唱える立場の人の中には、「AIの脅威は核兵器に匹敵すると」と唱える人がいますが、開発に大規模な核実験が必要な核兵器とは異なり、秘密裏に研究が進められるAIの存在を人々が知るすべはありません。

ヒントン氏は以前、危険な技術になぜ取り組めるのかと聞かれた時、原子爆弾の開発を主導したロバート・オッペンハイマーの言葉を引用して、「魅力的な技術があったら、思い切ってやってしまえ」と答えていましたが、もうそんな言葉を口にしようとは思わないと話しました。

・関連記事

「AIが人間と同レベルの知性を獲得する日は来るのか?」という質問に5人の専門家が回答 - GIGAZINE

AIを作るAIを作る - GIGAZINE

「AI開発で企業は学会よりも先行」「AIは環境を助けると同時に害も」「世界最高の新人科学者はAI」「AIの悪用に関するインシデントの数は急速に増加」などAIの実態をレポートする「AI Index Report 2023」をスタンフォード大学が公開 - GIGAZINE

「感情認識AI」の危険性を専門家が警告、一体何が問題なのか? - GIGAZINE

AIの台頭で生まれる「新興宗教」とそのリスクとは? - GIGAZINE

なぜAIは人間の脅威となり得るのか? - GIGAZINE

・関連コンテンツ