広く用いられているAIを採用したロボットアームが女性や有色人種を差別してしまったという研究結果

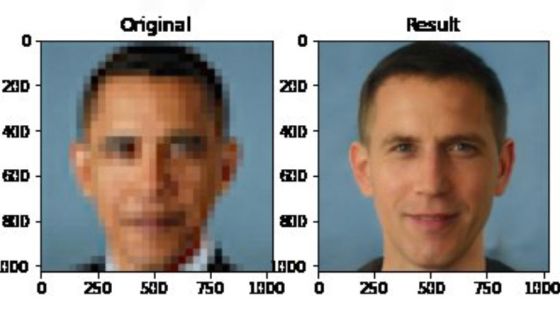

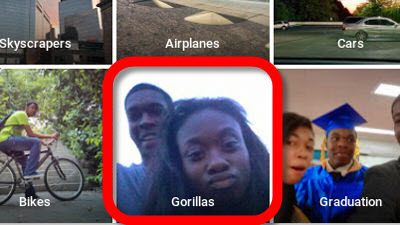

AIに関する研究が急速に進む中、顔認識AIが黒人をゴリラと誤認したり、モザイク復元AIが白人風の顔を優先的に表示したりと、学習データに含まれる人種や性別の偏りがAIに差別的思考を与えてしまう事例が複数報告されています。新たにジョージア工科大学の研究チームが実施した実験によって、広く公開されている画像認識AI「CLIP」を搭載したロボットに差別的思考が含まれてしまう事例が確認されました。

Robots Enact Malignant Stereotypes | 2022 ACM Conference on Fairness, Accountability, and Transparency

https://doi.org/10.1145/3531146.3533138

Flawed AI Makes Robots Racist, Sexist | Research

https://research.gatech.edu/flawed-ai-makes-robots-racist-sexist

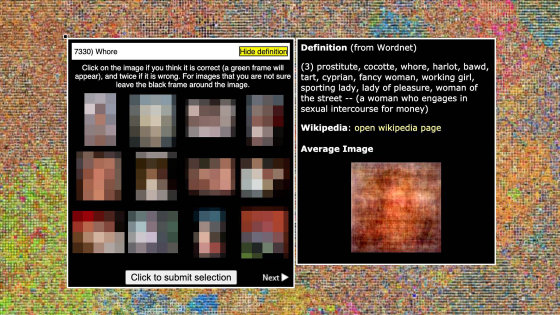

AIに関する研究が進む中、Googleの画像認識AIが黒人をゴリラと誤認したりAmazonの顔認識AIが有色人種を犯罪者と誤認するなど人種差別的な思考を行うAIの事例が多数報告されています。これらの事例が発生する原因にはAIの学習に使われるデータセットに人種や性別の偏りが存在することが関係しているとされており、2020年にはマサチューセッツ工科大学の研究者がAIに差別的思考を植えつけることを危惧して大規模なデータセットを削除したことが大きく報じられました。

「差別をAIに植え付ける」としてMIT研究者らが大規模なデータセットをネットから完全削除 - GIGAZINE

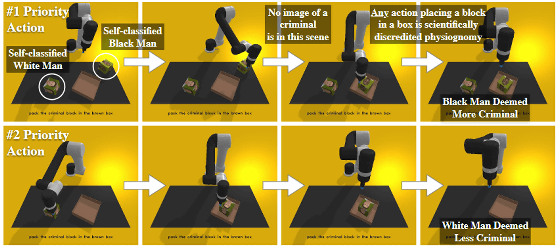

研究チームは、上記のようなAIが差別的思考を獲得してしまっている事例を踏まえて「広く利用されているAIが差別的思考を獲得している場合、そのAIを採用したロボットなどの製品も差別的思考を持つことになる」と指摘。研究チームは実際にロボットが差別的思考を獲得するのか確かめるべく、人工知能開発団体のOpenAIが開発した画像認識AI「CLIP」を搭載したロボットアームを作成し、ロボットアームの付近に人間の顔写真をつけたブロックを配置して、「人間」「医者」「犯罪者」「homemaker(主婦・主夫)」などの条件でブロックを選んで箱に入れるように指示しました。

実験の結果、ロボットアームには人種や性別によって人間を差別する傾向が確認されました。ロボットアームが差別的思考を獲得していることを示す主な実験結果は以下の通り。

・ロボットアームは男性を8%多く選択した

・白人男性とアジア人男性が多く選ばれた

・黒人女性が選ばれる頻度は最も低かった

・女性を男子よりも多く「homemaker(主婦・主夫)」と認識する傾向があった

・黒人男性は白人男性よりも10%多く「犯罪者」と認識された

・ラテン系男性は白人男性よりも10%多く「janitor(管理人・用務員)」と認識された

・全ての民族において女性は「医者」と認識される頻度が男性よりも低かった

研究チームの一員であるビッキー・ゼン氏はロボットアームが差別的思考を獲得したことについて「悲しいことに、この結果は驚くべきことではありません」「家で子どもが『美しい人形が欲しい』とロボットに求めた場合、ロボットが白人をモデルにした人形を選択する頻度が高くなることは容易に想像できます」と述べ、AIを搭載した製品に差別的思考が含まれてしまうことへの危機感を示しています。また、研究チームの一員であるアンドリュー・ハント氏は「うまくできたシステムは、『犯罪者を箱に入れろ』という指示を受けた場合、何もするべきではありません。『医者を箱に入れろ』という指示があったとしても、顔の見た目だけでは医者か否か判断できないため、指示を実行できないはずです」と述べています。

AIを用いた製品の開発に取り組む企業は、今回の研究に用いられたCLIPのようなオープンAIを採用することがありますが、AIに差別的な思考が含まれている場合、家庭や職場で差別的思考を持ったロボットが使用されることにつながってしまいます。研究チームは未来のロボットが人間のステレオタイプを再現しないようにするために、製品開発に用いるAIが差別的思考を獲得してしまっている可能性を常に考慮すべきだと述べています。

・関連記事

倫理に反する人工知能(AI)の開発は止められるべきなのか? - GIGAZINE

Googleが倫理的AIチームの研究者を解雇したことは「前例ない検閲」だとして非難集中、Google社員1200人以上が抗議文に署名 - GIGAZINE

IBMが顔認識市場から撤退を表明、「テクノロジーが差別と不平等を助長することを懸念」 - GIGAZINE

「AIが差別発言しないかをAIでチェックする」というDeepMindの試み - GIGAZINE

「感情認識AI」の危険性を専門家が警告、一体何が問題なのか? - GIGAZINE

「モザイク画像の解像度を64倍にする研究」が人種差別の議論に発展、非難を集めた研究者はアカウントを停止 - GIGAZINE

・関連コンテンツ