AppleはiCloudメールの添付ファイルを2019年からスキャンしていた

Appleは2021年秋に公開予定のiOS 15から、iOSデバイス上やiCloudに保存された画像をスキャンして「児童の性的搾取に関連するデータ(CSAM)」をハッシュによりチェックする仕組みを導入すると、2021年8月5日付で発表しました。Appleの発表に対しては社内外から「ユーザーのセキュリティとプライバシーを損なう」という反発の声が上がっていますが、Apple関連の情報サイトである9to5Macが確認したところ、Appleは2019年からすでにiCloudメールでCSAMコンテンツをスキャンしていたことが判明しています。

Apple already scans iCloud Mail for CSAM, but not iCloud Photos - 9to5Mac

https://9to5mac.com/2021/08/23/apple-scans-icloud-mail-for-csam/

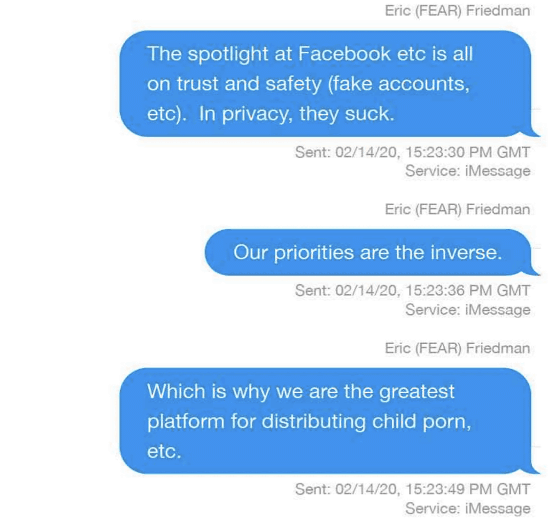

AppleがCSAMのスキャンを実施する決断に至った理由として、Apple製品のプライバシー保護の高さが、不正コンテンツの隠れみのになっているという考えがあります。2021年8月19日、ニュースメディアのForbesは、Appleの不正防止部門チーフのエリック・フリードマン氏が「我々は児童ポルノを配布するには最高のプラットフォームになってしまっている」という内容をiMessageで同僚に送信していたことを報じました。

フリードマン氏は、「Facebookはフェイクアカウントの検知といった点で優れていますが、プライバシーについては最低です。一方、私たちの優先順位は逆です。だからこそ児童ポルノを配布するための最高のプラットフォームとなってしまっています」とメッセージを送信。これに対しメッセージの送信相手である幹部は「本当ですか?つまり、私たちのエコシステムにそれが大量にあるということでしょうか?他のファイル共有システムを利用する人はもっと多いと思うのですが」と返しましたが、フリードマン氏は「Yes」と、Appleが児童ポルノを配布するプラットフォームとして利用されていることを肯定しました。

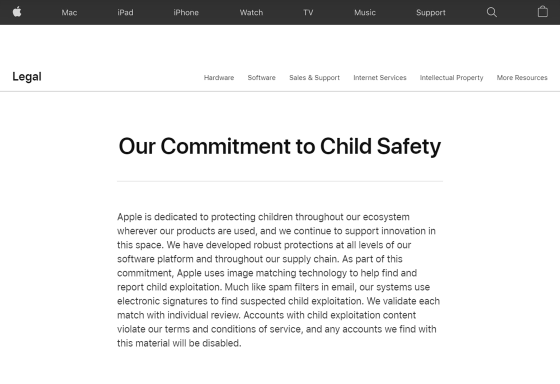

この報道を受けて、9to5Macのベン・ラブジョイ氏は「なぜAppleは自社のプラットフォームに児童ポルノが多く存在すると知ることができたのか?」と疑問に思ったとのこと。そこで調査を行ったところ、まず、過去に公開されていた「Our Commitment to Child Safety(児童の安全に対する私たちの献身)」というページで「Appleは児童搾取を発見・報告するために画像照合技術を利用しています。スパムフィルターのように、私たちのシステムは児童搾取の疑いがあるものの発見に、電子署名を使用します。照合されたものは個別にレビュー・検証されます。児童搾取のコンテンツを保有していたアカウントは利用規約に違反するとして、いかなるアカウントでも無効となります」という文章が見つかったそうです。

以下は該当ページのアーカイブ。

Legal - Our Commitment to Child Safety - Apple

また、Appleのプライバシー部門最高責任者であるジョン・ホーヴァス氏は2020年の技術会議で、Appleがスクリーニング技術を利用して違法な画像を探していると発言しています。ホーヴァス氏も児童搾取の画像を見つけた場合は該当アカウントを無効にすると述べていますが、どのように発見するかという詳細については触れていません。

ラブジョイ氏がAppleに問い合わせたところ、Appleはまず、同社がiCloudの写真をスキャンしたことは一度もないと返答。一方で、2019年からiCloudメールについては送信・受信のいずれに対しても添付ファイルにCSAMが含まれないかスキャンしてきたことを認めました。iCloudメールは暗号化されていないため、Appleのサーバーは容易にスキャン可能であったとラブジョイ氏は指摘しています。

またAppleは「他のデータに対しても限定的なスキャンを行ってきた」ことを示唆しましたが、具体的にどのようなスキャンを実施したかは述べなかったとのこと。ただし、スキャンは小規模なものであり、「他のデータ」にiCloudのバックアップが含まれないことを説明しています。

Appleはフリードマン氏の発言についてコメントしていませんが、ラブジョイ氏はAppleが毎年報告してきたCSAMの数がわずか数百件であるため、AppleがiCloudの写真をスキャンしてきたという考えを否定的に見ています。フリードマン氏の発言は、他のクラウドサービスが積極的にCSAMのスキャンを実施する一方で、AppleはiCloudでCSAMスキャンを実施していないことから至った推論だろうと見解を述べました。

なお、CSAMをチェックする仕組みを導入するというAppleの発表に対しては、「AIを用いた自動化されたプロセスにはエラーが発生しやすく、AIが疑わしいとみなしたコンテンツやメタデータが、人間の検証なしに民間組織や法執行機関に送られてしまう」という指摘が存在します。自動化されたメッセージとチャットの監視が行われれば、デジタル通信の機密性が崩壊してしまうと考えられており、エドワード・スノーデン氏も「児童ポルノについてのスキャンが可能になれば、近い未来にあらゆるコンテンツのスキャンが行われることになる」と警鐘を鳴らしました。

No matter how well-intentioned, @Apple is rolling out mass surveillance to the entire world with this. Make no mistake: if they can scan for kiddie porn today, they can scan for anything tomorrow.

— Edward Snowden (@Snowden)

They turned a trillion dollars of devices into iNarcs—*without asking.* https://t.co/wIMWijIjJk

AIによる自動検知が行われる以前にも児童ポルノによる誤逮捕は発生しており、過去には孫の写真を保存していた祖父が起訴される事件も起こっています。

孫が水浴びしている写真をパソコンの中に保存したおじいさん、児童ポルノ単純所持の罪で警察に捕まり起訴される - GIGAZINE

・関連記事

SNSのやりとりに児童ポルノがないかを企業にチェックさせる法律がEUで可決、「かえって子どもを傷つける」との批判も - GIGAZINE

児童ポルノなどの違法コンテンツの「24時間以内の削除義務」をFacebook・Twitterなどに課す新規制をカナダが提案、違反時は最大で「全世界総売上の5%」が罰金 - GIGAZINE

AppleがiPhoneの写真やメッセージをスキャンして児童の性的搾取を防ぐと発表、電子フロンティア財団などから「ユーザーのセキュリティとプライバシーを損なう」という抗議の声も - GIGAZINE

Appleが発表した児童の性的搾取を防ぐための「iPhoneの写真やメッセージをスキャンする取り組み」は国ごとの法律にのっとり行われる予定 - GIGAZINE

「児童ポルノを検出するためにメッセージやチャットを企業がスキャンする試み」に海賊党議員が猛反対 - GIGAZINE

Appleが「児童性的虐待資料検出はプライバシーを損なうものではない」とFAQを発表 - GIGAZINE

Appleが表明した「iPhoneの写真・メッセージスキャン」については社内からも懸念の声が挙がっている - GIGAZINE

Appleが非難殺到の「iPhone内の児童ポルノ検出システム」について詳細説明資料を新たに公表 - GIGAZINE

Appleの「iPhoneの写真やメッセージをスキャンする施策」が世界各国の監視&検閲の強化につながるとの指摘 - GIGAZINE

世界中から猛反発を受けるAppleの「iPhone内の児童ポルノ検知システム」には大きな穴があることが判明 - GIGAZINE

・関連コンテンツ