人工知能に偏見を抱かせないようにするための方法とは?

Google検索やショッピング、データ分析や詐欺の検出まで、人工知能(AI)は我々の生活のさまざまな場面で役立っています。AIは人間により設定されたデータを使って機械学習を繰り返し、データ分析の精度を高めていきますが、機械学習に用いるデータが不足していたり、データに偏見が混じったものが存在する場合、何度も学習することで偏見が深まってしまうという問題があります。このアルゴリズムバイアスと呼ばれる偏見について、原因を特定して問題を改善する方法をAIの研究機関「Gradient Institute」の最高経営者であるBill Simpson-Young氏らが発表しています。

Artificial intelligence can deepen social inequality. Here are 5 ways to help prevent this

https://theconversation.com/artificial-intelligence-can-deepen-social-inequality-here-are-5-ways-to-help-prevent-this-152226

Bill Simpson-Young氏らがアルゴリズムバイアスの原因の1つとして挙げているのが、不適切なシステム設計です。例えば銀行が融資先を決める際に使用するAIは通常、銀行の以前の融資決定のデータセットを使用して学習を行います。AIは新しいローン申請者の財務路歴や雇用履歴をチェックして過去のデータと対照させ、申請者がローンを返済できるかどうかを予測しようとします。しかし、過去のデータに「行員が自身の偏見によって融資の拒否を行った」というパターンが含まれていた場合、AIはこれを偏見によるものとは認識できないまま学習してしまい、間違った決断を下してしまうかもしれません。ここでいう「偏見」とは年齢や性別、人種などのことで、「今ではあまり見られなくなった偏見」がAIに影響を与える恐れすらあるとのこと。

こういったアルゴリズムバイアスは銀行にも大きなリスクをもたらします。競合他社の手に渡らせてしまうリスク。もう一つは同じAIによる決断を繰り返した場合、偏見のパターンが政府や消費者に露呈してしまい、訴訟などにつながるリスクです。

Bill Simpson-Young氏によると、アルゴリズムバイアスを修正するための方法は以下の5つです。

◆1:より良いデータを取得する

今まで取得してこなかった情報を取得すること。特にマイノリティグループや不正確な結果が表示される人のデータを新たに取得します。

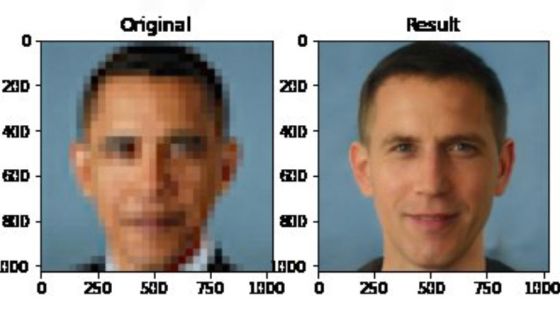

◆2:データセットを修正する

年齢、性別、人種など、差別とみなされる情報を削除、もしくは表示させないようにします。

◆3:モデルをより複雑にする

単純なAIモデルは分析や決定が容易に行えますが、精度が低く、少数派よりも多数派を基準にしてしまう恐れがあります。

◆4:システムを変更する

AIのシステムは事前に制御パターンなどを変更することができるとのこと。マイノリティグループに異なるしきい値を設定することで、アルゴリズムバイアスを打ち消すように調整することができます。

◆5:予測モデルを変更する

適切な予測モデルを設定することは、アルゴリズムバイアスを減らすことに役立ちます。

Bill Simpson-Young氏らは、AIによる意志決定を採用したい政府や企業は公平性と人権の一般原則を考慮しなければいけないと述べ、アルゴリズムバイアスによって不適切な結果が発生しないように、綿密にシステムを設計し監視する必要があると主張。AIによる意志決定が一般的になりつつある今、我々は生産性を向上させるだけでなく、より公平な社会を構築する必要があると締めくくっています。

・関連記事

人種に関するデータが存在しない医療システムで人種差別が行われてしまった理由とは? - GIGAZINE

AIの先祖である「書類選考用アルゴリズム」もまた人種・女性差別的だったという事実 - GIGAZINE

高度に発達したAIを人間が制御することは可能なのか? - GIGAZINE

AIを人類にとって有益なものとして扱うために必要なこととは? - GIGAZINE

偽ニュースを人工知能を使って検出するプロジェクト「Fake News Challenge」 - GIGAZINE

・関連コンテンツ

in Posted by log1p_kr

You can read the machine translated English article here.