無料で商用利用可能なオープンモデル「Mixtral 8x22B」が登場、高いコーディングと数学の能力を持つ

GoogleやMetaの研究者によって設立されたAIスタートアップのMistral AIが、オープンソースの大規模言語モデル「Mixtral 8x22B」をリリースしました。モデルはオープンソースライセンスのApache 2.0で提供されており、商用利用も可能となっています。

Cheaper, Better, Faster, Stronger | Mistral AI | Frontier AI in your hands

https://mistral.ai/news/mixtral-8x22b/

Mixtral 8x22Bのモデルは4月10日に公式Xアカウントにて公表・配布されていましたが、詳細な情報は不明となっていました。今回はMixtral 8x22Bモデルについての公式リリースが発表されたというわけです。

Mistral AIが突如として新しい大規模言語モデル「8x22B MOE」を発表、コンテキスト長65kでパラメーターサイズは最大1760億か - GIGAZINE

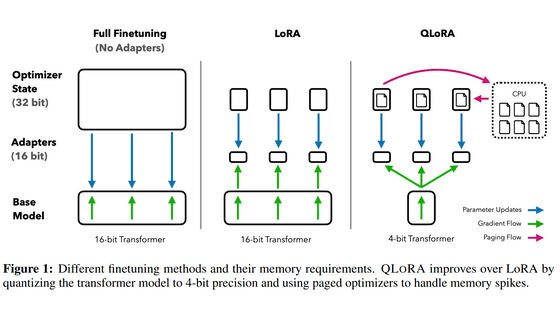

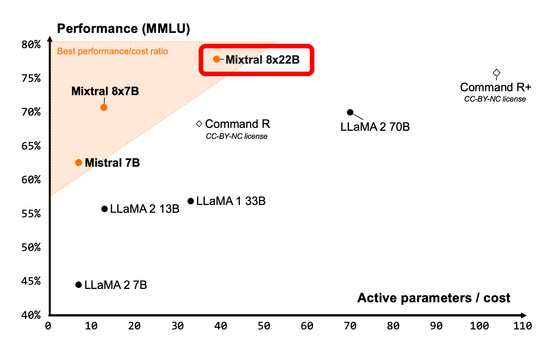

Mixtral 8x22Bは疎な専門家混合モデル(SMoE)となっており、推論ごとに1410億(141B)のうち390億(39B)パラメーターだけを使用することでパラメーターのサイズに比べてはるかに優れたコスト効率をたたき出しています。

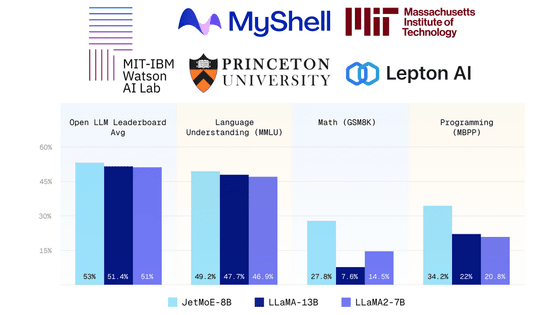

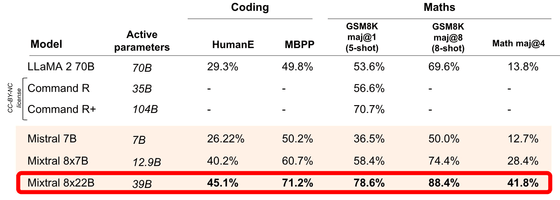

ウェイトが公開されている主要なオープンモデルとのコストパフォーマンスの比較は下図の通り。今回リリースされたMixtral 8x22Bはコストであるアクティブパラメーターの数を抑えつつ高いパフォーマンスを維持できていることが分かります。

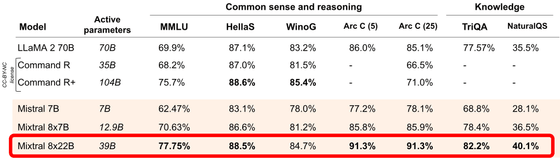

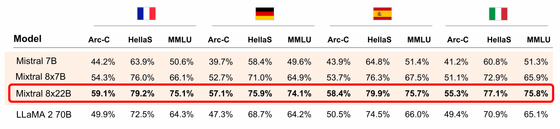

主要オープンモデルとのベンチマークの比較は下図の通り。ほとんどの指標でこれまでのモデルを上回りました。

Mixtral 8x22Bは英語以外にも「フランス語」「イタリア語」「ドイツ語」「スペイン語」に対応しています。英語以外の言語でもMistral AIがリリースした過去のモデルやLLaMA 2 70Bなどを超える性能を発揮しているとのこと。

また、強力な数学やコーディングの能力を備えています。

Mixtral 8x22Bはネイティブな関数呼び出しが可能で、コンテキストウィンドウは6万4000(64K)トークンとのこと。モデルはオープンソースライセンスのApache 2.0で公開されるため、無料で商用利用することが可能となっています。

・関連記事

Googleがオープンかつ商用利用可能な大規模言語モデル「Gemma」ファミリーにコード補完・生成・命令フォローを強化した「CodeGemma」と効率を最適化した「RecurrentGemma」を追加すると発表 - GIGAZINE

高解像度のAI画像を0.5秒で吐き出すオープンソースの画像生成モデル「PixArt-δ」が登場 - GIGAZINE

英語やその他言語の処理でLlama-2を超えたAIモデル「EagleX」がオープンソースで登場 - GIGAZINE

Databricksがオープンな大規模言語モデル「DBRX」をリリース、GPT-3.5やCodeLLaMA-70Bを上回る性能 - GIGAZINE

イーロン・マスクのチャットAI「Grok」がついにオープンソース化、他のオープンソースモデルより格段に優れているとの指摘も - GIGAZINE

・関連コンテンツ