目に見える情報から「見えない部分」を推測して3Dモデルを生成する「GQN」

人がテーブルの天板と3本の脚の存在を目で確認すると、「後ろに4本目の足がある」と頭の中で勝手に推測するものです。このような作業は人間にとっては容易なものですが、人工知能にとっては非常に困難な作業だとされています。Googleの親会社Alphabet傘下のAI企業DeepMindは視認できる情報から目で見えない部分を推測する「Generative Query Network(GQN)」を開発しました。

Neural scene representation and rendering | Science

http://science.sciencemag.org/content/360/6394/1204.full

Neural scene representation and rendering | DeepMind

https://deepmind.com/blog/neural-scene-representation/

GQNは入力された画像から物体の形状と位置関係を予想し、3D空間を生成するというものです。GQNの仕組みについては、DeepMindが以下のムービーで解説しています。

Generative Query Networks - YouTube

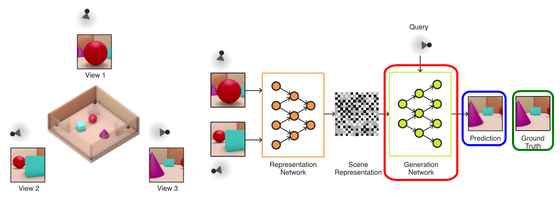

ここでは、画像の赤枠部分にある「四方を木枠で囲まれた赤い球体とターコイズブルーの立方体、紫の円すいの3つが配置された」実際のモデルを準備します。GQNには、このモデル上の2つの視点で撮影した画像のみを入力し、このモデルと同じ3Dモデルを推測させてみます。

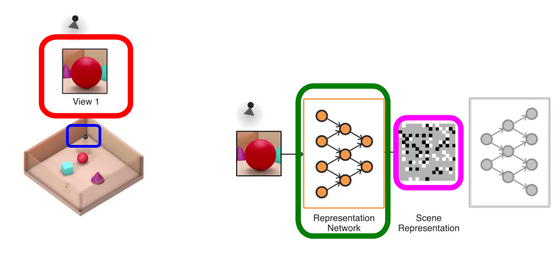

まず、赤枠のように赤い球体が手前に見える位置にカメラを配置(青枠)し写真を撮影します。この画像をGQNに入力すると、緑枠のRepresentation Network(表現ネットワーク)でモデルの組み立てが行われ、ピンク枠のScene Representation(シーン表現)でモデルの解析を実施します。「シーン表現」の灰色部分は未知の箇所を示しており、この時点では灰色の部分が大半を占めていることがわかります。GQNが生成する3Dモデルは1枚の画像からでも生成可能ですが、未知の箇所が多いと、物体の大きさが横長になったり、壁が存在していなかったりするなど、生成されるモデルの形状が安定しないそうです。

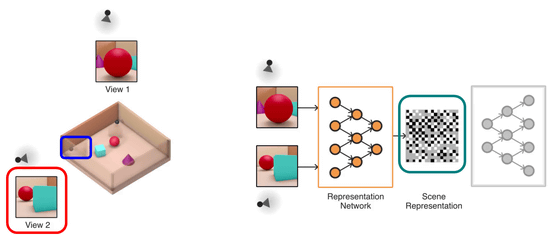

次に、赤枠のようにターコイズブルーの立方体が手前、奥に赤い球体が見える位置に青枠のカメラを配置して、カメラから見える画像をGQNに読み込ませます。すると、GQNで読み込まれる情報が増えることで、緑枠の「シーン表現」で未知の箇所を示す灰色部分の数が減少します。

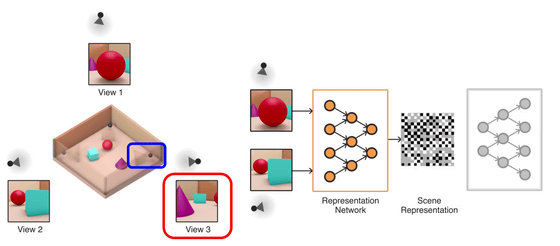

ここで、青枠の位置にカメラを置いた場合を想定して、紫の円すいが手前に来る位置の画像(赤枠)をGQNに推測させてみます。

すると、GQNは「シーン表現」で解析された情報を元にGeneration Network(生成ネットワーク)が3Dモデルを生成し、指定の位置にカメラを置いたときの画像(青枠)を作り出します。実際の画像は緑枠のものですが、同一の画像が生成されていることがわかります。

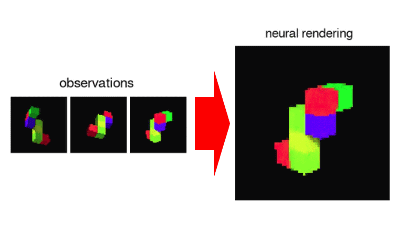

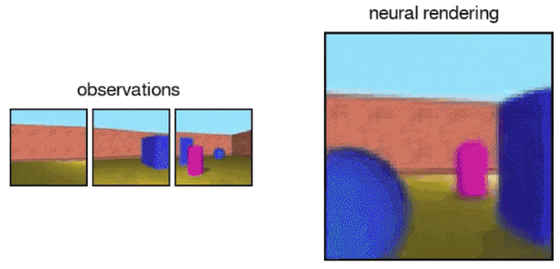

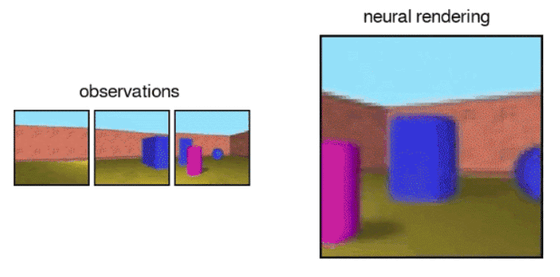

また、GQNで生成した3D空間は指定した視点以外にも、好きな視点で見ることができます。例えば、以下の「observations(観測)」にある画像が入力されると、GQNは「neural rendering(ニューラル表現)」に予測した3D空間を生成すると……

FPSのゲームを行っているかのように視点の位置をシームレスに変えることが可能です。

DeepMindによると、記事作成時点のGQNでは解像度の低いモデルのみが作成可能であるとしています。しかし、今後のハードウェアの進歩などによって、GQNでより高解像度のモデルにも対応可能になるとしており、VRやARへの応用も視野に入れているとのことです。

・関連記事

脳の持つナビゲーションシステムを人工ニューラルネットワークが再現 - GIGAZINE

Googleの人工知能部門DeepMindがイギリスの電力コストをインフラ整備なしで10%もカットする - GIGAZINE

ディープラーニングでリアルタイムに声をボカロのものに変換する試み - GIGAZINE

研究者でない一般人がAIについて本当に考えるべきこととは? - GIGAZINE

AIを使ってAV女優の顔部分に有名女優やゲームキャラクターを合成する「フェイクポルノ」が急増中、YouTuberやゲーム配信者など「インターネット上の有名人」はターゲットにされる可能性アリ - GIGAZINE

・関連コンテンツ